Der KI-Forscher Stuart Russell warnt vor den Gefahren Künstlicher Intelligenz. Sowas kommt häufiger vor. Aber Russell hat vielleicht eine Lösung.

Der britische Forscher Stuart Russell ist eine Autorität in der KI-Forschung: Zusammen mit Peter Norvig hat er das englischsprachige Standardwerk "Artificial Intelligence: A Modern Approach" zu Künstlicher Intelligenz geschrieben.

Nun hat er ein Buch über die Gefahren einer künstlichen Superintelligenz verfasst: "Human Compatible: Artificial Intelligence and the Problem of Control".

Wie der schwedische Philosoph Nick Bostrom in seinem Buch "Superintelligenz", beschäftigt sich Russell mit dem Kontrollproblem Künstlicher Intelligenz, also der Frage, wie die Menschheit eine überlegene KI kontrollieren könnte.

Die naheliegende Antwort lautet: Gar nicht.

Aus dieser Erkenntnis folgt die Notwendigkeit, die Ziele einer Super-KI mit menschlichen Werten zu vereinbaren. Diese Herausforderung bezeichnen Fachleute als Ausrichtungsproblem. Nur wenn die KI entlang menschlicher Ziele agiert, kann die Menschheit sicherstellen, dass die Super-KI für und nicht gegen sie arbeitet.

Das Gorilla-Problem

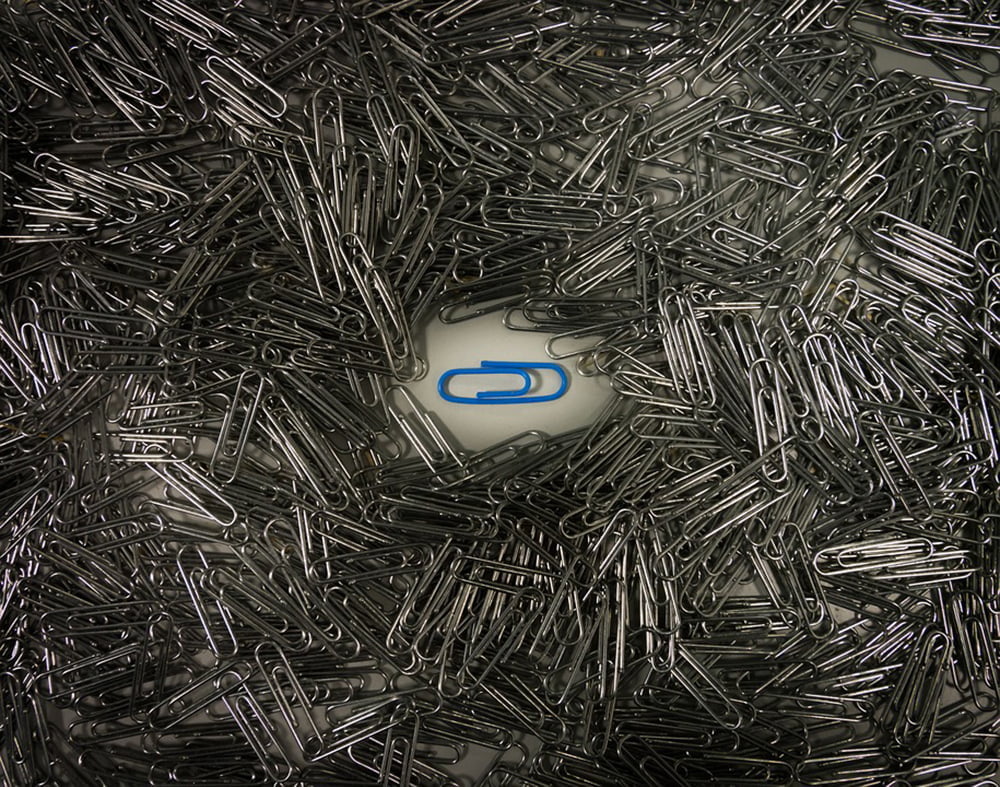

Doch Beispiele wie der Paperclip Maximizer zeigen, wie komplex diese Ausrichtung ist: In dem Beispiel soll eine Super-KI möglichst viele Büroklammern herstellen.

Die KI erkennt schnell, dass es besser wäre, wenn es keine Menschen gäbe, da Menschen sich entscheiden könnten, sie auszuschalten - dann könnte sie ihr Ziel nicht mehr erfüllen. Hinzu kommt, dass sie aus menschlichen Molekülen neue Büroklammern herstellen kann.

So übernimmt sie am Ende die Herrschaft über die Welt und löscht die Menschheit aus. Aus dem harmlosen Ziel, möglichst viele Büroklammern herzustellen, folgen gefährliche instrumentelle Ziele, also Ziele, die sich die KI auf dem Weg zur Büroklammerallmacht selbst setzt.

Die Herausforderung, menschliche Vormachtstellung und Autonomie in einer Welt, die Maschinen mit wesentlich höherer Intelligenz umfasst, zu bewahren, bezeichnet Russell als "Gorilla-Problem". Denn Gorillas sind wohl nicht sonderlich glücklich darüber, dass ihr Schicksal von unseren Entscheidungen abhängt.

Natürlich existiert ein großer Unterschied in der Ungleichheit zwischen Mensch und Gorilla und zwischen Mensch und Super-KI – denn Menschen entwickeln die ihnen überlegenen Systeme selbst.

Also könnten Menschen doch einfach auf die Entwicklung eine Super-KI verzichten. Das hält Russell für unwahrscheinlich, denn besonders das wirtschaftliche Versprechen einer Super-KI ist einfach zu verlockend: Der Mensch könnte von unangenehmer Arbeit befreit werden, Dienstleistungen und Produkte würden günstiger. Russell schreibt, das weltweite Bruttoinlandsprodukt könne um das Zehnfache steigen und Armut ausgelöscht werden.

Wenn da nur nicht das Drohszenario einer KI wäre, die die Menschheit vorher abmurkst. Doch Russell hat eine Idee, wie wir unserem Ende vielleicht entkommen können.

König Midas, Gold und falsche Wünsche

In der Legende des König Midas wünscht sich der Herrscher, das alles, was er anfasst, zu Gold wird. Leider gilt das auch für seine Tochter und Nahrung.

In der KI-Forschung wird die Legende häufig als Beispiel für ein schlecht spezifiziertes Ziel zitiert - und damit als Paradebeispiel des Ausrichtungsproblems.

Russell spricht ebenfalls vom "König-Midas-Problem" und entdeckt es in der Ausrichtung aktueller KI-Systeme, die für ein spezielles Ziel trainiert werden. Ist dieses Ziel nicht eindeutig und präzise formuliert und werden nicht alle möglichen Pfade zur Zielerreichung durchdacht, kann das in einer KI-Katastrophe enden.

Die vermeintlich nutzerfreundlichen Empfehlungsalgorithmen von Facebook oder YouTube zum Beispiel, die auf maximale Klicks optimieren, fördern kontroverse Inhalte, Filterblasen und im schlimmsten Fall Radikalisierung. Und auch der Paperclip Maximizer wollte nur Büroklammern herstellen. Die Auslöschung der Menschheit ist ein unangenehmer Nebeneffekt.

Die Disney-Adaption von Goethes "Der Zauberlehrling" zeigt ebenfalls, was passiert, wenn ein Ziel nicht genau gesetzt wird. Hier ist der Übeltäter keine KI, sondern ein Wischmop.

Wenn der Mensch sich nicht versteht, dann wenigstens die KI?

Laut Russell vergessen wir, dass die Maschine in erster Linie nur ein Ziel haben sollte – nämlich nützlich zu sein. Nützlich sind Maschinen laut Russell dann, wenn ihre Handlungen unsere Zielsetzungen erreichen.

Das Problem sei es, dass Menschen häufig nicht wüssten, was sie wollen. Dadurch käme eine unpräzise Zielsetzung samt unangenehmer Konsequenzen überhaupt erst zustande. Laut Russell liegt in der Unkenntnis der eigenen Wünsche jedoch die Lösung für das Gorilla-Problem.

Er schlägt vor, dass sich eine KI eigenständig Ziele sucht, die sie aus unseren Vorlieben und Wünschen ableitet. Wenn sie sich verändern, soll die KI ihre Ziele passend justieren. So bleibt auch eine unsterbliche Super-KI in Zukunft noch am Menschen interessiert und passt sich etwa ändernden moralischen Vorstellungen an.

Russell schlägt konkret drei Gestaltungsprinzipien für KI-Systeme vor:

- Das einzige Ziel der Maschine ist es, menschliche Vorlieben zu unterstützen.

- Die Maschine ist sich zunächst nicht sicher, was diese Vorlieben sind.

- Die ultimative Informationsquelle über menschliche Vorlieben ist das menschliche Verhalten.

Russell ist zuversichtlich, dass der Wechsel zum neuen KI-Design gelingen kann, denn das Erlernen menschlicher Vorlieben sei bereits jetzt Betätigungsfeld von KI-Systemen, beispielsweise in Form der zuvor erwähnten Empfehlungsalgorithmen. Kleine Verbesserungen an diesen Algorithmen bringen schon jetzt Millionen US-Dollar Gewinn – obwohl ihre Vorhersagekraft eingeschränkt sei, so Russell.

KI-Systeme, die die Erkundung menschlicher Vorlieben als höchstes Ziel haben, könnten so in einem ersten Schritt YouTube, Social Media oder KI-Assistenten noch stärker personalisieren und ihren Betreibern hohe Profite bescheren – und vielleicht in Zukunft unsere Auslöschung verhindern.

Titelbild: YouTube, Quellen: Human Compatible, Vox