Google hat mit Gemini 1.5 das erste große Update für seine KI-Modelle vorgestellt. Wichtigstes Feature: Ein extrem großes Kontextfenster, das die Konkurrenz deutlich übertrifft.

Laut Google verfügt Gemini 1.5 über eine neue Mixture-of-Experts (MoE)-Architektur, die das Training und die Bereitstellung effizienter macht. Demis Hassabis, CEO von Google DeepMind, betonte an, dass Gemini 1.5 Pro, das erste Modell dieser neuen Generation, eine vergleichbare Leistung wie Gemini 1.0 Ultra bieten kann, aber weniger Rechenleistung benötigt.

Das wichtigste Merkmal von Gemini 1.5 ist das lange Kontextfenster: Gemini 1.5 Pro, das erste Modell, das veröffentlicht wird, wird mit einem Standard-Kontextfenster von 128.000 Token ausgeliefert. Eine begrenzte Gruppe von Entwicklern und Unternehmenskunden wird jedoch frühzeitig Zugang zu einer Version erhalten, die bis zu 1 Million Token verarbeiten kann.

Laut Google können damit riesige Datenmengen verarbeitet werden - zum Beispiel eine Stunde Video, 11 Stunden Audio, Codebases mit mehr als 30.000 Zeilen oder Dokumente mit mehr als 700.000 Wörtern.

Zum Vergleich: OpenAIs GPT-4 Turbo hat 128.000 Token und Anthropics Claude 2.1 hat 200.000 Token. Google Research hat das Modell zudem mit bis zu 10 Millionen Token getestet.

Bemerkenswert ist, dass Gemini 1.5 Pro im "Needle In A Haystack"-Test den Zieltext in 99 % der Fälle innerhalb von Datenblöcken mit bis zu 1 Million Token fand und damit das "Lost In The Middle"-Phänomen adressiert.

Es erreicht etwa eine perfekte Genauigkeit beim Auffinden von versteckten Schlüsselwörtern in Audiodaten, die fast einen ganzen Tag umfassen. Es findet auch effektiv Informationen in zufälligen Frames innerhalb eines dreistündigen Videos, schreibt Googles Gemini-Team in seinem technischen Bericht.

Gemini 1.5 Pro rückt näher an Gemini 1.0 Ultra heran

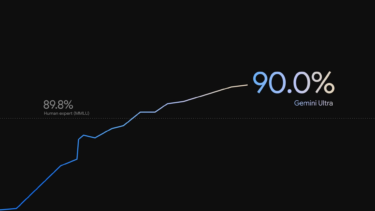

Die Kernfähigkeiten von Gemini 1.5 Pro decken ein breites Spektrum von Benchmarks in den Modalitäten Text, Code, Bild, Video und Audio ab. Google gibt an, dass Gemini 1.5 Pro gegenüber Gemini 1.0 Pro eine Gewinnrate von 87,1 % und gegenüber Gemini 1.0 Ultra eine Gewinnrate von 54,8 % aufweist, basierend auf 31 Benchmarks.

Das neue Modell weist Verbesserungen in verschiedenen Bereichen auf, darunter Mathematik, Naturwissenschaften und logisches Denken, Mehrsprachigkeit, Videoverständnis und Code.

Entwickler und Unternehmenskunden können über AI Studio und Vertex AI auf eine eingeschränkte Vorschau von Gemini 1.5 Pro zugreifen. Google bietet diese Vorschau während der Testphase kostenlos an, die Nutzer müssen jedoch mit längeren Latenzzeiten für die experimentelle Funktion rechnen. Google plant, in Zukunft Preisstufen einzuführen, die sich nach der Größe des Kontextfensters des Modells richten.

"Wir werden 1.5 Pro mit einem Standardkontextfenster von 128.000 Token einführen, wenn das Modell für eine breitere Veröffentlichung bereit ist. In naher Zukunft planen wir die Einführung von Preisstufen, die mit dem Standard-Kontextfenster von 128.000 Token beginnen und bis zu 1 Million Token skalieren, während wir das Modell verbessern", sagt Jeff Dean, Google DeepMinds Chief Scientist.

Sollte es Google gelingen, die Genauigkeit und Leistungsfähigkeit der Modellfamilie Gemini 1.5 mit einer Million oder sogar zehn Millionen Token-Kontextfenstern in experimentellen Modellen beizubehalten, könnten diese wohl zahlreiche neue Anwendungen für multimodale Modelle in der Wissenschaft und anderen Bereichen ermöglichen.

Gemini 1.5 zeigt aber auch, dass Google in der Lage ist, seine Gemini-Familie relativ schnell weiterzuentwickeln, und das KI-Wettrennen zwischen Google, OpenAI und Microsoft gerade erst begonnen hat.