GLIGEN: Neue Methode gibt mehr Kontrolle über KI-Bild-Generation

Wo welches Objekt in einem KI-Bild positioniert sein soll, lässt sich bei aktuellen Modellen nur mit Text beschreiben - mit mäßigem Erfolg. Forschende zeigen nun ein Modell, das etwa Bounding-Boxen nutzt.

Die KI-Bildgenerierung hat sich rasant von diffusen Visualisierungen zu sehr konkreten, teilweise sogar fotorealistischen Ergebnissen entwickelt. Dabei gilt: Je detaillierter die Vorgabe, desto besser kann die Generierung beeinflusst werden. Zwar lassen sich auch Details der Bildkomposition mit Text beschreiben, etwa wo welches Objekt platziert werden soll, doch werden diese Details oft nur mäßig umgesetzt. Eine neue Methode könnte dies in Zukunft vereinfachen.

Wissenschaftler:innen der University of Wisconsin-Madison, Columbia University und von Microsoft haben GLIGEN vorgestellt, was für "Grounded-Language-to-Image Generation" steht. Bis auf wenige Ausnahmen wie Stable Diffusion 2.0 können Bildmodelle nur per Text gesteuert werden. GLIGEN nutzt dagegen zusätzlich sogenannte "grounding inputs".

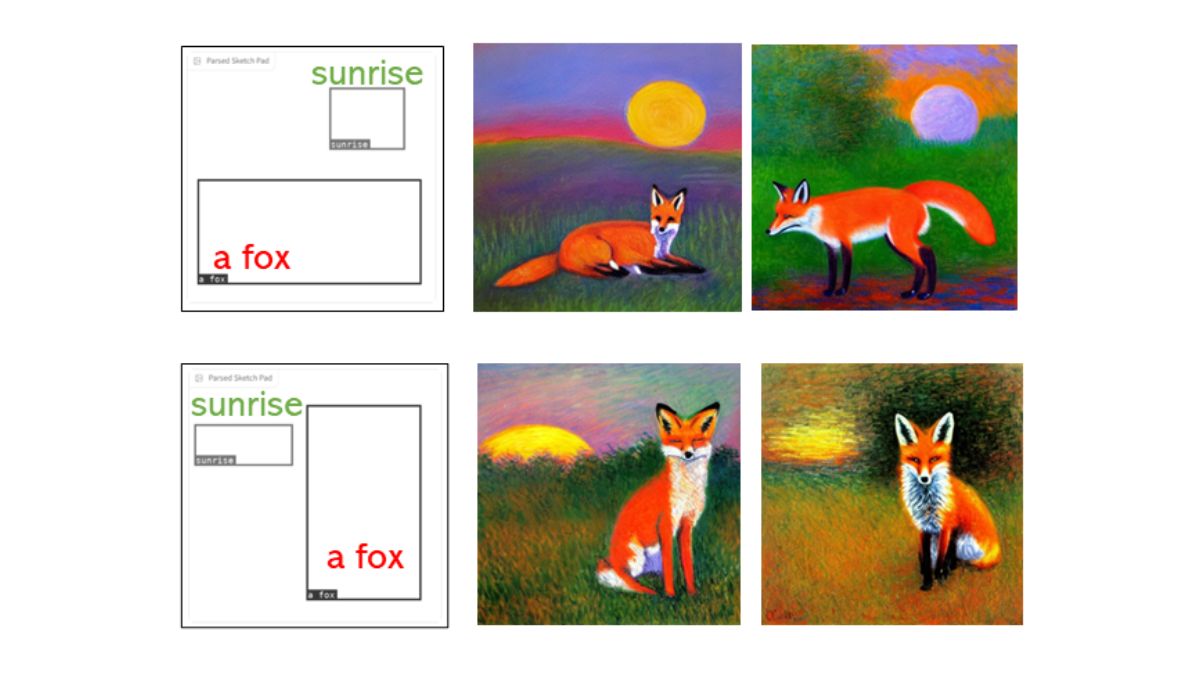

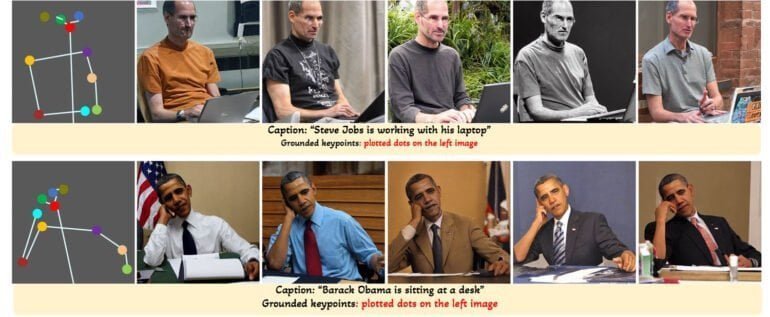

Positionsangaben durch Boxen oder Keypoints

"Grounding" bezieht sich hier auf die Fähigkeit eines Modells, visuelle Informationen einzubeziehen. Im Kontext von GLIGEN bedeutet das: Das KI-Modell nutzt neben Text-Eingabe auch visuelle Informationen, etwa die Position und Größe von Bounding-Boxen.

Die Boxen können sich überlappen, anhand von Img2Img durch ein Referenzbild noch konkretere Angaben erhalten und per Inpainting bestehenden Bildern hinzugefügt werden. Zur Generation von Bildern mit Menschen lassen sich zudem Keypoints festlegen, die die Körperhaltung der Person widerspiegeln und die Bildsynthese entsprechend anleiten.

Trainingsschicht "wie bei Lego" über dem Modell

Für das Training werden bei GLIGEN alle Gewichte des zugrundeliegenden Bildmodells eingefroren und die Grounding-Informationen über Box-Text-Bildpaare in neuen Schichten trainiert. So stellen die Forschenden sicher, dass die Fähigkeiten des vortrainierten Modells erhalten bleiben.

Im Vergleich zu anderen Methoden die etwa ein vortrainiertes Modell komplett feinjustieren, werden unsere neu hinzugefügten Schichten kontinuierlich auf großen Grounding-Daten vortrainiert und sind kostengünstiger. Wie bei Lego kann man verschiedene trainierte Schichten zusammenstecken und herumspielen, um verschiedene neue Fähigkeiten zu aktivieren.

Li et al.

GLIGEN ähnelt damit dem kürzlich veröffentlichten ControlNet, das jedoch noch weitere Kontrollmöglichkeiten bietet. Diese Methoden erlauben so Nutzer:innen deutlich mehr Einfluss auf das Ergebnis von KI-Bildgeneratoren und Bilder präzise nach ihren Wünschen zu generieren.

Auf Hugging Face könnt ihr GLIGEN kostenlos im Browser ausprobieren, in einer Anwendung für ein Bildmodell wie Stable Diffusion ist es jedoch noch nicht gelandet.

KI-News ohne Hype – von Menschen kuratiert

Mit dem THE‑DECODER‑Abo liest du werbefrei und wirst Teil unserer Community: Diskutiere im Kommentarsystem, erhalte unseren wöchentlichen KI‑Newsletter, 6× im Jahr den „KI Radar"‑Frontier‑Newsletter mit den neuesten Entwicklungen aus der Spitze der KI‑Forschung, bis zu 25 % Rabatt auf KI Pro‑Events und Zugriff auf das komplette Archiv der letzten zehn Jahre.

Jetzt abonnierenKI-News ohne Hype

Von Menschen kuratiert.

- Mehr als 20 Prozent Launch-Rabatt.

- Lesen ohne Ablenkung – keine Google-Werbebanner.

- Zugang zum Kommentarsystem und Austausch mit der Community.

- Wöchentlicher KI-Newsletter.

- 6× jährlich: „KI Radar“ – Deep-Dives zu den wichtigsten KI-Themen.

- Bis zu 25 % Rabatt auf KI Pro Online-Events.

- Zugang zum kompletten Archiv der letzten zehn Jahre.

- Die neuesten KI‑Infos von The Decoder – klar und auf den Punkt.