Version 2.0 von Stable Diffusion bringt zahlreiche Verbesserungen. Die wichtigste Neuerung ist das verbesserte Text-zu-Bild-Modell OpenCLIP.

Im August 2022 veröffentlichte das KI-Start-up Stability AI gemeinsam mit RunwayML, der LMU München sowie EleutherAI und LAION die Open Source Bild-KI Stable Diffusion, die auf Anhieb großen Anklang in der Fachgemeinschaft fand.

Stable Diffusion kann gegen Bezahlung und mit Inhalte-Filtern online oder heruntergeladen und lokal kostenlos ohne inhaltliche Einschränkungen genutzt werden. Version 2.0 führt diesen Open-Source-Ansatz fort. Federführend ist Stability AI.

Verbesserter Text-Encoder und neue Bild-Modi

Für Version 2.0 verwendete das Team OpenCLIP (Contrastive Language–Image Pre-training), eine verbesserte Version des multimodales KI-Systems, das selbstüberwacht visuelle Konzepte aus natürlicher Sprache lernt. OpenCLIP wurde Mitte September von LAION in drei Versionen veröffentlicht und jetzt in Stable Diffusion implementiert. Stability AI unterstützte das Training von OpenCLIP. CLIP-Modelle können Repräsentationen von Bildern und Texten als Embeddings berechnen und ihre Ähnlichkeit vergleichen. Auf diese Art kann ein KI-System das zu einem Text passende Bild generieren.

Dank dieses neuen Text-Encoders soll Stable Diffusion 2.0 laut Stability AI deutlich bessere Bilder generieren im Vergleich zu Version 1.0. Das Modell kann Bilder in einer Auflösung von 512x512 und 769x768 Pixel generieren, die dann von einem ebenfalls neuen Upscaler Diffusion Modell auf bis zu 2048x2048 Pixel hochgerechnet werden.

Trainiert wurde das neue Open-CLIP-Modell mit einem von Stability AI zusammengestellten "ästhetischen Datensatz" auf Basis des LAION-5B Datensatzes. Sexuelle und pornografische Inhalte wurden zuvor gefiltert.

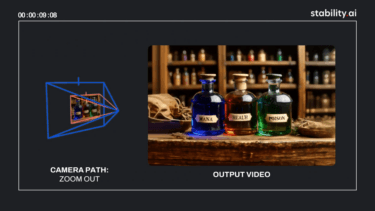

Neu ist ebenfalls ein Depth-to-Image-Modell, das die Tiefe eines Eingabebildes analysiert und dieses dann in Kombination mit einer Texteingabe in neue Motive mit den Konturen des Originalbildes verwandelt.

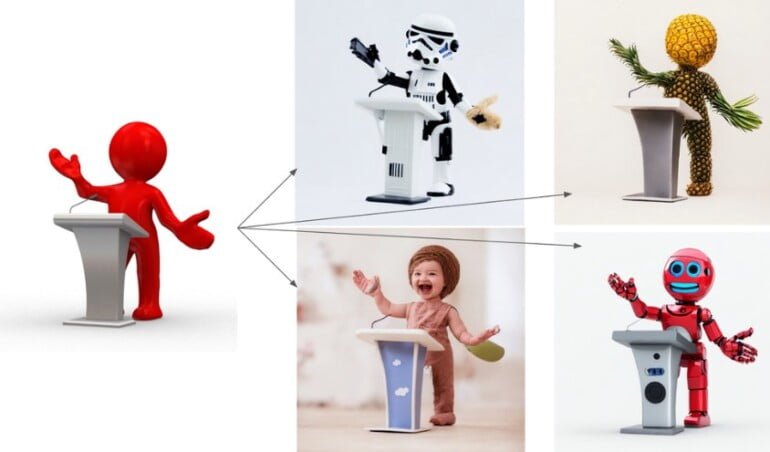

Stable Diffusion Version 2.0 bekommt zudem ein Inpainting-Modell, das innerhalb eines vorhandenen Bildes einzelne Bildelemente austauschen kann, etwa eine Mütze oder eine VR-Brille auf den Kopf malen.

Inpainting

Finally, we also include a new text-guided inpainting model, fine-tuned on the new Stable Diffusion 2.0 base text-to-image model, which makes it super easy to switch out parts of an image intelligently and quickly. pic.twitter.com/3fKng0ti3S

— Stability AI (@StabilityAI) November 24, 2022

Open Source als Erfolgsmodell

Stable Diffusion Version 2.0 soll trotz der zahlreichen Verbesserungen weiter lokal auf einer einzelnen leistungsfähigen Grafikkarte mit ausreichend Speicher ausführbar sein.

"Wir haben bereits gesehen, dass, wenn Millionen von Menschen diese Modelle in die Hände bekommen, sie gemeinsam einige wirklich erstaunliche Dinge erschaffen. Das ist die Stärke von Open Source: die Nutzung des enormen Potenzials von Millionen talentierter Menschen, die vielleicht nicht die Ressourcen haben, um ein hochmodernes Modell zu trainieren, die aber in der Lage sind, mit einem solchen Modell etwas Unglaubliches zu schaffen", schreibt Stability AI.

Weitere Informationen und Zugang zu den neuen Modellen gibt es bei Github. Sie sollen in den nächsten Tagen im Stable Diffusion Web-Interface Dreamstudio zur Verfügung stehen. Entwickler finden weitere Informationen in der API-Dokumentation von Stability AI.