Google Deepmind demonstriert Methode, mit der kleinere Bildmodelle größere übertreffen können

Eine neue Studie zeigt, wie die Qualität von KI-generierten Bildern durch Methoden verbessert werden kann, die von den jüngsten Reasoning-Modellen wie OpenAIs o1 inspiriert sind.

Wissenschaftler der NYU, des MIT und von Google haben Methoden entwickelt, mit denen die Qualität von KI-generierten Bildern während der Inferenz - also während der eigentlichen Bildgenerierung - deutlich verbessert werden kann. Streng genommen ist dies bereits bei Diffusionsmodellen der Fall, da das Bild mit den Denoising-Schritten besser wird.

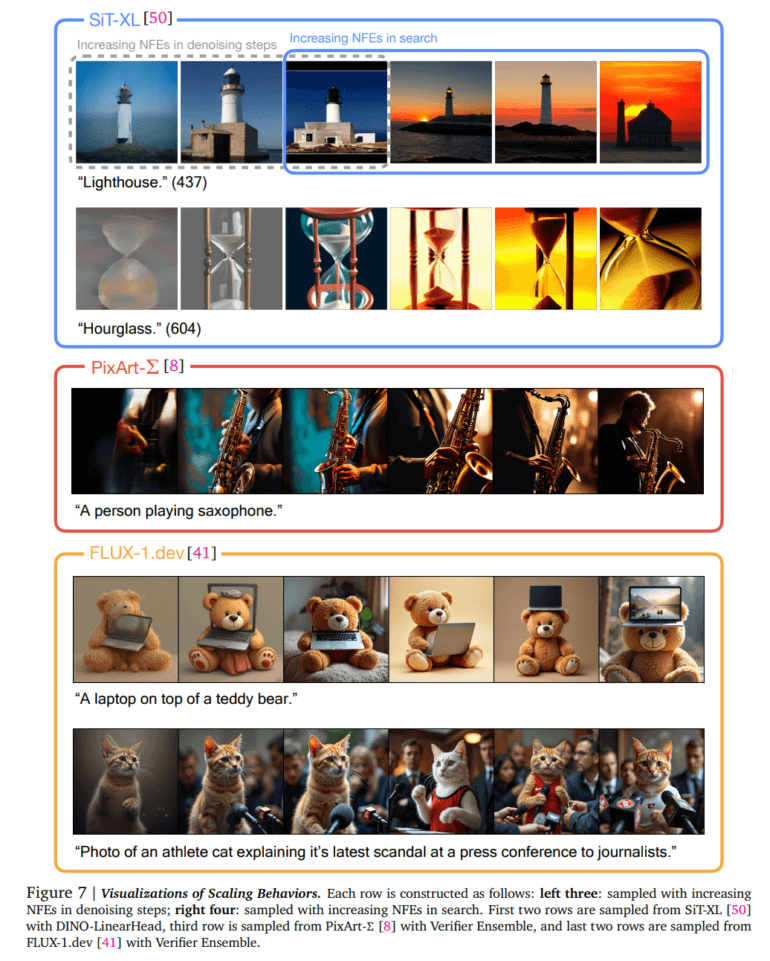

Das vorgestellte Paper "Inference-Time Scaling for Diffusion Models beyond Scaling Denoising Steps" geht darüber hinaus und basiert auf zwei Kernkomponenten: Verifiers (Bewertungssysteme) und Suchalgorithmen. Die Verifiers dienen als Qualitätsprüfer, die jedes generierte Bild nach bestimmten Kriterien bewerten. Die Algorithmen nutzen diese Bewertungen, um systematisch nach besseren Bildern zu suchen.

Das Besondere an dem Ansatz: Die Verbesserung erfolgt, ohne dass das KI-Modell neu trainiert werden muss. Stattdessen wird der Generierungsprozess selbst optimiert, ähnlich wie Modelle wie OpenAIs o1, Googles Gemini 2.0 Flash Thinking oder DeepSeeks R1 ihren Output während der Generierung durch "Nachdenken" optimieren.

Drei verschiedene Suchalgorithmen im Test

Die Verifier bewerten verschiedene Aspekte eines generierten Bildes. So prüft "Aesthetic Score" die visuelle Qualität des Bildes, "CLIPScore" bewertet, wie gut das Bild zum eingegebenen Text passt, und "ImageReward" wurde speziell darauf trainiert, die Bildqualität nach menschenähnlichen Kriterien zu bewerten. Diese verschiedenen Bewertungssysteme kombinierten die Forscher zu einem "Verifier Ensemble", das mehrere Qualitätsaspekte gleichzeitig berücksichtigt.

Für die Optimierung entwickelte das Team drei verschiedene Algorithmen: Random Search, Zero-Order Search und Search over Paths.

Random Search ist der einfachste Ansatz: Der Algorithmus erzeugt mehrere Versionen eines Bildes und wählt die beste aus. Das funktioniert laut dem Team überraschend gut, hat aber den Nachteil, dass bei zu vielen Versuchen zu ähnliche Bilder entstehen. Zero-Order Search hingegen beginnt mit einem zufälligen Bild und sucht dann systematisch in der "Nachbarschaft" dieses Bildes nach besseren Versionen.

Search over Paths ist der komplexeste Algorithmus: Er optimiert nicht nur das Endergebnis, sondern den gesamten Generierungsprozess. Während der Bilderstellung werden Verbesserungen an verschiedenen Denoising-Schritten vorgenommen und nach besseren Pfaden in der Generierung gesucht.

Inference-Time Scaling zeigt deutlich bessere Ergebnisse

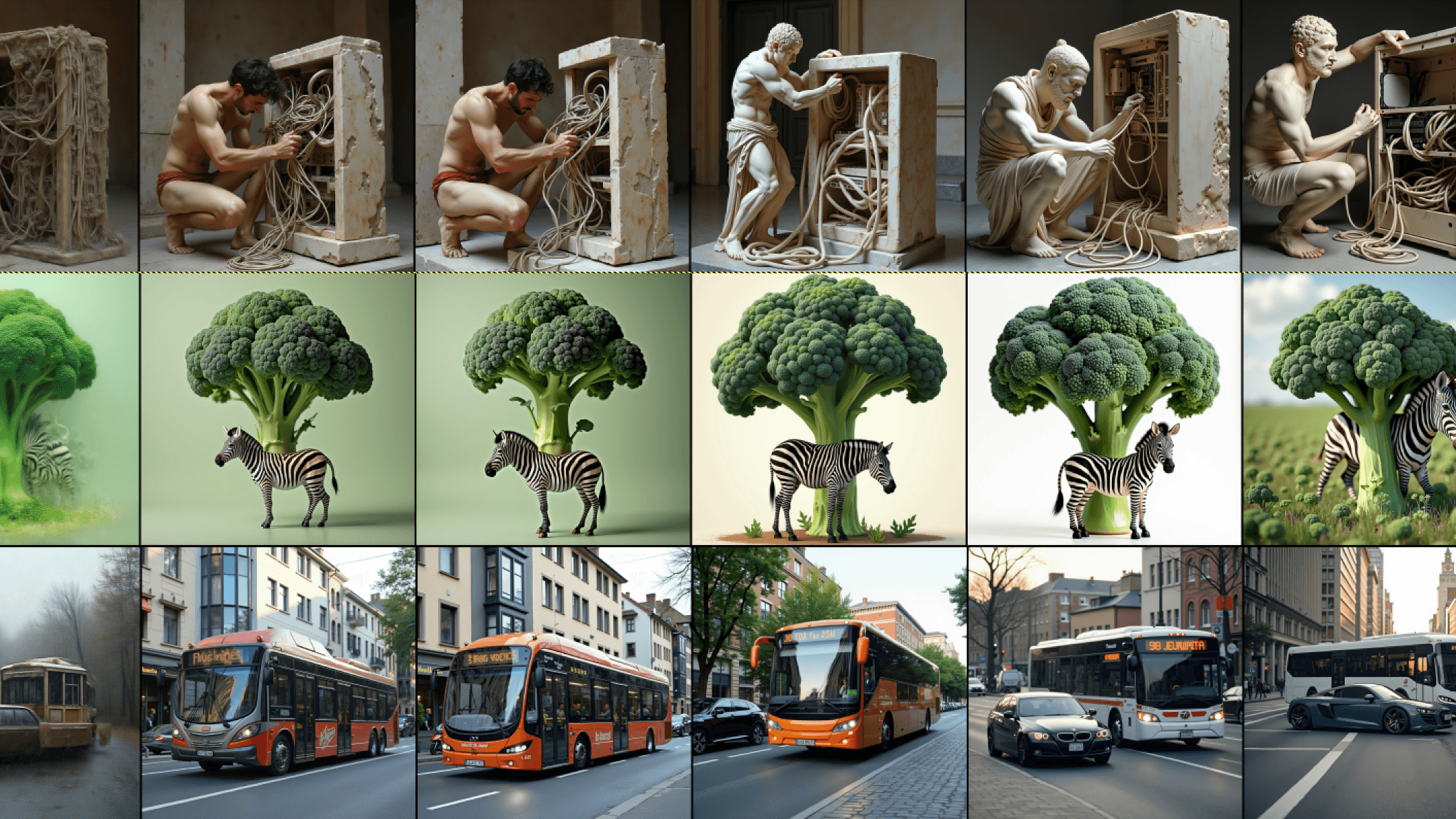

In Tests mit verschiedenen Bildmodellen zeigten alle drei Methoden signifikante Verbesserungen. Auch kleinere Modelle konnten durch die Optimierung bessere Ergebnisse erzielen als größere Modelle ohne diese Technik.

Allerdings gibt es einen Trade-off: Die Verbesserung der Bildqualität kostet zusätzliche Rechenzeit. Beim Random-Search-Verfahren werden beispielsweise mehrere Bilder erzeugt, von denen nur eines verwendet wird. Die Forscher fanden heraus, dass etwa 50 zusätzliche Rechenschritte pro Bild ein guter Kompromiss zwischen Qualität und Geschwindigkeit sind.

Die verschiedenen Prüfer haben auch unterschiedliche "Vorlieben". Während der Aesthetic Score Verifier zu künstlerisch stilisierten Bildern tendiert, bevorzugt der CLIPScore Verifier realistische Darstellungen, die genau dem Text entsprechen. Die Wahl des richtigen Verifiers hängt also vom gewünschten Ergebnis ab.

KI-News ohne Hype – von Menschen kuratiert

Mit dem THE‑DECODER‑Abo liest du werbefrei und wirst Teil unserer Community: Diskutiere im Kommentarsystem, erhalte unseren wöchentlichen KI‑Newsletter, 6× im Jahr den „KI Radar"‑Frontier‑Newsletter mit den neuesten Entwicklungen aus der Spitze der KI‑Forschung, bis zu 25 % Rabatt auf KI Pro‑Events und Zugriff auf das komplette Archiv der letzten zehn Jahre.

Jetzt abonnierenKI-News ohne Hype

Von Menschen kuratiert.

- Mehr als 20 Prozent Launch-Rabatt.

- Lesen ohne Ablenkung – keine Google-Werbebanner.

- Zugang zum Kommentarsystem und Austausch mit der Community.

- Wöchentlicher KI-Newsletter.

- 6× jährlich: „KI Radar“ – Deep-Dives zu den wichtigsten KI-Themen.

- Bis zu 25 % Rabatt auf KI Pro Online-Events.

- Zugang zum kompletten Archiv der letzten zehn Jahre.

- Die neuesten KI‑Infos von The Decoder – klar und auf den Punkt.