Google Deepminds neuer KI-Agent AlphaEvolve entwickelt eigenständig neue Algorithmen

Google DeepMind stellt mit AlphaEvolve ein System vor, das große Sprachmodelle für die automatisierte Algorithmenentwicklung einsetzt. Das System soll neue Algorithmen entwickeln, diese systematisch verbessern und praxistauglich machen.

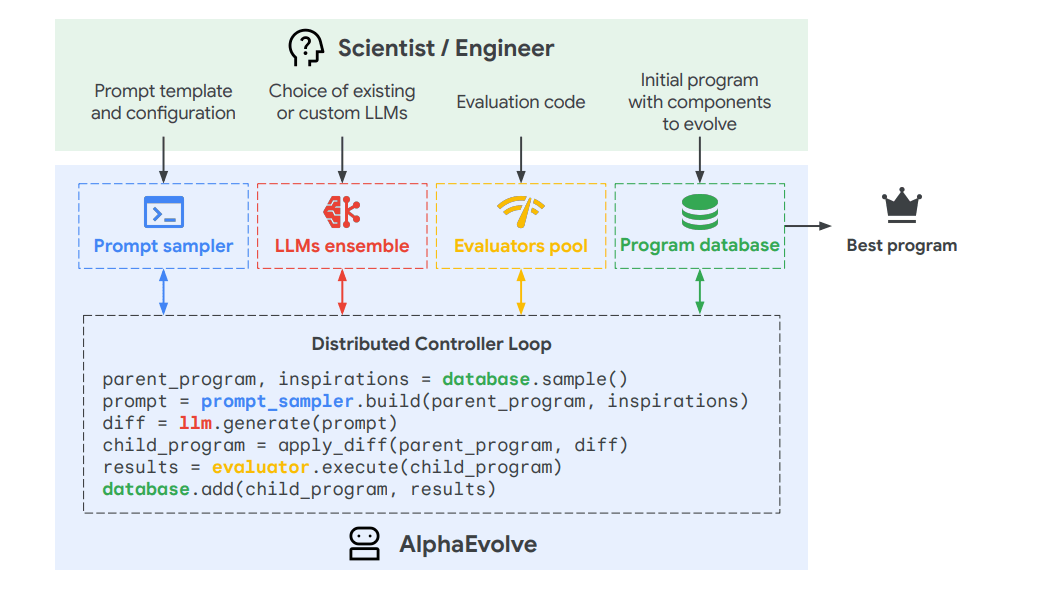

Die Funktionsweise von AlphaEvolve verbindet Sprachmodelle mit einem strukturierten Auswahlverfahren. Dabei kommen zwei Varianten der Gemini-Modelle zum Einsatz: Gemini Flash generiert verschiedene Programmvorschläge, während Gemini Pro diese vertieft analysiert. Ein evolutionärer Algorithmus bewertet die erzeugten Programme nach objektiven Kriterien wie Genauigkeit und Rechenaufwand. Die besten Varianten werden ausgewählt und kontinuierlich weiterentwickelt.

DeepMind beschreibt AlphaEvolve als "test-time compute agent" – ein KI-System, das zur Laufzeit neue Lösungswege erkundet und bewertet. Im Gegensatz zum klassischen Prompting erzeugt es keine einmalige Antwort, sondern eine adaptive Strategie, die sich über mehrere Durchläufe verbessert. Dieser Ansatz ähnelt den aktuellen Reasoning-Modellen.

Google DeepMind erklärt, dass die Fortschritte von AlphaEvolve auf die zugrundeliegenden Sprachmodelle übertragen werden können. Das geschieht durch sogenannte Distillation, bei der das gewonnene Wissen in kompaktere Modellversionen verdichtet wird.

Effizienzgewinne in der Google-Infrastruktur

Laut Google DeepMind kommt AlphaEvolve bereits in verschiedenen Bereichen der Google-Infrastruktur zum Einsatz. Für das Verwaltungssystem "Borg" entwickelte das System eine neue Heuristik zur Ressourcenverteilung, die 0,7 Prozent mehr Rechenleistung freisetzt. Das Unternehmen betont, dass diese Lösung von Menschen gut lesbar, nachvollziehbar und robust im Betrieb ist.

Bei der Optimierung des Gemini-Modells verbesserte AlphaEvolve die Zerlegung von Matrixmultiplikationen, was die Trainingszeit um ein Prozent verkürzte. Besonders bemerkenswert ist laut dem Unternehmen die Optimierung des FlashAttention-Kernels um bis zu 32,5 Prozent in Benchmarks.

Diese GPU-nahe Komponente spielt eine wichtige Rolle bei der Ausführung großer Sprachmodelle. Optimierungen dieser Art seien besonders anspruchsvoll, da sie tief im System verankert sind und von Menschen selten überarbeitet werden.

Zudem soll AlphaEvolve den Aufwand für solche Optimierungen deutlich reduzieren. Statt mehrwöchiger manueller Arbeit genügen nun wenige Tage automatisierter Experimente. Dies ermöglicht dem Unternehmen zufolge eine schnellere Anpassung an neue Hardware und senkt langfristig die Entwicklungskosten für KI-Systeme.

Fortschritte in der Mathematik

Google DeepMind testete AlphaEvolve auch an mehr als 50 offenen mathematischen Problemen. Das System rekonstruierte in etwa 75 Prozent der Fälle bekannte Lösungen und übertraf in 20 Prozent der Fälle die bisherigen Bestwerte.

Ein Beispiel ist das Kissing-Number-Problem, bei dem ermittelt wird, wie viele gleich große Kugeln eine zentrale Kugel berühren können, ohne sich zu überlappen. Für den elfdimensionalen Fall entdeckte AlphaEvolve eine neue Konfiguration mit 593 Kugeln und verbesserte damit die bekannte untere Schranke.

In der algorithmischen Mathematik entwickelte das System einen neuen Algorithmus für die Multiplikation komplexer 4x4-Matrizen, der nur 48 Skalarmultiplikationen benötigt. Dies stellt eine Verbesserung gegenüber dem Strassen-Verfahren von 1969 dar. Anders als das Vorgängermodell AlphaTensor, das sich nur auf Matrixmultiplikation konzentrierte, zeigt AlphaEvolve eine breitere methodische Anwendbarkeit.

Diese Ergebnisse belegen nach Einschätzung von Google DeepMind, dass das System nicht nur bestehende Lösungen nachbildet, sondern auch neue Ansätze in spezialisierten Bereichen der Informatik und Mathematik entwickeln kann.

Anwendungspotenzial und Grenzen

AlphaEvolve ist laut Google DeepMind für Probleme geeignet, die sich algorithmisch darstellen und automatisch bewerten lassen. Das Unternehmen sieht Einsatzmöglichkeiten in der Materialforschung, Wirkstoffentwicklung und bei technischen Industrieprozessen. Eine benutzerfreundliche Schnittstelle und ein Early-Access-Programm für akademische Einrichtungen sind in Entwicklung.

Grenzen hat das System nach Angaben des Unternehmens bei Problemen ohne zuverlässige automatische Bewertung, etwa in naturwissenschaftlichen Bereichen, die empirische Experimente erfordern. Hier könnten Sprachmodelle künftig erste qualitative Einschätzungen liefern, bevor strukturierte Tests folgen. Google DeepMind forscht bereits an solchen hybriden Ansätzen.

Das System baut auf dem 2023 vorgestellten FunSearch auf, geht aber deutlich darüber hinaus. Während FunSearch bereits mathematische Lösungen für Probleme wie Cap-Set oder Bin-Packing fand, generiert AlphaEvolve vollständige, praxistaugliche Algorithmen.

KI-News ohne Hype – von Menschen kuratiert

Mit dem THE‑DECODER‑Abo liest du werbefrei und wirst Teil unserer Community: Diskutiere im Kommentarsystem, erhalte unseren wöchentlichen KI‑Newsletter, 6× im Jahr den „KI Radar"‑Frontier‑Newsletter mit den neuesten Entwicklungen aus der Spitze der KI‑Forschung, bis zu 25 % Rabatt auf KI Pro‑Events und Zugriff auf das komplette Archiv der letzten zehn Jahre.

Jetzt abonnierenKI-News ohne Hype

Von Menschen kuratiert.

- Mehr als 20 Prozent Launch-Rabatt.

- Lesen ohne Ablenkung – keine Google-Werbebanner.

- Zugang zum Kommentarsystem und Austausch mit der Community.

- Wöchentlicher KI-Newsletter.

- 6× jährlich: „KI Radar“ – Deep-Dives zu den wichtigsten KI-Themen.

- Bis zu 25 % Rabatt auf KI Pro Online-Events.

- Zugang zum kompletten Archiv der letzten zehn Jahre.

- Die neuesten KI‑Infos von The Decoder – klar und auf den Punkt.