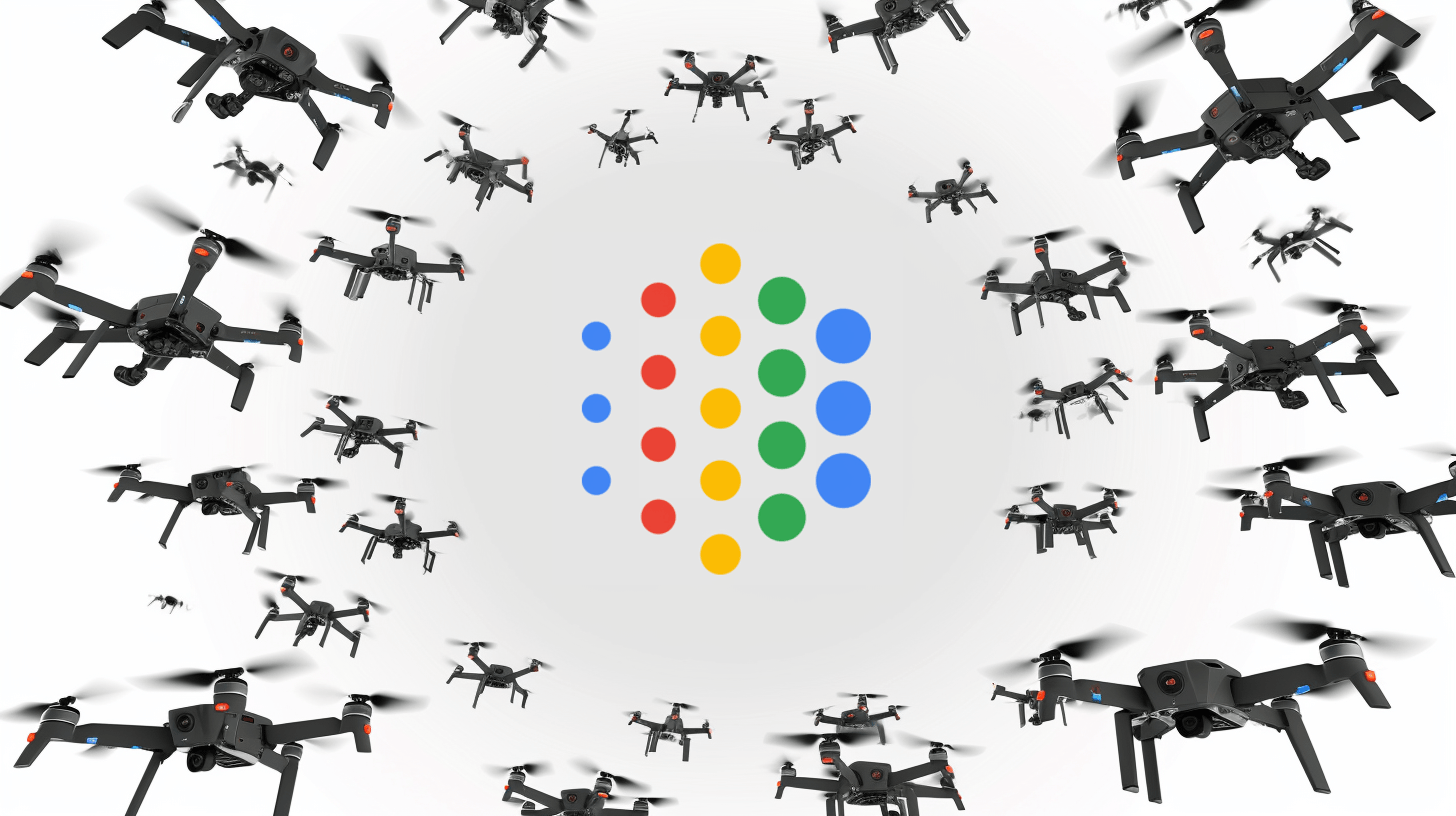

Google ebnet den Weg für den Einsatz von KI zu militärischen Zwecken

Google hat seine ethischen KI-Richtlinien überarbeitet und erlaubt nun den Einsatz seiner KI-Technologie für Waffen und Überwachung. Der Konzern folgt damit einem Trend in der KI-Branche.

Google hat am Dienstag seine ethischen Richtlinien für künstliche Intelligenz grundlegend überarbeitet. Wie die Washington Post berichtet, entfernte der Konzern die bisherigen Beschränkungen für den Einsatz seiner KI-Technologie in Waffen und Überwachungssystemen.

Zuvor enthielten die Richtlinien eine Liste von vier Anwendungen, die Google ausdrücklich ausschloss: Waffen, Überwachung, Technologien, die "Schaden verursachen oder wahrscheinlich verursachen werden" sowie Anwendungen, die gegen internationales Recht und Menschenrechte verstoßen.

Der Tech-Gigant begründet diesen Schritt mit dem zunehmenden globalen Wettbewerb um die KI-Führungsrolle. "Demokratien sollten die KI-Entwicklung anführen, geleitet von Grundwerten wie Freiheit, Gleichheit und Respekt für Menschenrechte", erklärten Googles KI-Chef Demis Hassabis und Senior Vice President James Manyika in einem Blogbeitrag.

Die neuen Richtlinien sehen vor, dass die Technologie im Einklang mit "allgemein akzeptierten Prinzipien des internationalen Rechts und der Menschenrechte" eingesetzt werden soll. Google will dabei nach eigenen Angaben durch menschliche Aufsicht und Tests "unbeabsichtigte oder schädliche Folgen" minimieren.

KI-Labore im Dienst der nationalen Sicherheit

Google-Mitarbeiter haben in den vergangenen Jahren immer wieder gegen den militärischen Einsatz der von ihnen entwickelten KI-Systeme protestiert. Doch das wirkt mittlerweile wie aus einer anderen Zeit.

Auch andere KI-Labore haben ihre Haltung geändert: Kürzlich gab OpenAI eine Partnerschaft mit dem Rüstungskonzern Anduril bekannt, um KI-basierte Drohnenabwehrsysteme für das US-Militär zu entwickeln.

Meta hat seine Llama-KI-Modelle dem US-Militär zur Verfügung gestellt und Anthropic arbeitet mit dem Rüstungsunternehmen Palantir zusammen, um US-amerikanischen Geheimdiensten und Verteidigungsbehörden den Zugriff auf Versionen von Claude über Amazon Web Services zu ermöglichen.

Microsoft schlug dem US-Verteidigungsministerium im vergangenen Jahr vor, den KI-Bildgenerator DALL-E von OpenAI für die Entwicklung von Software für militärische Operationen zu nutzen, wie aus internen Präsentationsunterlagen hervorgeht.

KI-News ohne Hype – von Menschen kuratiert

Mit dem THE‑DECODER‑Abo liest du werbefrei und wirst Teil unserer Community: Diskutiere im Kommentarsystem, erhalte unseren wöchentlichen KI‑Newsletter, 6× im Jahr den „KI Radar"‑Frontier‑Newsletter mit den neuesten Entwicklungen aus der Spitze der KI‑Forschung, bis zu 25 % Rabatt auf KI Pro‑Events und Zugriff auf das komplette Archiv der letzten zehn Jahre.

Jetzt abonnierenKI-News ohne Hype

Von Menschen kuratiert.

- Mehr als 20 Prozent Launch-Rabatt.

- Lesen ohne Ablenkung – keine Google-Werbebanner.

- Zugang zum Kommentarsystem und Austausch mit der Community.

- Wöchentlicher KI-Newsletter.

- 6× jährlich: „KI Radar“ – Deep-Dives zu den wichtigsten KI-Themen.

- Bis zu 25 % Rabatt auf KI Pro Online-Events.

- Zugang zum kompletten Archiv der letzten zehn Jahre.

- Die neuesten KI‑Infos von The Decoder – klar und auf den Punkt.