Google erweitert KI-Suche "AI Mode": Visuelle Produktsuche und neue Funktionen

Google erweitert seinen AI Mode um visuelle Suchfunktionen. Nutzer:innen sollen künftig in natürlicher Sprache nach Bildern suchen und direkt einkaufen können.

Google hat eine Erweiterung seines AI Mode angekündigt, die visuelle Suche mit konversationellen Anfragen verbinden soll. Die Funktion soll es Nutzer:innen ermöglichen, Suchanfragen in natürlicher Sprache zu stellen und Bildergebnisse zu erhalten.

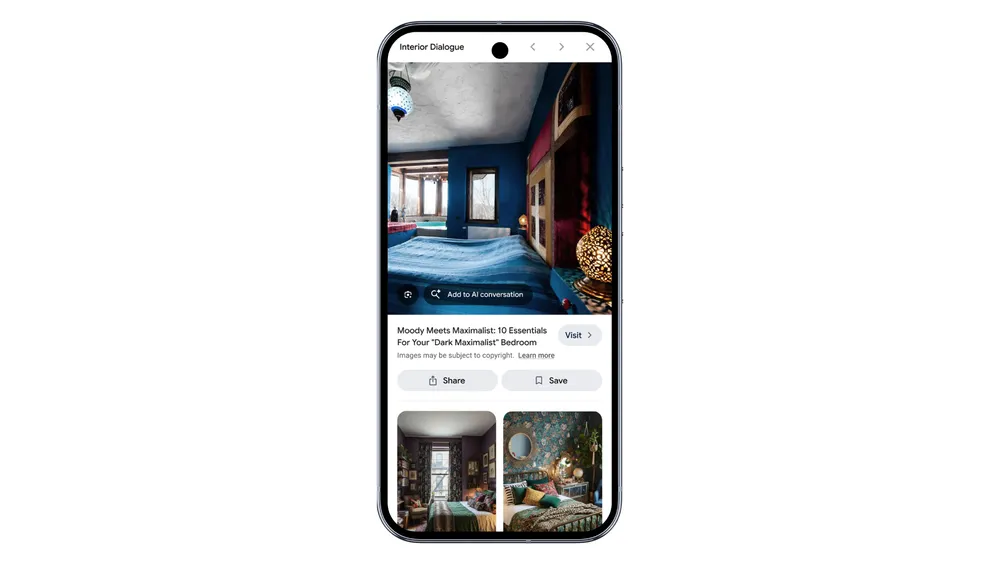

Laut Google können Nutzer:innen ihre Suche durch Folgefragen verfeinern. Die Funktion akzeptiert sowohl Texteingaben als auch Bild-Uploads oder Fotos als Ausgangspunkt. Jedes Bildergebnis soll einen Link zur Originalquelle enthalten.

Video: Google

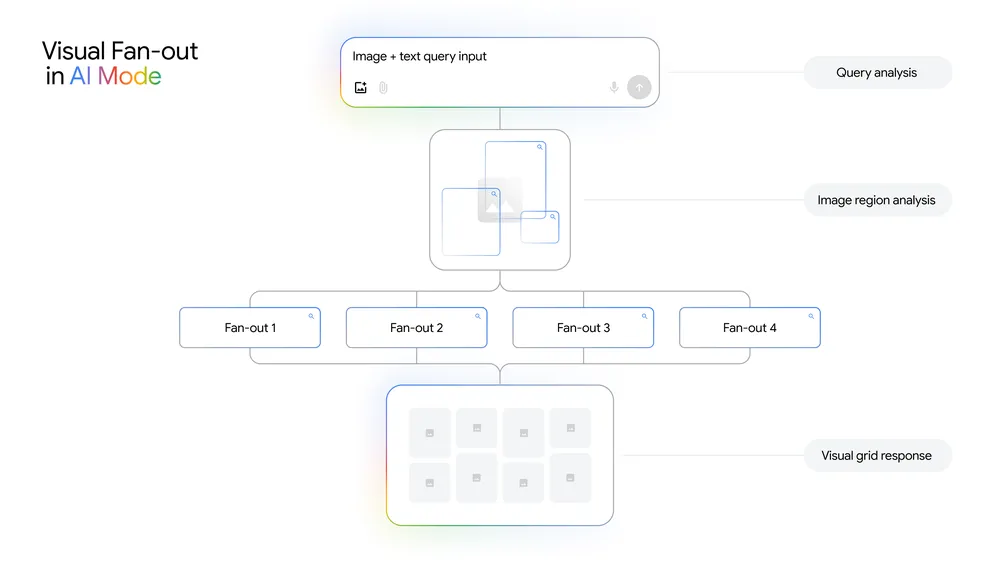

"Visual search fan-out" als technische Basis

Die Funktion baut auf Googles bestehender visueller Suche auf und nutzt die multimodalen Fähigkeiten von Gemini 2.5. Google führt eine neue "visual search fan-out" Technik ein, die Bilder detaillierter analysieren soll. Diese Fan-out-Mechanik testet Google auch an anderen Stellen der neuen KI-Suchmaschine, weitere technische Details fehlen jedoch bislang.

Dieses System soll sowohl Hauptobjekte als auch Details und Nebenelemente in Bildern erkennen und mehrere Suchanfragen im Hintergrund ausführen. Google verspricht dadurch ein besseres Verständnis des visuellen Kontexts.

Shopping-Integration ohne Filter

Ein Schwerpunkt liegt auf Shopping-Anwendungen. Nutzer:innen sollen ihre Wünsche direkt beschreiben können, anstatt Filter zu verwenden. Google nennt als Beispiel die Anfrage "Barrel Jeans, die nicht zu weit sind". Der AI Mode soll dann kaufbare Optionen anzeigen und weitere Spezifizierungen wie "Ich möchte mehr knöchellange Modelle" zulassen. Auf mobilen Geräten sollen Nutzer:innen zusätzlich innerhalb spezifischer Bilder suchen können.

Die Shopping-Funktion basiert auf Googles Shopping Graph mit nach eigenen Angaben mehr als 50 Milliarden Produktlistings. Google gibt an, stündlich über 2 Milliarden dieser Einträge zu aktualisieren.

Google startet den visuellen AI Mode diese Woche in englischer Sprache in den USA.

Vor kurzem hatte Google bereits weitere KI-Funktionen für seinen AI Mode angekündigt. Das Unternehmen führte Gemini 2.5 Pro und Deep Search für zahlende Nutzer:innen ein sowie eine automatische Anruffunktion für lokale Geschäfte.

Davor hatte Google auf der I/O 2025 agentische Funktionen und personalisierte Ergebnisse vorgestellt. Mit Project Mariner soll die KI-Suche Aufgaben wie Ticketbuchungen übernehmen und virtuelle Anprobe-Funktionen für Kleidung bieten.

Die Konkurrenz arbeitet ebenfalls an Shopping-Integrationen: OpenAI startete kürzlich eine Online-Shopping-Bezahlfunktion für ChatGPT. Die Funktion ermöglicht Sofortkäufe direkt in der Chat-Oberfläche, zunächst für Etsy-Produkte und später für über eine Million Shopify-Händler. OpenAI entwickelte dafür gemeinsam mit Stripe das "Agentic Commerce Protocol" als Open-Source-Lösung.

KI-News ohne Hype – von Menschen kuratiert

Mit dem THE‑DECODER‑Abo liest du werbefrei und wirst Teil unserer Community: Diskutiere im Kommentarsystem, erhalte unseren wöchentlichen KI‑Newsletter, 6× im Jahr den „KI Radar"‑Frontier‑Newsletter mit den neuesten Entwicklungen aus der Spitze der KI‑Forschung, bis zu 25 % Rabatt auf KI Pro‑Events und Zugriff auf das komplette Archiv der letzten zehn Jahre.

Jetzt abonnierenKI-News ohne Hype

Von Menschen kuratiert.

- Mehr als 20 Prozent Launch-Rabatt.

- Lesen ohne Ablenkung – keine Google-Werbebanner.

- Zugang zum Kommentarsystem und Austausch mit der Community.

- Wöchentlicher KI-Newsletter.

- 6× jährlich: „KI Radar“ – Deep-Dives zu den wichtigsten KI-Themen.

- Bis zu 25 % Rabatt auf KI Pro Online-Events.

- Zugang zum kompletten Archiv der letzten zehn Jahre.

- Die neuesten KI‑Infos von The Decoder – klar und auf den Punkt.