Google kopiert ChatGPT Canvas und bringt KI-Podcasts in den Gemini-Chat

Google bringt einen Editor mit Code-Vorschau in den Gemini-Chat. Außerdem sind die Audio-Podcasts von NotebookLM online.

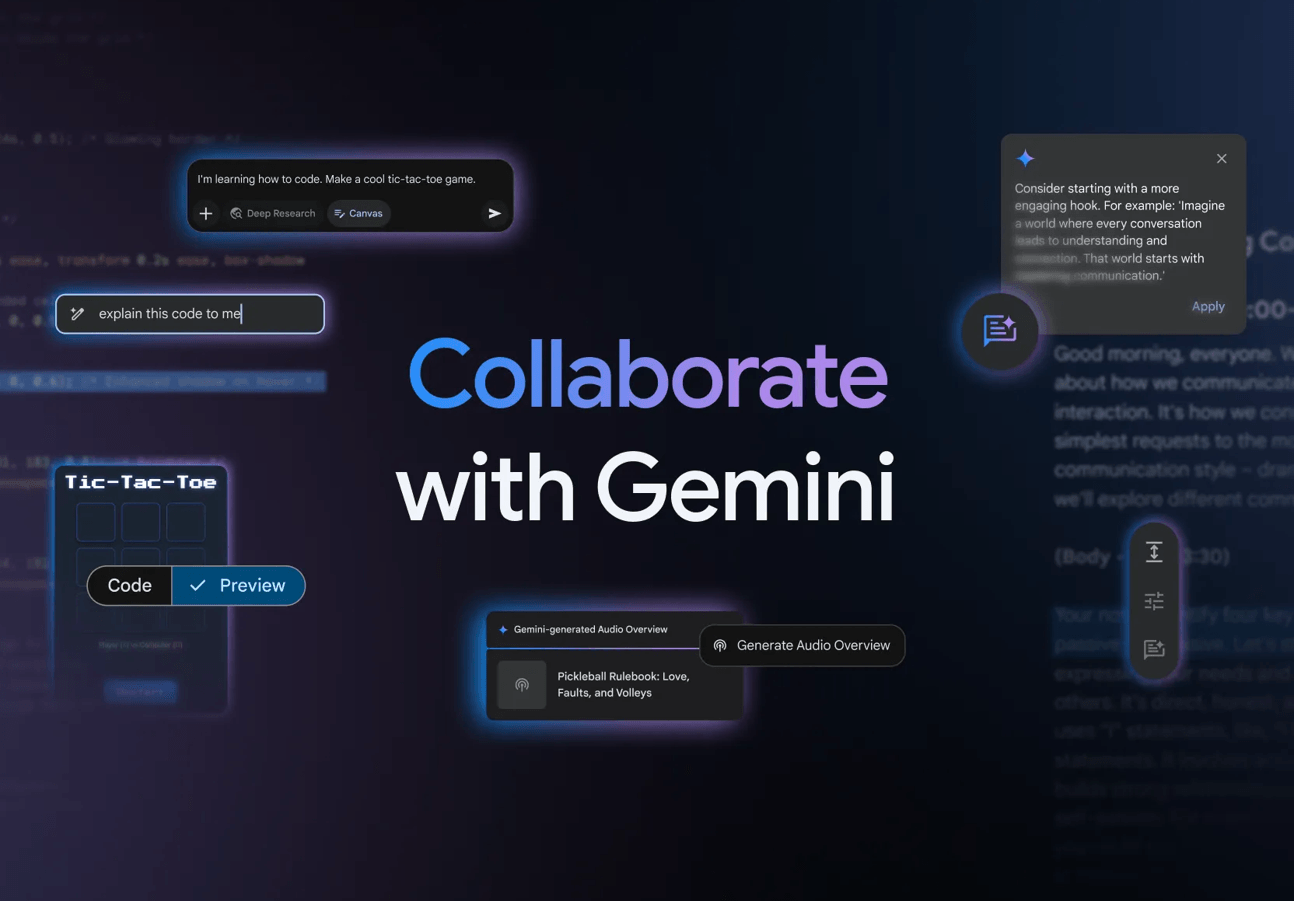

Google hat zwei neue Funktionen für seinen KI-Assistenten Gemini vorgestellt: einen interaktiven Arbeitsbereich namens Canvas und eine Audio-Zusammenfassungsfunktion namens Audio Overview.

Der neue Canvas-Bereich soll laut Google die Zusammenarbeit zwischen Nutzer und KI bei der Erstellung und Bearbeitung von Dokumenten und Code verbessern. Änderungen werden in Echtzeit angezeigt und können direkt mit der KI im Chat besprochen werden.

Für Entwickler bietet Canvas Funktionen zur Code-Bearbeitung und -Previews. Das System kann HTML- und React-Code erstellen und direkt eine Vorschau anzeigen. Fertige Dokumente lassen sich per Knopfdruck zu Google Docs exportieren. ChatGPT führte eine fast identische Canvas-Funktion schon im letzten Herbst ein.

KI verwandelt Dokumente in Podcasts

Die neue Audio-Overview-Funktion soll Dokumente, Präsentationen und Recherche-Berichte in Podcast-ähnliche Gespräche umwandeln. Dabei simuliert die KI eine Diskussion zwischen zwei Moderatoren, die die Inhalte zusammenfassen und analysieren. Google zeigt, wie Audio Overview ein Ergebnis der ebenfalls überarbeiteten und jetzt kostenlosen Deep-Research-Funktion in einen Podcast verwandelt.

Diese Audio Overviews sind schon von NotebookLM bekannt und sorgten im letzten Jahr für etwas Hype. Wie alle generativen KI-Systeme können auch Podcasts falsche Informationen enthalten; das gilt auch für die Deep-Research-Funktion, die Google hier mit KI-Podcasts kombiniert. Natürlich können beide Features trotzdem nützlich sein, aber man sollte den Informationen nicht blind vertrauen, und sich im Optimalfall gut mit dem Thema auskennen.

Die Audio-Funktion steht zunächst nur in englischer Sprache zur Verfügung und kann sowohl über die Web-Version als auch über die mobile App genutzt werden. Die generierten Audio-Dateien lassen sich herunterladen und teilen. Beide neuen Funktionen werden ab sofort weltweit für Abonnenten von Gemini und Gemini Advanced ausgerollt.

Google baut das Gemini-Ökosystem aus

In den vergangenen Wochen hat Google sein Gemini-Ökosystem stark erweitert: Mit Google Gemini Live können Live-Videos und der eigene Smartphone-Screen in Chatbot-Unterhaltungen eingebunden werden. Diese Funktion wird zunächst auf Samsung Galaxy S24/S25 und Pixel 9 Geräten verfügbar sein.

Darüber hinaus wird Gemini in den kommenden Monaten den Google Assistant als Standard-Android-Assistenten ablösen. Auch die App-Integration wurde erweitert, sodass Gemini nun auch Samsung-Apps steuern kann.

Google führte zudem drei neue Modellvarianten ein: Gemini 2.0 Flash als Basismodell, Flash-Lite als kostengünstige Option und 2.0 Pro als experimentelle Version mit erweitertem Kontextfenster. Eine neue Personalisierungsfunktion erlaubt es Gemini außerhalb der EU, Schweiz und UK, auf persönliche Google-Suchdaten zuzugreifen, um relevantere Antworten zu erhalten.

Und Google startet mit nativer Multimodalität in Gemini-Modellen, die jetzt auch Bilder generieren und bearbeiten und zudem YouTube-Videos verstehen können.

KI-News ohne Hype – von Menschen kuratiert

Mit dem THE‑DECODER‑Abo liest du werbefrei und wirst Teil unserer Community: Diskutiere im Kommentarsystem, erhalte unseren wöchentlichen KI‑Newsletter, 6× im Jahr den „KI Radar"‑Frontier‑Newsletter mit den neuesten Entwicklungen aus der Spitze der KI‑Forschung, bis zu 25 % Rabatt auf KI Pro‑Events und Zugriff auf das komplette Archiv der letzten zehn Jahre.

Jetzt abonnierenKI-News ohne Hype

Von Menschen kuratiert.

- Mehr als 20 Prozent Launch-Rabatt.

- Lesen ohne Ablenkung – keine Google-Werbebanner.

- Zugang zum Kommentarsystem und Austausch mit der Community.

- Wöchentlicher KI-Newsletter.

- 6× jährlich: „KI Radar“ – Deep-Dives zu den wichtigsten KI-Themen.

- Bis zu 25 % Rabatt auf KI Pro Online-Events.

- Zugang zum kompletten Archiv der letzten zehn Jahre.

- Die neuesten KI‑Infos von The Decoder – klar und auf den Punkt.