Google senkt Gemini-Preise drastisch und führt neue PDF-Funktionen ein

Der Preiskampf bei KI-Modellen geht weiter: Google senkt die Preise für das schnelle Gemini 1.5 Flash um bis zu 78 Prozent.

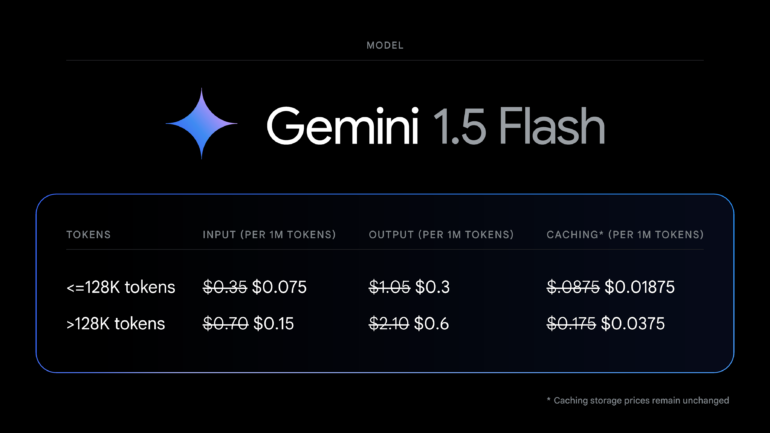

Laut Google sinken die Kosten für Eingabe-Token um 78 Prozent auf 0,075 US-Dollar pro Million Token. Die Kosten für Output-Token sinken um 71 Prozent auf 0,30 US-Dollar pro Million Token, solange die Prompts weniger als 128.000 Token umfassen. Für längere Prompts und Caching gelten die Preissenkungen entsprechend.

Gemini 1.5 Flash ist laut Google das beliebteste Modell für Anwendungsfälle, die hohe Geschwindigkeit und geringe Latenz erfordern, wie Zusammenfassungen, Kategorisierung und multimodales Verstehen.

Die Gemini-API und AI Studio unterstützen nun das Verständnis von PDFs durch Text und Bild. Enthält eine PDF Grafiken, Bilder oder andere visuelle Inhalte, nutzt das Modell native multimodale Fähigkeiten zur Verarbeitung.

Mehr Sprachen und Fine-Tuning

Darüber hinaus hat Google das Sprachverständnis für die Gemini 1.5 Pro- und Flash-Modelle auf mehr als 100 Sprachen erweitert. Entwickler können so weltweit in ihrer bevorzugten Sprache mit den Modellen arbeiten.

Zudem erweitert Google den Zugang für Gemini 1.5 Flash Fine-Tuning. Es steht nun allen Entwicklern über die Gemini-API und Google AI Studio zur Verfügung. Durch Fine-Tuning können Entwickler Basismodelle anpassen und die Leistung für bestimmte Aufgaben verbessern, indem sie dem Modell zusätzliche Daten zur Verfügung stellen. Das reduziert die Kontextgröße von Prompts, verringert Latenz und Kosten und kann die Genauigkeit des Modells erhöhen.

Googles Ankündigung folgt auf OpenAIs Bekanntgabe, dass die API-Preise bei GPT-4o nur wenige Wochen nach der Veröffentlichung um bis zu 50 Prozent sinken. Die Modellanbieter liefern sich also trotz der hohen Entwicklungs- und Betriebskosten der KI-Modelle bereits einen harten Preiskampf.

KI-News ohne Hype – von Menschen kuratiert

Mit dem THE‑DECODER‑Abo liest du werbefrei und wirst Teil unserer Community: Diskutiere im Kommentarsystem, erhalte unseren wöchentlichen KI‑Newsletter, 6× im Jahr den „KI Radar"‑Frontier‑Newsletter mit den neuesten Entwicklungen aus der Spitze der KI‑Forschung, bis zu 25 % Rabatt auf KI Pro‑Events und Zugriff auf das komplette Archiv der letzten zehn Jahre.

Jetzt abonnierenKI-News ohne Hype

Von Menschen kuratiert.

- Mehr als 20 Prozent Launch-Rabatt.

- Lesen ohne Ablenkung – keine Google-Werbebanner.

- Zugang zum Kommentarsystem und Austausch mit der Community.

- Wöchentlicher KI-Newsletter.

- 6× jährlich: „KI Radar“ – Deep-Dives zu den wichtigsten KI-Themen.

- Bis zu 25 % Rabatt auf KI Pro Online-Events.

- Zugang zum kompletten Archiv der letzten zehn Jahre.

- Die neuesten KI‑Infos von The Decoder – klar und auf den Punkt.