Google hat einen weiteren Schritt auf dem langen Weg zur vollständigen KI- und Sprachsteuerung von Smartphones und Computern im Allgemeinen gemacht. Bis dahin ist es aber noch ein weiter Weg.

Google Research hat ein neues KI-Modell namens ScreenAI vorgestellt, das Benutzeroberflächen und Infografiken verstehen kann.

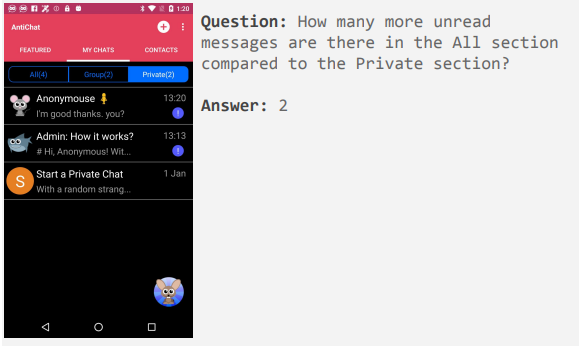

Es hat bei einer Vielzahl von Aufgaben neue Bestleistungen erzielt, unter anderem bei der Beantwortung inhaltlicher Fragen auf Basis von Infografiken, bei deren Zusammenfassung oder bei der Navigation durch Benutzeroberflächen.

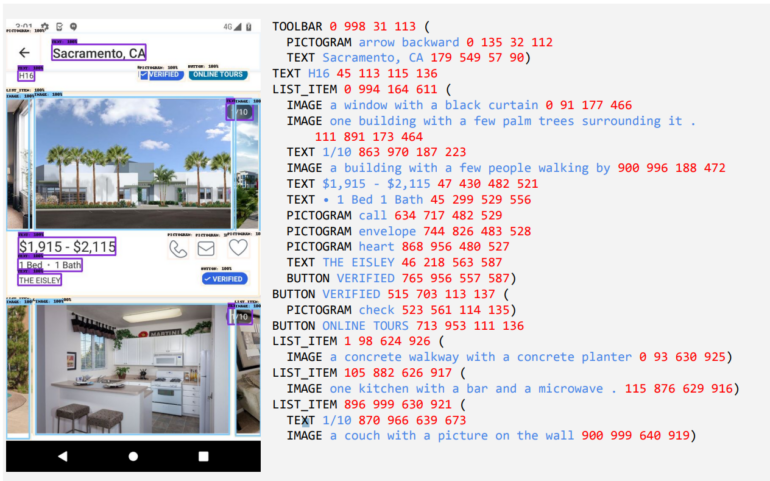

Kernstück von ScreenAI ist eine neue Methode zur textuellen Darstellung von Screenshots, bei der das Modell die Art und Position von UI-Elementen identifiziert. Mithilfe des Google LLM PaLM 2-S generierten die Forscherinnen und Forscher synthetische Trainingsdaten für das Modell für die Beantwortung von Fragen zu Informationen auf dem Bildschirm, zur Navigation auf dem Bildschirm und zur Zusammenfassung des Bildschirminhalts.

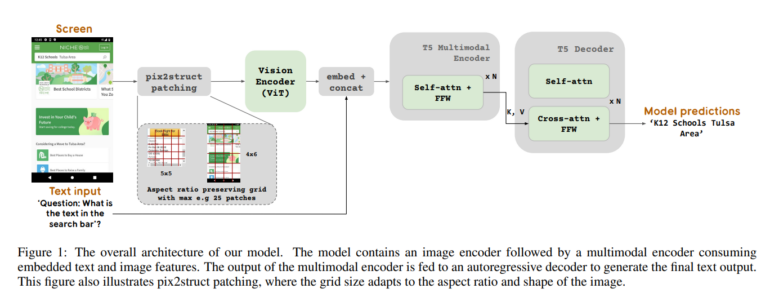

Das Modell kombiniert vorherige Google-Entwicklungen wie die PaLI-Architektur mit dem flexiblen Patching-Mechanismus von Pix2Struct, der eine Grafik je nach Seitenverhältnis in ein variables Raster aufteilt.

ScreenAI verwendet einen Bildkodierer und einen multimodalen Kodierer, um Bild- und Texteingaben zu verarbeiten, gefolgt von einem autoregressiven Dekodierer, um die Textausgabe zu erzeugen.

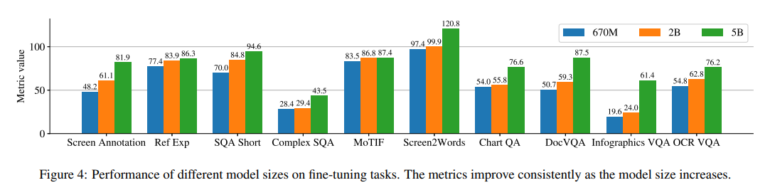

Das Resultat sind drei Modelle mit 670 Millionen, zwei Milliarden und fünf Milliarden Parametern. Die Experimente der Forscherinnen und Forscher zeigen, dass sich die Modellleistung mit zunehmender Modellgröße verbessert. Das lässt auf ein großes Potenzial für weitere Leistungssteigerungen durch Skalierung des Modells schließen.

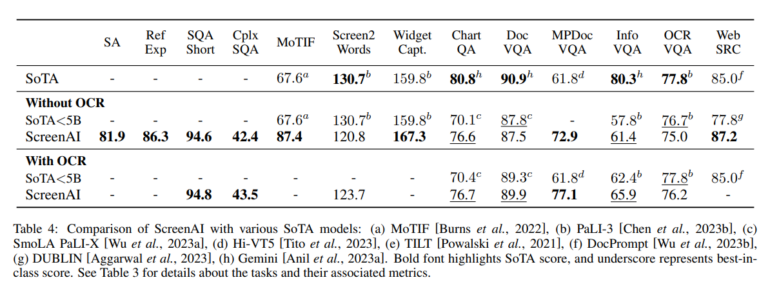

Im Vergleich mit Modellen ähnlicher Größe schneidet ScreenAI in allen Benchmarks am besten ab und kann sich in vielen Fällen auch gegen größere Modelle durchsetzen. Einen leichten positiven Einfluss hat die Verwendung von OCR (Optical Character Reconition), um Textinhalte aus Screenshots zu extrahieren.

Fortschritte in der Forschung, aber die praktische Anwendung fehlt

ScreenAI stellt zwar einen kleinen Meilenstein in der Verbesserung des Verstehens digitaler Inhalte dar, es fehlt jedoch noch der Teil des Modells, der die generierten Aktionen auch tatsächlich ausführen kann.

Zwar gibt es bereits aktuelle Sprachmodelle, die auf Smartphones laufen, aber es fehlt an leistungsfähigeren multimodalen Modellen, die Text, Bilder, Audio und Video kombinieren.

Generell ist aber davon auszugehen, dass die automatisierte Bedienung von Smartphones durch natürliche Spracheingabe in den nächsten Jahren durch Modelle wie ScreenAI weiter voranschreiten wird.

"Obwohl unser Modell das beste seiner Klasse ist, stellen wir fest, dass bei einigen Aufgaben weitere Forschung erforderlich ist, um die Lücke zu deutlich größeren Modellen wie GPT-4 und Gemini zu schließen", schließen die Wissenschaftler:innen ihre Erkenntnisse.

Evaluationsdatensätze für die weitere Forschung

Um die Weiterentwicklung voranzutreiben, plant Google Research im Rahmen von ScreenAI Datensätze zur Evaluation zu veröffentlichen. Bereits verfügbar ist ScreenQA mit einer Sammlung von 86.000 Frage-Antwort-Paaren zu 36.000 Screenshots, eine komplexere Variante und eine Sammlung von Screenshots und deren Textbeschreibungen werden folgen.