Der Softwareentwickler Ishan Anand hat das komplette 124 Millionen Parameter umfassende GPT-2 in ein Excel-Spreadsheet gepackt. Ziel ist es, auch Nicht-Entwickler:innen einen Einblick zu geben, wie moderne LLMs basierend auf der weit verbreiteten Transformer-Architektur im Detail funktionieren.

Das Excel-File mit dem GPT-2 Sprachmodell ist rund 1,2 GB groß und erfordert die neueste Excel-Version auf Windows. Vor Gebrauch unter macOS warnt Anand, da die Dateigröße das Programm zum Einfrieren bringe. Das Sprachmodell arbeite komplett lokal ausschließlich mit Excel-eigenen Funktionen, ohne Zugriff auf Cloud-Dienste oder Python-Skripte.

Ein Token pro Minute

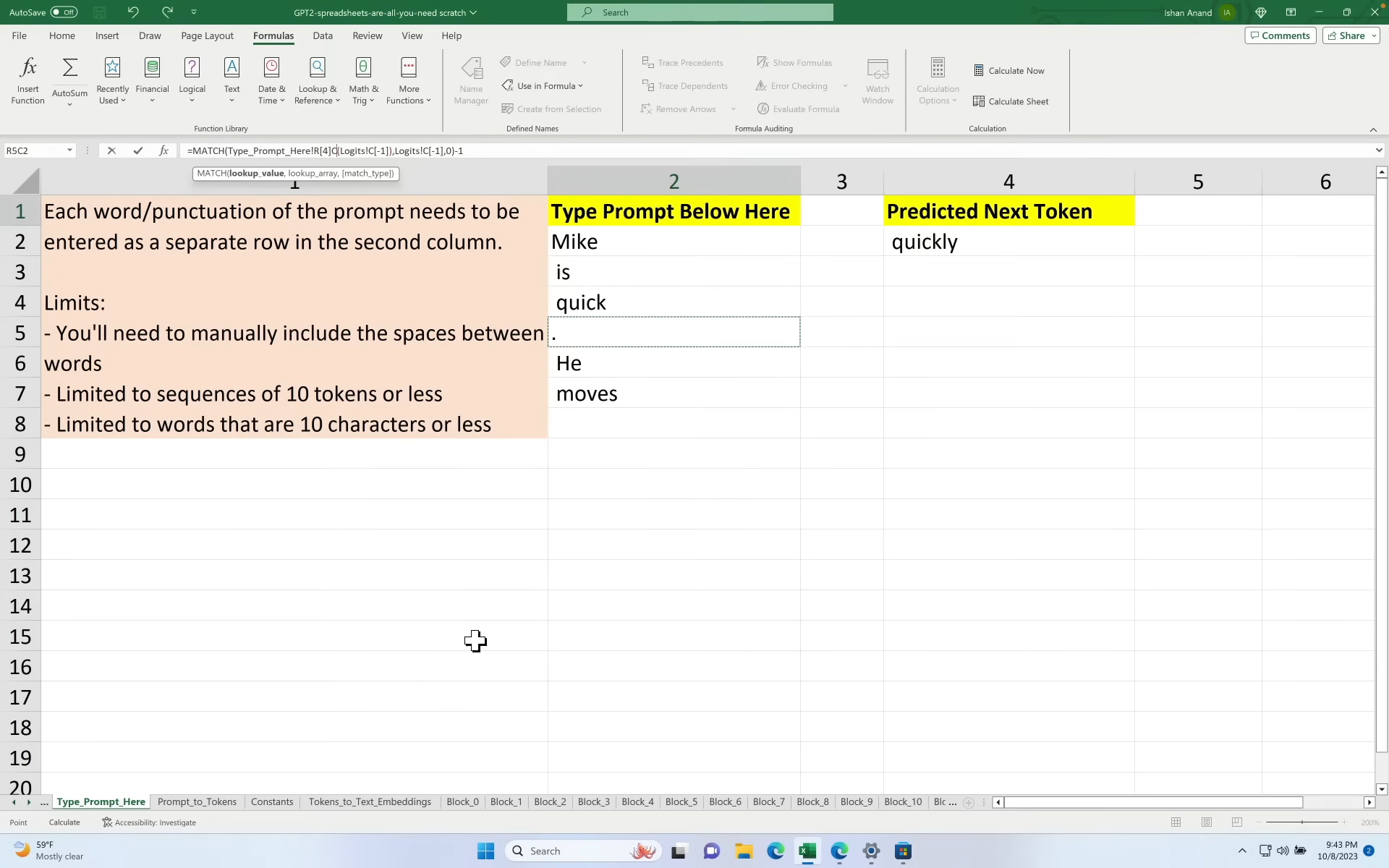

Ein Ersatz für einen Chatbot wie ChatGPT ist die Excel-Datei selbstverständlich nicht. Die Bedienung ist nicht sonderlich komfortabel: Nutzer:innen können Wörter in eine bestimmte Zelle eingeben und sehen nach rund einer Minute in einer anderen, welches das nächste wahrscheinlichste Wort ist. Anhand verschiedener Tabellen lässt sich dann aber nachvollziehen, was bei der Verarbeitung im Hintergrund passiert.

In einem Vortrag bei den Seattle AI Tinkerers demonstrierte Anand die Funktionsweise. Er gab den Satzanfang "Mike is quick, he moves" ein. Das Modell vervollständigte den Satz korrekt mit "quickly".

Anand erläuterte, dass es ihm darum geht, die Konzepte der zugrunde liegenden Transformer-Architektur anschaulich und interaktiv erfahrbar zu machen. Tatsächlich sei ein Sprachmodell grundsätzlich gut für eine Excel-Datei geeignet, da es hauptsächlich aus mathematischen Operationen bestehe, so Anand gegenüber Ars Technica. Die Tokenisierung, also die Umwandlung von Wörtern in Zahlen, sei jedoch eine besondere Herausforderung gewesen.

Anand möchte damit ein niedrigschwelliges Verständnis ermöglichen, etwa, warum das der Transformer-Architektur zugrundeliegende Paper "Attention is all you need" heißt, dem sein Projekt namentlich mit "Spreadsheets is all you need" Tribut zollt. Dafür hat er auf seiner Website bereits Lernvideos veröffentlicht, weitere sollen folgen.

Doch auch für Entwickler:innen sieht Anand Vorteile. So lässt sich z.B. anhand der Tabellenansicht leichter nachvollziehen, warum Techniken wie "Chain of Thought"-Prompting die Leistung verbessern: Weil sie dem Modell mehr Raum und mehr "Durchgänge" durch die Attention-Schichten geben, um Zusammenhänge zu erkennen.

ChatGPT half bei Umsetzung

Ursprünglich implementierte er das Projekt in Google Sheets, wechselte dann aber mangels Speicherplatz zu Excel. Die technischen Limitierungen sind Anand bewusst: Mehr als 10 Token Kontext sind derzeit nicht möglich, ohne die internen Gewichtsmatrizen aufwändig umzustrukturieren. An dem Projekt arbeite Anand bereits seit Juni 2023. ChatGPT sei dabei besonders hilfreich gewesen.

GPT-2 galt bei seiner Veröffentlichung 2019 als Meilenstein in der Entwicklung großer Sprachmodelle. Aus Sorge vor Missbrauch zögerte OpenAI zunächst, den vollen Quellcode und die trainierten Parameter zu veröffentlichen. Erst später im Jahr 2019 wurde GPT-2 dann doch in vollem Umfang zugänglich gemacht. Die Excel-Variante nutzt das "kleine" GPT-2-Small mit 124 Millionen Parametern statt der vollständigen Ausgabe mit 1,5 Milliarden Parametern. Heutige Modelle auf Niveau von GPT-4 umfassen in der Regel mehrere 100 Milliarden Parameter.