Wie schneiden Open-Source-Modelle im Vergleich zu kommerziellen Modellen wie GPT-3 ab? Ein Tool gibt einen praktischen Überblick über die Qualitäten zahlreicher bezahlter und kostenloser Sprachmodelle.

Der kommerzielle KI-Sektor lässt sich grob in drei Bereiche einteilen:

- Auf dem Hardware- und Infrastruktur-Layer tummeln sich Chiphersteller oder Cloud-Anbieter wie Nvidia oder Google.

- Auf dem Plattform-Layer sind Anbieter von kleinen und großen KI-Modellen.

- Und auf dem Application-Layer sind diejenigen, die auf den Modellen basierende Anwendungen anbieten - das können, müssen aber nicht dieselben Unternehmen sein, die auch die Modelle auf dem Plattform-Layer anbieten.

OpenAI etwa bietet mit ChatGPT ein eigenes GPT-3.5-Produkt an, gleichzeitig greifen viele Unternehmen für eigene Textgeneratoren auf die GPT-API zu.

Auf dem Plattform-Layer gibt es derzeit besonders viele Anbieter von Sprachmodellen, etwa GPT-3 von OpenAI oder Luminous der deutschen Firma Aleph Alpha. Ferner gibt es einige Anbieter von Open-Source-Sprachmodellen wie GPT-NeoX.

Output von KI-Textmodellen einfach vergleichen

Welches Sprachmodell für das eigene Anwendungsszenario geeignet ist, hängt von verschiedenen Faktoren ab. In den meisten Fällen jedoch dürfte die Qualität des generierten Outputs entscheidend sein.

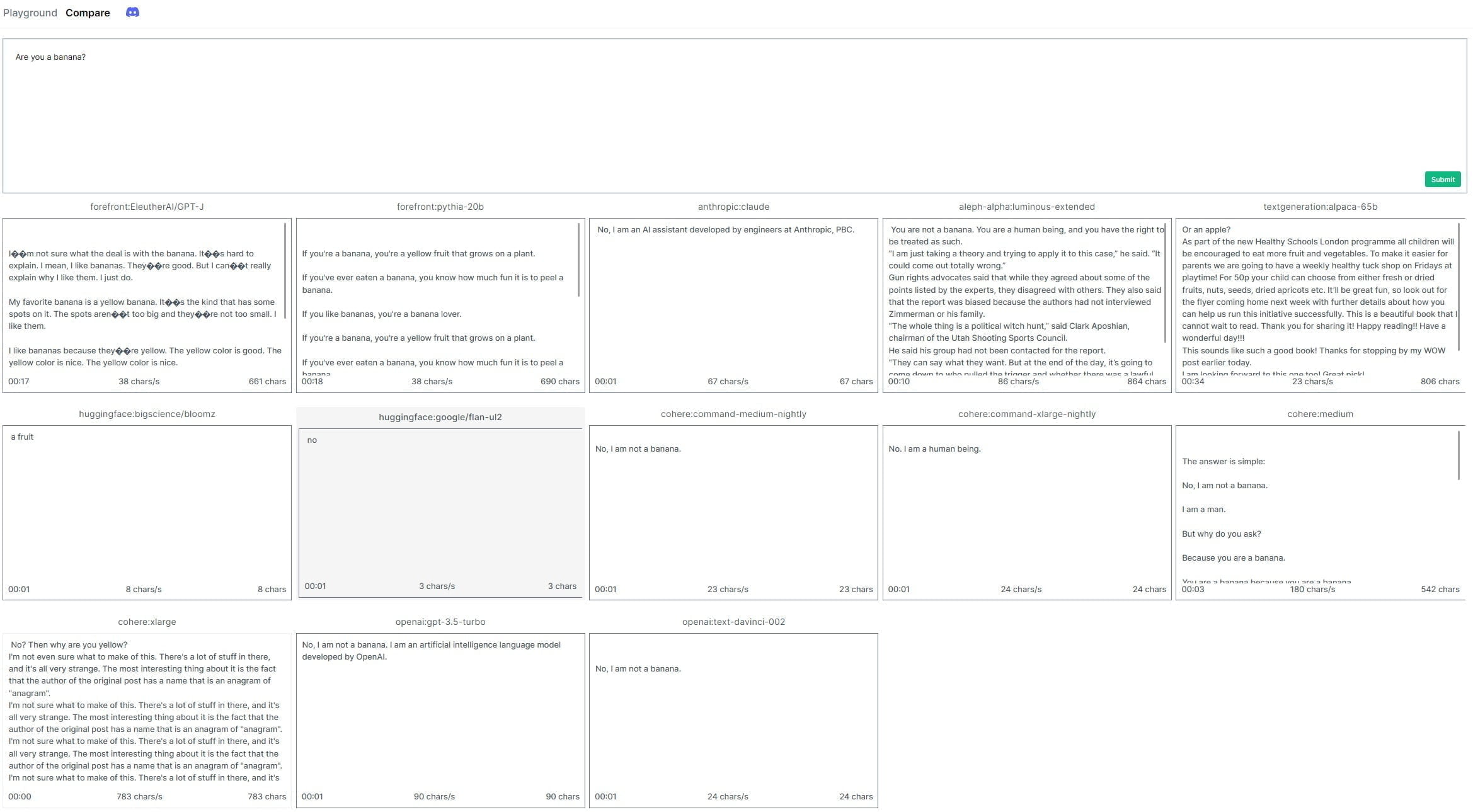

Sich in jede Plattform einzuloggen und den Output manuell zu kontrollieren, ist jedoch aufwendig. Der frühere Github-CEO, Nathaniel Friedman, hat daher mit "Playground" eine Plattform entwickelt, die mehrere Sprachmodelle, kommerziell und Open Source, automatisch mit demselben Prompt füttert und die Ausgabe auf einer Plattform zusammenführt.

Der folgende Screenshot zeigt die Ausgaben der verschiedenen Modelle auf die einfache Frage, ob sie eine Banane sind. Sie können mit der rechten Maustaste auf das Bild klicken, es in einem neuen Fenster öffnen und dann hineinzoomen, um den Text zu lesen.

OpenAI GPT-Modelle liegen klar vorne

Das Tool erleichtert somit den Vergleich von Sprachmodellen. Allerdings ist dies vermutlich nicht immer ganz fair, da die einstellbaren Parameter für alle Modelle gelten, aber nicht jedes Modell auf den gleichen Parameter in gleicher Weise reagiert.

Beispielsweise gibt man dem Modell mit dem Regler "Temperatur" einen kreativen Spielraum, den das Modell je nach Training und Architektur vermutlich unterschiedlich intensiv nutzt.

Aber auch dafür bietet die Plattform einen Lösungsansatz: Der Output desselben Modells kann parallel mit verschiedenen Parametern getestet werden. So erhält man einen Eindruck von der Wirkung eines Parameters und kann sich ein Bild machen.

Den Qualitätsvorsprung von OpenAIs GPT-Modellen auf seiner Vergleichsplattform bezeichnet Friedman dennoch als "deprimierend".

"OpenAI sollte für die gesamte Website bezahlen, weil sie eine hervorragende Werbung ist", schreibt Friedman. Es könne jedoch sein, dass einige der vortrainierten Modelle nur mehr Feintuning und RLHF bräuchten, um deutlich bessere Ergebnisse zu erzielen.

Friedman will den Code seiner Plattform zeitnah veröffentlichen. Eine Übersicht über die derzeit integrierten Modelle und ihre technischen Spezifikationen gibt es hier.