Ist ein dezentraler Trainingsansatz die Zukunft für die Weiterentwicklung großer Sprachmodelle? GPT-JT weist jedenfalls in diese Richtung.

Bei generativer KI für Bilder stellt Stable Diffusion mit seinem Open-Source-Ansatz eine ernsthafte Alternative zu DALL-E 2 und Midjourney dar. Der neuen, dezentralisierten Variante GPT-JT soll dasselbe bei großen Sprachmodellen gelingen, indem sie teilweise an GPT-3 heranreicht.

GPT-JT wurde von Wissenschaftler:innen aus der Community von Together entwickelt, bestehend unter anderem aus Forschenden der ETH Zürich und der Stanford University.

Fork von GPT-J-6B

Das Sprachmodell baut auf dem sechs Milliarden Parametern großen GPT-J-6B von EleutherAI auf und wurde mit 3,5 Milliarden Tokens feinjustiert. Die Besonderheit: Anstatt alle Maschinen über schnelle Rechenzentren zu vernetzen, standen Together lediglich verhältnismäßig langsame Verbindungen mit bis zu einem Gigabit/s zur Verfügung.

Mit den klassischen Lernalgorithmen würde laut der Forschenden jede Maschine 633 TB an Daten für die Kommunikation erzeugen. Dank Optimierungen und einer auf lokalem Training basierenden Strategie, die zufällig Schritte überspringt, konnte das GPT-JT-Team diesen Bedarf auf 12,7 TB reduzieren.

Noch wichtiger als das Modell selbst, das einen ersten Schritt darstellt, ist, dass wir die Stärke der Open-Source-KI hervorheben möchten, bei der Gemeinschaftsprojekte schrittweise verbessert und wieder in Open-Source eingebracht werden können, was zu öffentlichen Gütern und einer Wertschöpfungskette führt, von der alle profitieren können.

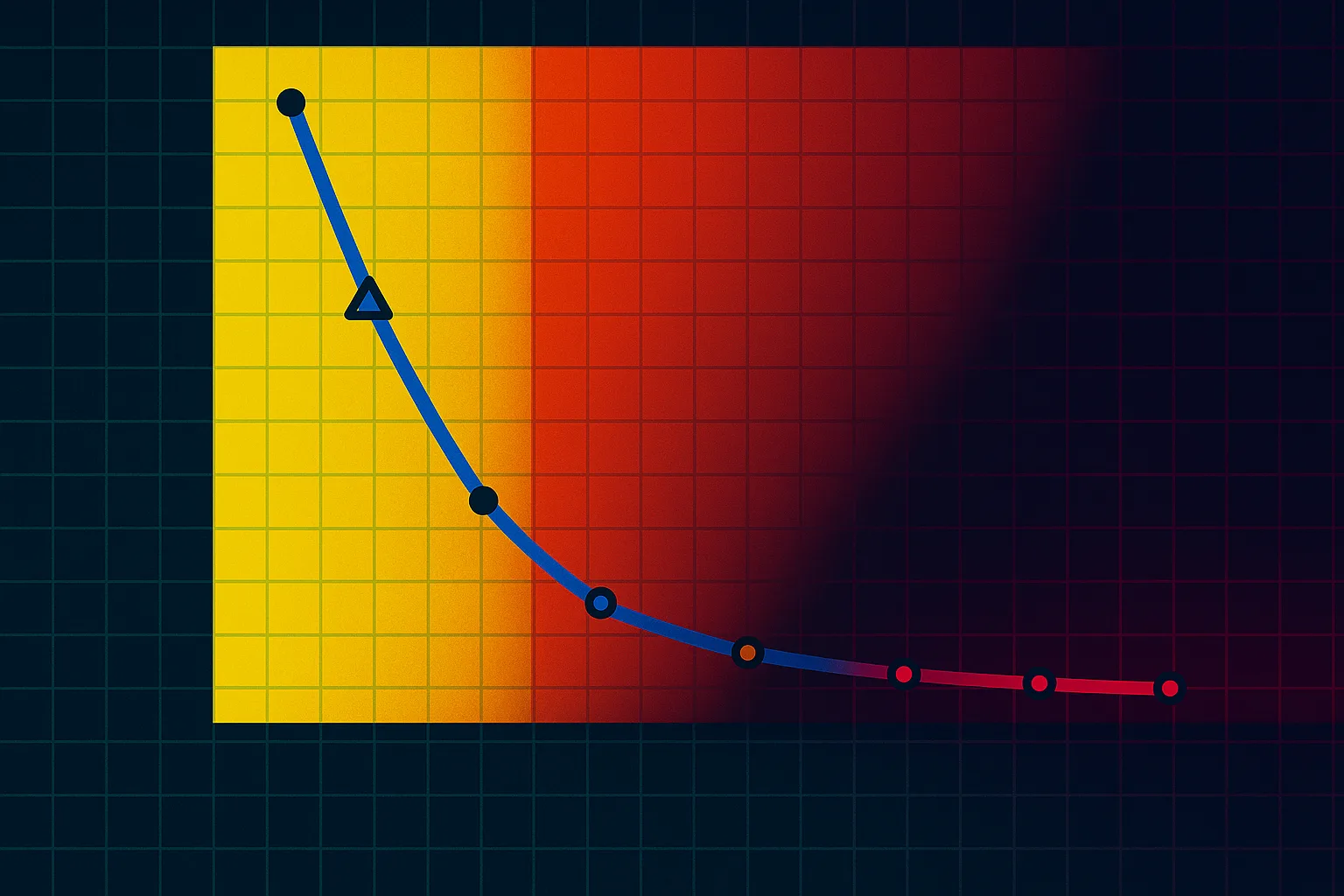

GPT-JT laut Benchmark nur knapp hinter GPT-3

GPT-JT kann trotz der Einschränkungen beim Training mit anderen Sprachmodellen mithalten. Bei der Klassifizierung von Text schafft das Open-Source-Modell einen RAFT-Score, eine Methode für die ganzheitliche Bewertung von Sprachmodellen, den zweiten Platz.

Damit liegt GPT-JT nur knapp hinter OpenAIs InstructGPT "davinci V2" mit 175 Milliarden Parametern, also knapp 30 Mal so viele Parameter. Ähnlich große Open-Source-Modelle wie BLOOM sind erst in der zweiten Hälfte des Rankings zu finden.

"Angriff auf die politische KI-Ökonomie"

Jack Clark, Autor des Newsletters "Import AI", nennt GPT-JT einen "Angriff auf die politische Ökonomie der KI". Bis jetzt wurde ein Großteil der KI-Entwicklung von einer kleinen Zahl an Gruppierungen mit Zugang zu großen, zentralisierten Computernetzwerken bestimmt.

"GPT-JT schlägt eine radikal andere Zukunft vor - verteilte Kollektive können stattdessen Computer über miserable Internetverbindungen zusammenschließen und gemeinsam Modelle trainieren", resümiert Clark.

Open-Source-Modell jetzt verfügbar

Eine GPT-JT-Demo könnt ihr kostenlos auf Hugging Face mit Beispielszenarien wie einer Sentimentanalyse, Themen-Klassifizierung, Zusammenfassung oder dem Beantworten von Fragen ausprobieren. Dort ist auch der Code verfügbar.