Der leitende US-Beamte für die Einführung von KI im Pentagon warnte auf einem Vortrag vor dem Einsatz großer Sprachmodelle in sensiblen Bereichen.

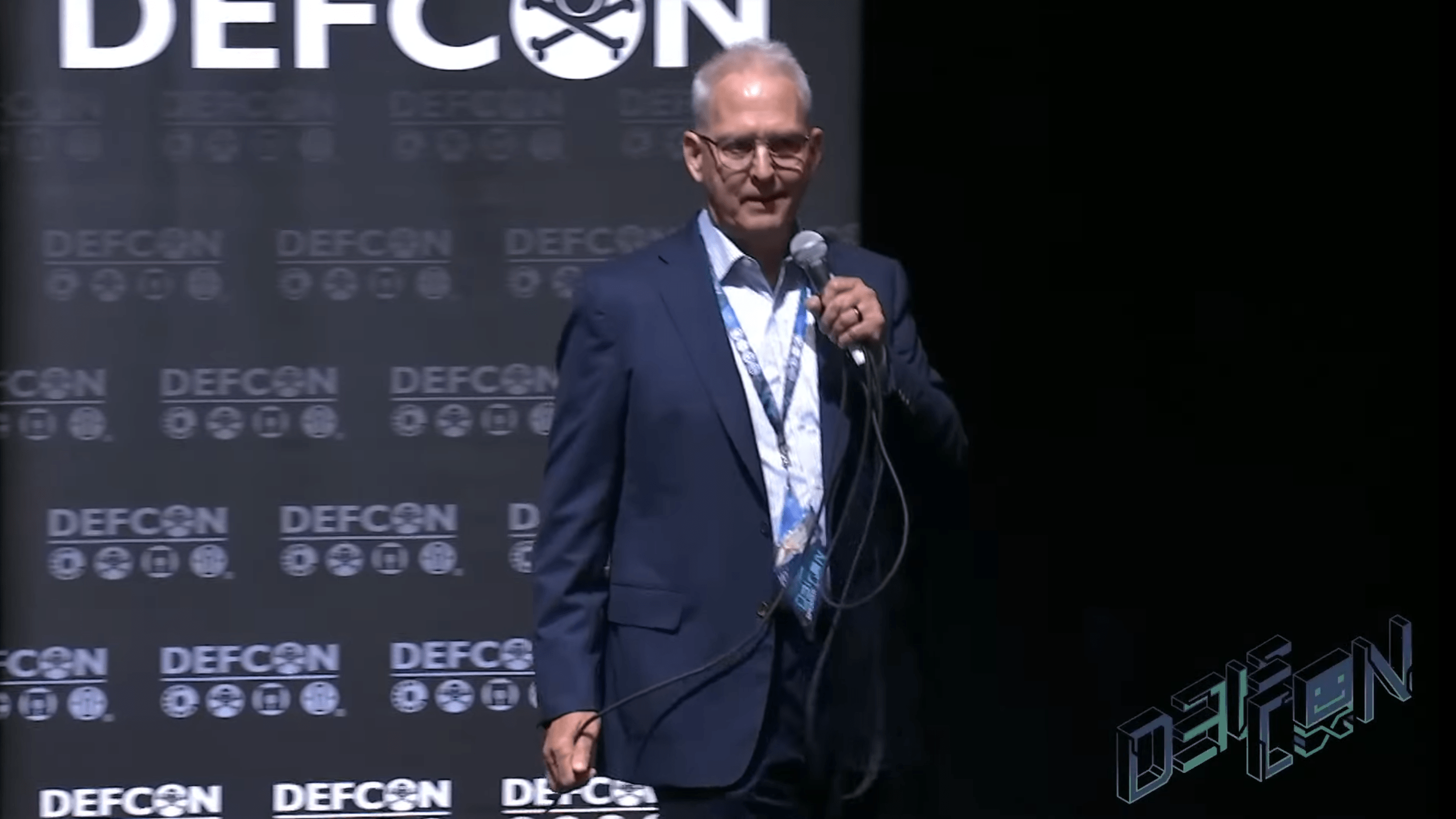

Dr. Craig Martell, Chief Digital and Artificial Intelligence Officer (CDAO) des US-Verteidigungsministeriums, hielt auf der DEFCON einen nüchternen Vortrag über den Hype um generative KI wie große Sprachmodelle. Er warnte davor, sie ohne effektive Validierungsmethoden in der Verteidigung einzusetzen.

Als CDAO ist Martel der leitende US-Beamte, "der die Nutzung von Daten, Analysen und KI im Verteidigungsministerium vorantreiben soll, um Entscheidungsvorteile zu erzielen - vom Besprechungsraum bis zum Schlachtfeld."

Martel, der vor seiner jetzigen Position unter anderem für KI-Projekte bei LinkedIn, Dropbox und Lyft verantwortlich war, betonte, dass große Sprachmodelle wie ChatGPT zwar erstaunlich gut Texte generieren könnten, diese Fähigkeit aber keine wirkliche Intelligenz impliziere. Ihr Output enthalte oft sachliche Ungenauigkeiten und irrationale Schlussfolgerungen, die Modelle seien nicht auf logisches Denken trainiert. Es gäbe viele sinnvolle Anwendungsfälle, etwa das Coden, und sein Team habe gerade ein Projekt gestartet, das systematisch weiter nach sinnvollen Anwendungen suche.

Menschen neigten jedoch oft dazu, sprachliche Gewandtheit mit Rationalität gleichzusetzen, was dazu führen könne, dass wir Sprachmodelle für intelligenter halten, als sie sind - und dann womöglich ihre Fähigkeiten überschätzen. Er argumentierte, dass wir gegenüber dieser Tendenz wachsam sein und Chatbots nicht anthropomorphisieren sollten.

Sprachmodelle sind nicht bereit für den Einsatz in sensiblen Bereichen

Martell warnte vor den Gefahren einer unverantwortlichen Einführung von KI im Militär. Er wies auch auf die hohe kognitive Belastung hin, die es für den Menschen bedeute, Sprachmodelle manuell auf Fehler zu überprüfen.

Er plädierte daher für die Entwicklung zuverlässiger Mechanismen zur automatischen Validierung von Ausgaben, bevor diese verwendet werden. Diese Forderung war Teil seiner Kernbotschaft: Sprachmodelle brauchen eine Kultur der verantwortungsvollen Entwicklung ohne Hype.

KI-Gemeinschaft soll Akzeptanzbedingungen für Sprachmodelle entwickeln

Die KI-Gemeinschaft müsse Standards entwickeln, um die Sicherheit der Modelle in verschiedenen Kontexten zu überprüfen, einschließlich klar definierter Akzeptanzbedingungen, ähnlich wie es sie beim autonomen Fahren gibt.

Sprachmodelle hätten ein großes wissenschaftliches Potenzial, seien aber noch keine fertigen Produkte. Bevor sie in sensiblen Bereichen eingesetzt werden könnten, sei es wichtig, ihre Grenzen zu erforschen und sie zuverlässig zu machen. Dabei sieht er die Hacker-Community als wichtigen Partner: "Ich bin heute hier, weil ich von allen Hackern wissen möchte, wo diese Modelle brechen. Denn wenn wir nicht wissen, wie sie brechen, können wir die Akzeptanzbedingungen nicht verstehen. Und wenn wir die Akzeptanzbedingungen nicht kennen, können wir die Industrie auch nicht dazu bringen, die Dinge zu bauen, die wir brauchen, damit wir sie einsetzen und nutzen können".