Neural Rendering für Menschen: HumanNeRF synthetisiert 3D-Ansichten von Personen aus einem simplen YouTube-Video.

Methoden des Neural Renderings versprechen altbewährte Verfahren des 3D-Renderings durch Künstliche Intelligenz zu erweitern oder gar zu ersetzen. Ein Beispiel sind die sogenannten Neural Radiance Fields (NeRFs), kleine neuronale Netze, die 3D-Repräsentationen aus 2D-Fotos lernen und anschließend rendern können.

Die Technologie erzeugt seit ihrer Erfindung immer realistischere Bilder. Einige Varianten können mittlerweile in wenigen Sekunden komplexe 3D-Repräsentationen lernen und rendern. Nvidia gab etwa auf der diesjährigen GTC Einblicke in Instant NeRF, eine Methode, die bis zu 1000-mal schneller als alte Methoden ist.

David Luebke, Vize-Präsident für Grafikforschung bei Nvidia verglich NeRFs mit der JPEG-Kompression für 2D-Fotografie: "Wenn herkömmliche 3D-Darstellungen wie Polygonnetze mit Vektorbildern vergleichbar sind, dann sind NeRFs wie Bitmap-Bilder. Sie erfassen, wie Licht von einem Objekt oder innerhalb einer Szene abstrahlt", so Luebke.

Das erlaube eine "enorme Steigerung der Geschwindigkeit, Einfachheit und Reichweite der Aufnahme und des Teilens von 3D.“

Google setzt NeRFs für Immersive View ein

Pionier der NeRF-Entwicklung ist Google. Das Unternehmen entwickelte die NeRFs in Kooperation mit Wissenschaftlern der UC Berkeley und UC San Diego. Seitdem zeigte Google KI-gerenderte Straßenblöcke, die eine Art Street View 3D ermöglichen, und fotorealistische 3D-Renderings von Echtwelt-Objekten dank Mip-NeRF 360.

Auf der diesjährigen Entwicklerkonferenz I/O 2022 zeigte Google dann Immersive View, eine synthetisierte 3D-Perspektive von Großstädten und einzelnen Innenansichten wie Restaurants, die auf die entwickelten Neural-Rendering-Methoden zurückgreifen.

Video: Google

Nun zeigen Forschende der Universität Washington und Google, wie NeRFs Personen in 3D rendern können.

NeRFs für Menschen: Bewegung und Kleidung bisher eine Herausforderung

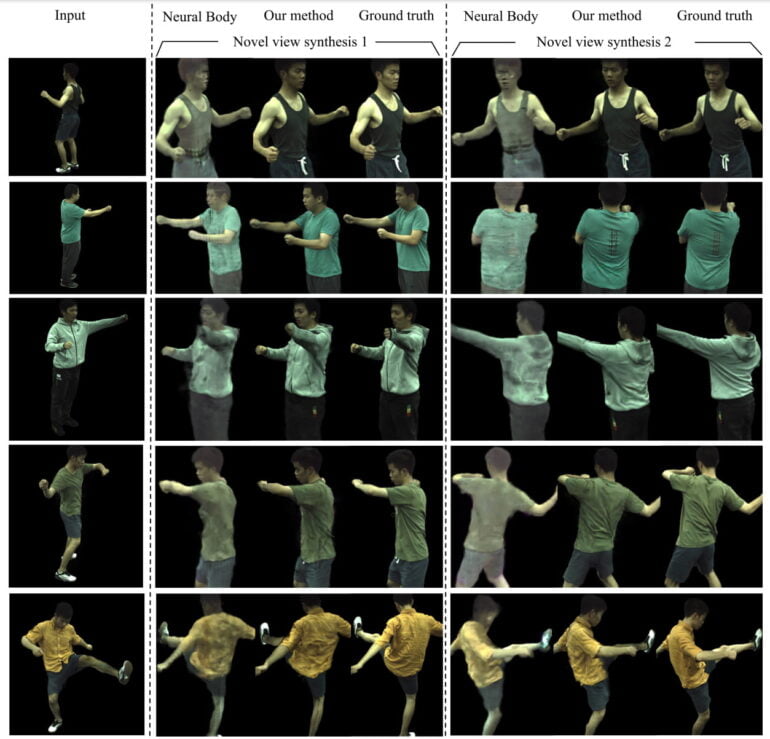

Die neue Methode HumanNeRF löst gleich zwei Probleme bei der Repräsentation von Menschen mit NeRFs: Bisher arbeiten die Netze primär mit statischen Objekten und setzten auf Kameraaufnahmen aus mehreren Winkeln.

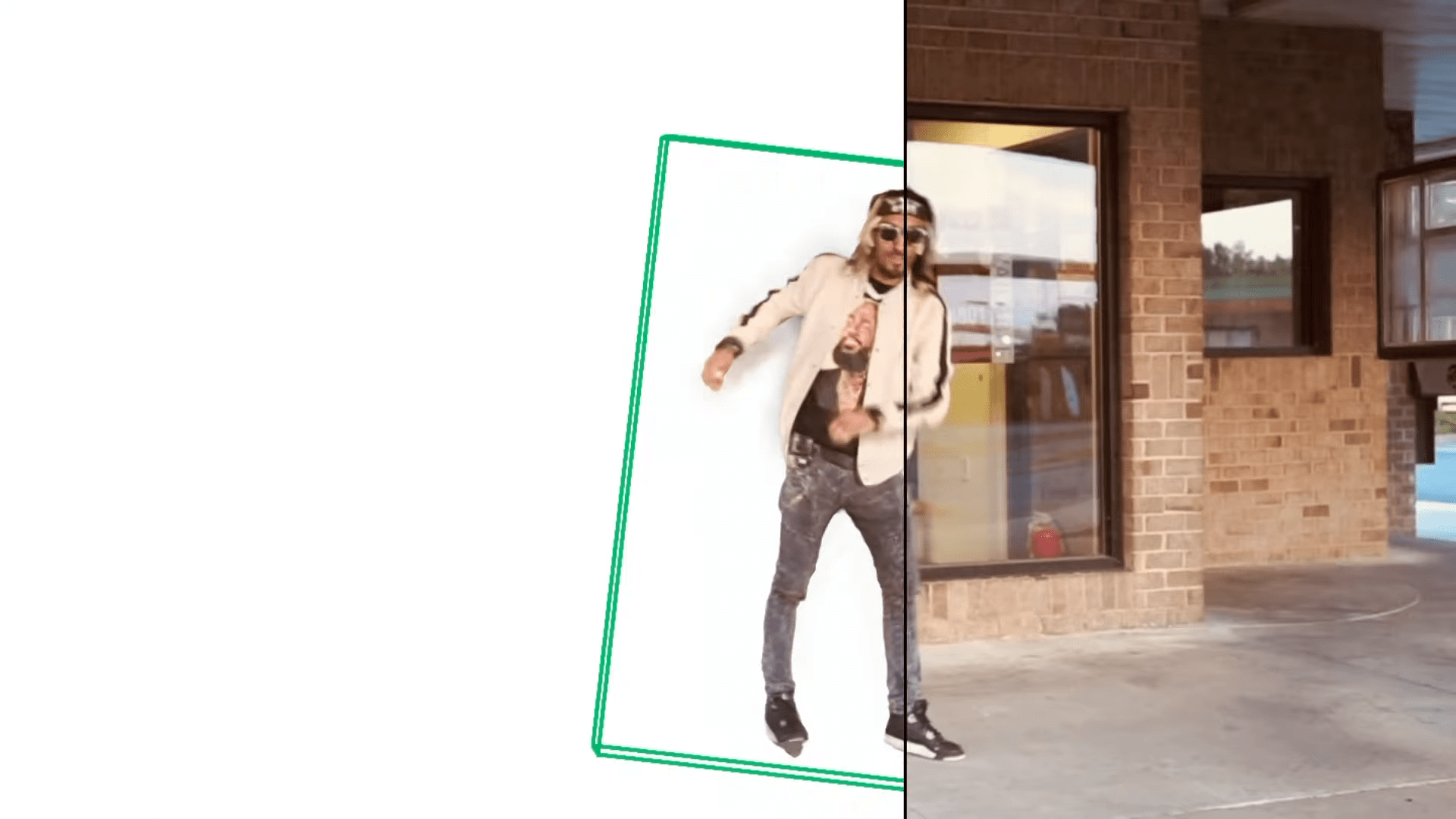

HumanNeRF kann dagegen sich bewegende Menschen inklusive der Bewegungen ihrer Kleidung aus bisher nicht gesehenen Blickwinkeln darstellen - und das mit Trainingsmaterial einer einzigen Kameraperspektive. Dadurch lassen sich die NeRFs auch mit einem YouTube-Video trainieren, in dem etwa eine tanzende Person frontal gefilmt wird.

Video: Weng et al. | University of Washington | Google

HumanNeRF setzt auf mehrere Netze, die eine kanonische Darstellung der Person in einer sogenannten T-Pose, sowie ein sogenanntes Bewegungsfeld (motion field), das eine starre Skelettbewegung und nicht starre Bewegungen etwa der Kleidung lernen. Die Pose der gefilmten Person wird zusätzlich mit einem simplen Netz für Posen-Einschätzung erfasst.

Die gelernten Informationen des Bewegungsfeldes und der Posen-Einschätzung können anschließend die gelernte kanonische Repräsentation entsprechend der im Video gezeigten Pose modifizieren und anschließend aus dem NeRF rendern.

Für Google ist HumanNeRF erst der Anfang

Die Methode erlaubt so deutlich realistischere 3D-Darstellungen als bisherige Methoden: Die gerenderten Personen sind detaillierter und Bewegungen in der Kleidung sind deutlich zu sehen.

In mehreren Beispielen zeigen die Forschenden, dass ein einziger Kamerawinkel für das 3D-Rendering reicht - der Einsatz "in-the-wild" ist so möglich, etwa für YouTube-Videos.

HumanNeRF kann nach dem Training zudem die komplette gelernte Szene aus dem direkt gegenüberliegenden Blickwinkel darstellen - das ist besonders herausfordernd, da kein einziger gerenderter Pixel jemals im Training sichtbar war.

Als Einschränkungen nennen die Forschenden fehlende Details und ein wahrnehmbares Ruckeln beim Übergang zwischen verschiedenen Posen, da die zeitliche Kohärenz im Bewegungsfeld nicht beachtet werde.

Der technologische Fortschritt hat zudem seinen Preis: Für das Training benötigte das Team 72 Stunden auf vier GeForce RTX 2080 Ti GPUs. Sie verweisen jedoch auf Ergebnisse wie Nvidias Instant-NGP, das die benötigte Rechenleistung für NeRFs und andere Neural-Rendering-Methoden drastisch senkt.

Mit einigen Verbesserungen und niedrigeren Rechenanforderungen könnte die Technologie so langfristig auch bei Endnutzer:innen ankommen und Google einen weiteren Baustein für die AR-Zukunft bieten, die auf der diesjährigen I/O deutlich gezeichnet wurde.

Wer mehr über Neural Rendering und NeRFs erfahren will, kann sich unsere DEEP MINDS Folge #8 mit Nvidia-Forscher Thomas Müller anschauen. Müller ist unter anderem Co-Autor von Instant-NGP und Instant NeRFs.