Hunyuan GameCraft wandelt Bilder in interaktive Gaming-Videos um

Tencent hat mit Hunyuan-GameCraft ein neues KI-Framework vorgestellt, das aus einzelnen Bildern interaktive Videos erzeugt.

Während herkömmliche Videogeneratoren lediglich vorgefertigte Sequenzen liefern, erweitert GameCraft das Konzept um eine interaktive Komponente: Nutzer:innen können dabei mithilfe von WASD- oder Pfeiltasten die Kameraperspektive in Echtzeit steuern und sich frei durch die generierten Szenen bewegen.

Technische Grundlage ist das Text-zu-Video-Modell HunyuanVideo, das Tencent bereits als Open Source vorgestellt hat. Laut Tencent ermöglicht das System besonders flüssige und konsistente Kamerafahrten, was das Erlebnis immersiver und realistischer wirken lässt.

Video: Tencent

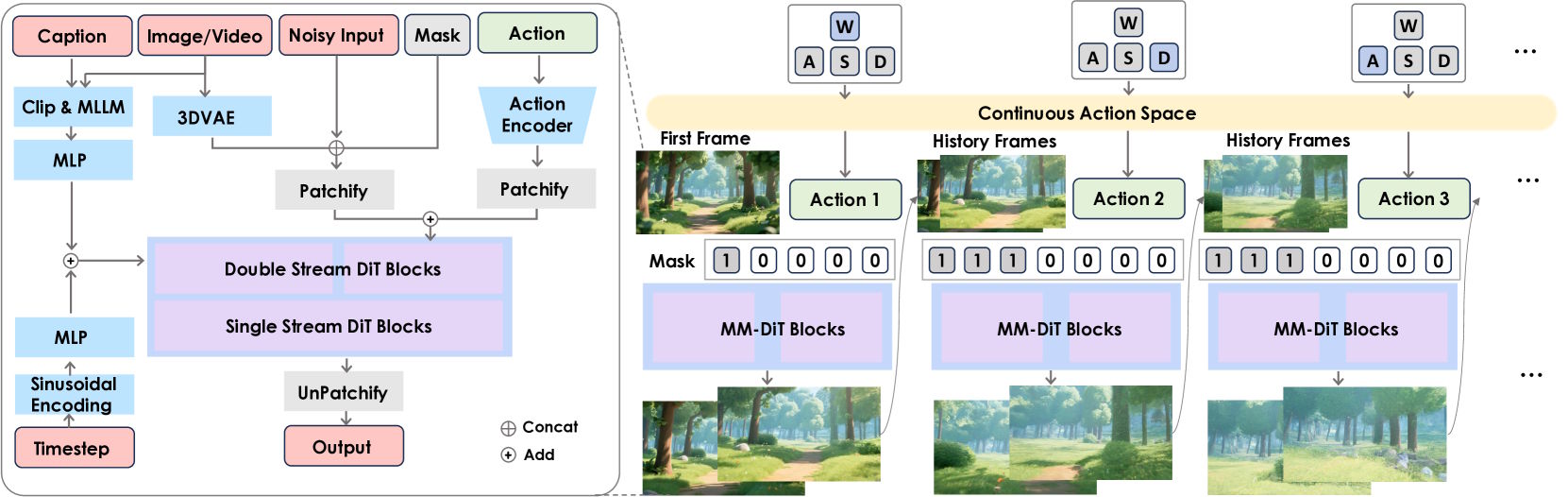

Das Framework nutzt eine mathematische Repräsentation, um Kameraposition und -orientierung im dreidimensionalen Raum präzise zu beschreiben. Dabei kommen drei Translationsachsen zum Einsatz – für Bewegungen nach vorn und hinten, links und rechts sowie oben und unten – sowie zwei Rotationsachsen für horizontale und vertikale Drehungen. Auf Rollbewegungen um die Vorwärtsachse wurde verzichtet, da diese im Gaming-Kontext untypisch seien.

Ein sogenannter Action Encoder verarbeitet die Nutzereingaben und wandelt sie in numerische Repräsentationen um, die für das Videogenerierungsmodell verständlich sind. Zusätzlich berücksichtigt das System Geschwindigkeitsparameter, sodass die Bewegungsdynamik situationsabhängig angepasst werden kann, etwa abhängig davon, wie lange eine Taste gedrückt gehalten wird.

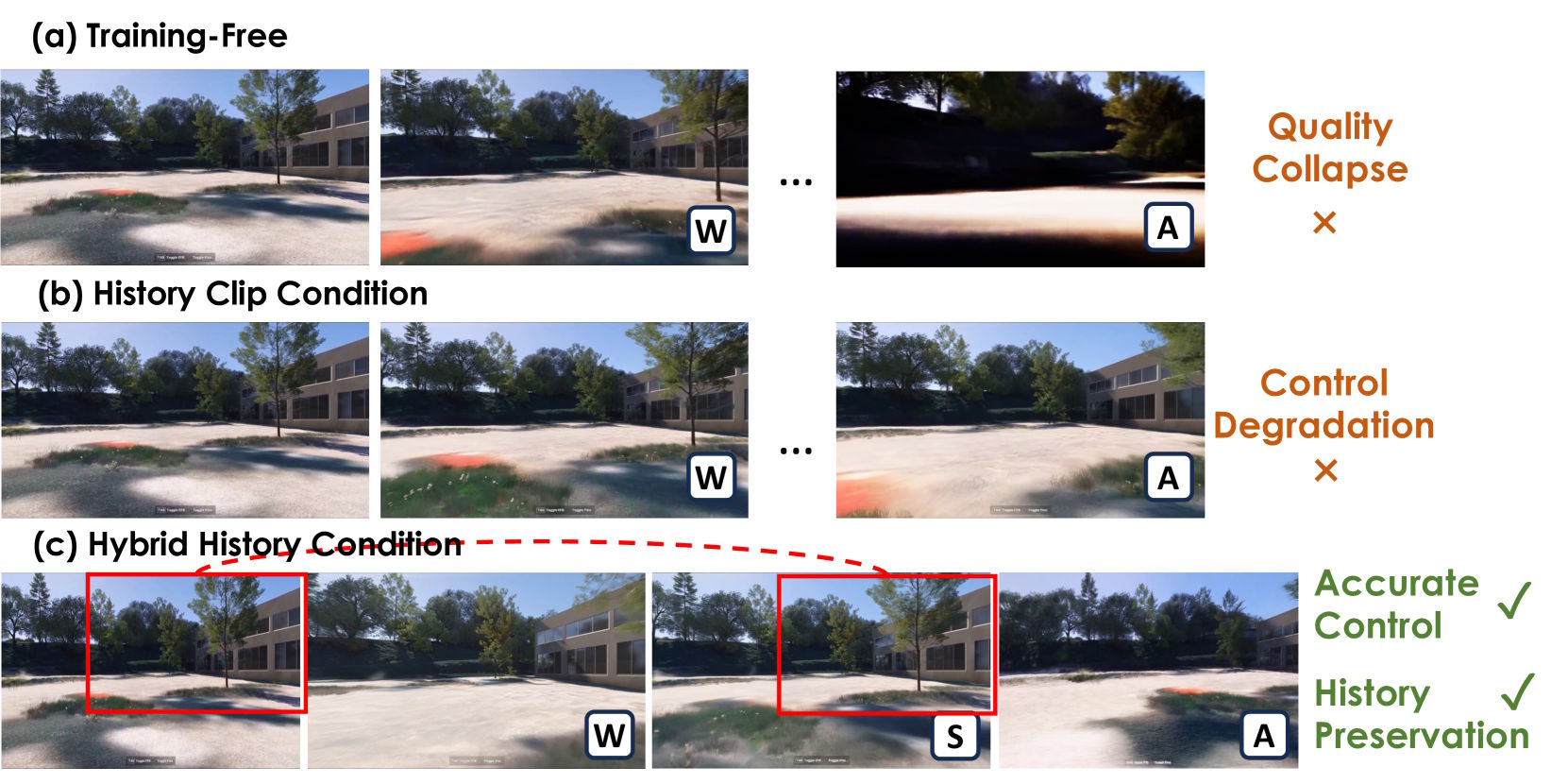

Hybrid-Training verhindert Qualitätsverlust bei langen Videos

Um Qualitätsverluste bei längeren Videosequenzen zu vermeiden, setzt Tencent in Hunyuan-GameCraft auf eine spezielle Trainingsmethode namens Hybrid History-Conditioned Training. Dieses Verfahren sorgt dafür, dass neue Videoinhalte schrittweise erzeugt werden, wobei jeder neue Abschnitt auf dem vorherigen aufbaut. Die einzelnen Videos werden dabei in etwa 1,3 Sekunden lange Segmente unterteilt.

Eine binäre Maske bestimmt, welche Bildbereiche bereits existieren und welche noch generiert werden müssen. So kann das Modell gezielt zwischen vorhandenem und neuem Material unterscheiden und dabei sowohl Konsistenz als auch Flexibilität wahren.

Während Training-freie Verfahren oft zu sichtbarem Qualitätsverlust führen und reine History Clip Conditioning-Ansätze die Reaktionsfähigkeit auf neue Nutzereingaben einschränken, gelingt es laut Hunyuan der hybriden Strategie, beide Aspekte miteinander zu verbinden. Das Ergebnis sind flüssige, konsistente Videos, die auch bei längerer Dauer unmittelbar auf Eingaben reagieren können.

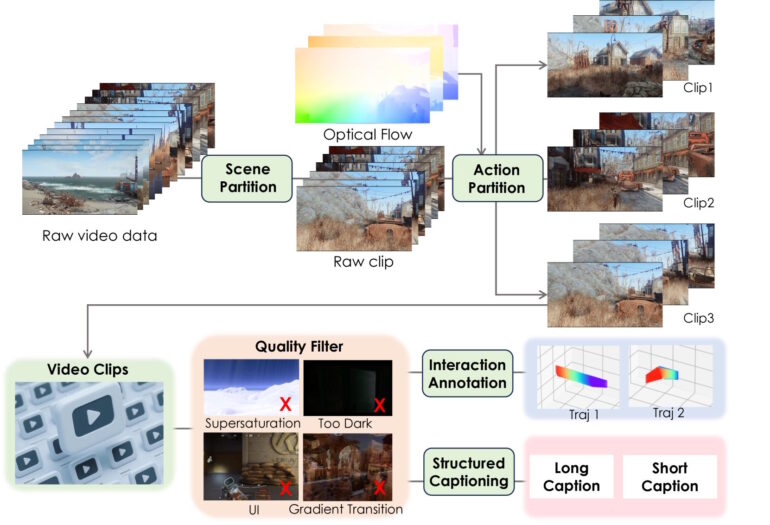

Training mit über einer Million Gameplay-Aufzeichnungen

Hunyuan-GameCraft wurde mit über einer Million automatisch ausgewerteter Gameplay-Aufzeichnungen trainiert. Die Daten stammen aus mehr als 100 AAA-Spielen wie Assassin’s Creed, Red Dead Redemption und Cyberpunk 2077. Szenen und Aktionen wurden dabei automatisch segmentiert, qualitätsgefiltert, annotiert und strukturiert beschrieben.

Zusätzlich erstellten die Entwickler:innen 3.000 Motion-Sequenzen aus digitalen 3D-Objekten. Das Training lief in zwei Phasen auf 192 Nvidia-H20-GPUs über 50.000 Iterationen.

In Vergleichstests mit Matrix-Game reduzierte Hunyuan-GameCraft Interaktionsfehler um 55 Prozent. Auch gegenüber spezialisierten Kamerasteuerungsmodellen wie CameraCtrl, MotionCtrl und WanX-Cam erreichte es bessere Werte bei Bildqualität und Steuerpräzision.

"Echtzeit-Rendering" mit fünf Sekunden Latenz

Um Hunyuan-GameCraft für den praktischen Einsatz zu beschleunigen, haben die Entwickler:innen das Phased Consistency Model (PCM) integriert. Diese Technik verkürzt den Videogenerierungsprozess, indem sie nicht alle Schritte der rechenintensiven Diffusion durchläuft, sondern gezielt Zwischenschritte überspringt und direkt zu plausiblen Endergebnissen führt. Dadurch erhöht sich die Inferenzgeschwindigkeit um das 10- bis 20-Fache.

Das System erreicht so eine Echtzeit-Rendering-Rate von 6,6 Bildern pro Sekunde und reduziert die Reaktionslatenz nach einer Eingabe auf unter fünf Sekunden. Intern arbeitet GameCraft mit 25 Bildern pro Sekunde und verarbeitet Videosegmente aus 33 Einzelbildern in 720p-Auflösung. Diese Kombination aus Qualität und Geschwindigkeit macht die interaktive Steuerung erst praktikabel.

Der Code inklusive Modellgewichten ist auf GitHub verfügbar, eine Web-Demo ist angekündigt.

GameCraft reiht sich damit in eine wachsende Zahl interaktiver KI-"Weltmodelle" ein. Tencent hatte zuvor bereits das Hunyuan World Model 1.0 vorgestellt, das aus Text- oder Bildvorgaben 3D-Szenen erzeugt, allerdings noch auf statische 360-Grad-Panoramen beschränkt ist. Konkurrenz kommt unter anderem von Google DeepMind mit Genie 3 und dem Open-Source-Projekt Matrix-Game 2.0 des Start-ups Skywork.

KI-News ohne Hype – von Menschen kuratiert

Mit dem THE‑DECODER‑Abo liest du werbefrei und wirst Teil unserer Community: Diskutiere im Kommentarsystem, erhalte unseren wöchentlichen KI‑Newsletter, 6× im Jahr den „KI Radar"‑Frontier‑Newsletter mit den neuesten Entwicklungen aus der Spitze der KI‑Forschung, bis zu 25 % Rabatt auf KI Pro‑Events und Zugriff auf das komplette Archiv der letzten zehn Jahre.

Jetzt abonnierenKI-News ohne Hype

Von Menschen kuratiert.

- Mehr als 20 Prozent Launch-Rabatt.

- Lesen ohne Ablenkung – keine Google-Werbebanner.

- Zugang zum Kommentarsystem und Austausch mit der Community.

- Wöchentlicher KI-Newsletter.

- 6× jährlich: „KI Radar“ – Deep-Dives zu den wichtigsten KI-Themen.

- Bis zu 25 % Rabatt auf KI Pro Online-Events.

- Zugang zum kompletten Archiv der letzten zehn Jahre.

- Die neuesten KI‑Infos von The Decoder – klar und auf den Punkt.