Große Sprachmodelle können den Zugang zu Informationen erleichtern - doch KI-Forscher Andrew J. Peterson warnt vor einem negativen Langzeiteffekt: einem "Wissenskollaps".

Der massive Einsatz von KI zur Wissensgenerierung und -vermittlung könne zu einer Homogenisierung und Einschränkung des öffentlich verfügbaren Wissens führen, so Peterson. Besonders besorgniserregend sei der potenzielle Verlust von "Long-tail"-Wissen, also seltenem oder spezialisiertem Wissen, das möglicherweise nicht in den Hauptdatensätzen enthalten ist, auf denen KI-Modelle trainiert werden.

"Auf viele Fragen der realen Welt gibt es keine klar definierten, nachweislich richtigen oder falschen Antworten", so der Forscher. Wenn ein Nutzer etwa frage: "Was verursacht Inflation?" und ein Sprachmodell antwortet: "Geldpolitik", dann liege das Problem nicht in einer Halluzination, sondern darin, dass es nicht gelungen sei, die gesamte Bandbreite möglicher Antworten auf die Frage wiederzugeben oder zumindest einen Überblick über die wichtigsten wirtschaftlichen Denkschulen zu geben.

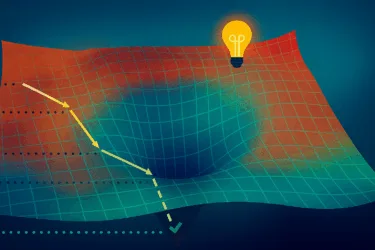

Peterson definiert den Wissenskollaps daher als die im Laufe der Zeit fortschreitende Verringerung der den Menschen zur Verfügung stehenden Informationsmenge, verbunden mit einer damit einhergehenden Verringerung der wahrgenommenen Verfügbarkeit und Nützlichkeit verschiedener Informationsmengen. Damit geht nicht nur Wissen verloren - der Effekt schränkt auch den "epistemischen Horizont" ein, den Peterson als die Menge an Wissen definiert, die eine Gemeinschaft von Menschen für praktisch möglich und wissenswert hält.

Dieser Effekt könnte durch verschiedene Faktoren noch verstärkt werden, etwa durch rekursiv abhängige KI-Systeme, also die Verwendung von KI-generierten Inhalten als Input für andere KI-Systeme. Dies gleiche dem Spiel "Stille Post", bei dem eine Nachricht von Person zu Person weitergereicht wird und sich dabei immer weiter vom Original entfernt.

Modell zeigt, dass günstige KI-Inhalte Wissenskollaps begünstigen

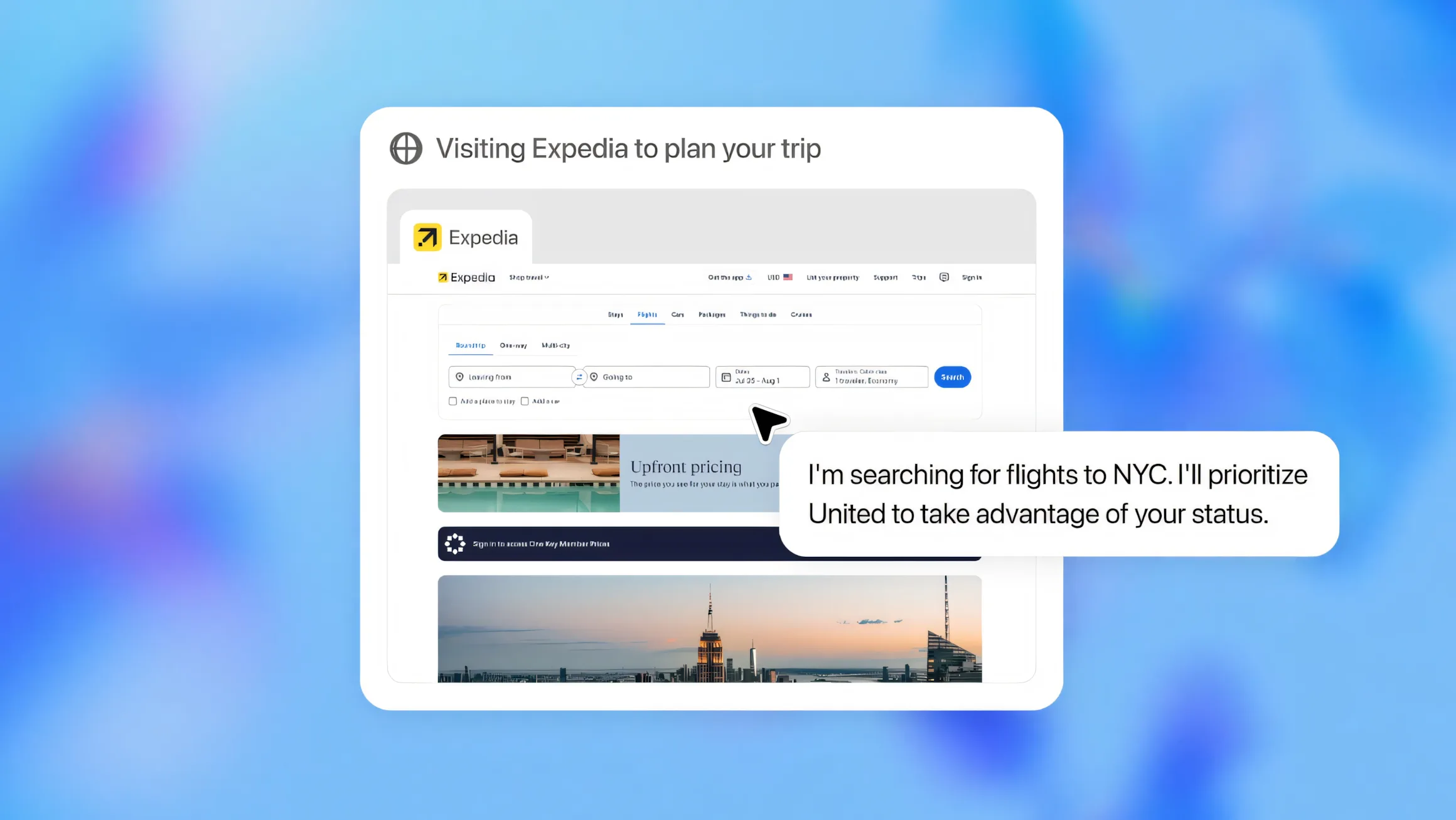

Um diesen Effekt und mögliche Gegenmaßnahmen zu untersuchen, simuliert Peterson in einem Modell Individuen, die sich entscheiden können, ob sie in Innovation oder Lernen auf "traditionelle" Weise investieren, durch einen möglicherweise billigeren KI-gestützten Prozess oder ohne KI. Eine Schlüsseldynamik des Modells besteht darin, die Möglichkeit zuzulassen, dass rationale Agenten in der Lage sein können, Verzerrungen zu vermeiden oder zu korrigieren, die sich aus einer übermäßigen Abhängigkeit von "zentristischen" Informationen ergeben. Also etwa, ob sie sich darauf beschränken, von der KI generierte Zusammenfassungen von Artikeln oder Monografien zu lesen, oder ob sie tatsächlich Zeit und Geld investieren, um die Originalquellen zu studieren.

Peterson will damit herausfinden, unter welchen Bedingungen die Individuen ausreichend informiert sind, um einen Wissenskollaps in der Gesellschaft zu verhindern. Er zeigt, dass - zumindest in seinem Modell - die Zugangskosten der zentrale Dreh- und Angelpunkt sind. Je billiger es ist, auf KI-generierte Inhalte zurückzugreifen, desto extremer ist die "Degeneration des öffentlichen Wissens zur Mitte hin", schreibt er. Mit anderen Worten: Günstige KI-Inhalte verstärken den Wissenskollaps, da sie häufiger gewählt werden und das öffentliche Wissen so immer weiter auf diese KI-Inhalte und ihre "Wahrheit" einschränken.

Wie der Wissenskollaps verhindert werden kann

Um diesen Wissenskollaps zu verhindern, empfiehlt er daher mehrere Ansätze:

1. Menschen müssen weiterhin aktiv daran arbeiten, Nischenwissen und ungewöhnliche Perspektiven zu suchen und zu bewahren. Nur so kann die Vielfalt des Wissens erhalten bleiben. Dazu könnten Anreize für Investitionen in "Tail-Knowledge" gehören, etwa durch staatliche Förderung oder Urheberrechtsanpassungen. Das würde dem Effekt der geringeren Kosten entgegenwirken.

2. KI-Systeme sollten so konzipiert werden, dass sie die gesamte Bandbreite des Wissens möglichst repräsentativ abbilden und nicht nur den Mainstream fokussieren. Eine zu starke Vereinfachung oder Verengung der Darstellung sollte vermieden werden.

3. Rekursive Abhängigkeiten zwischen KI-Systemen, bei denen die Ausgabe eines Systems als Eingabe für das nächste dient, müssen verhindert werden. Ansonsten droht sich eine Verzerrung des Wissens zu verstärken.

Insbesondere beim KI-Einsatz in Bildung sei außerdem wichtig, dass die Lernenden nicht nur den Wahrheitsgehalt der von der KI generierten Antworten berücksichtigen, "sondern auch deren Varianz, Repräsentativität und Verzerrung, d.h. inwieweit sie die gesamte Verteilung der möglichen Antworten auf eine Frage repräsentieren."