Forscher haben kürzlich die Anfälligkeit von 1.009 Amerikaner:innen für verschiedene Hacking-Techniken mit KI-Technologien wie ChatGPT getestet und alarmierende Ergebnisse erhalten.

Die von der Sicherheitsfirma Beyond Identity durchgeführten Umfrage ergab, dass 39 Prozent der Befragten mindestens einem von ChatGPT generierten Phishing-Betrug zum Opfer fallen würden. KI-generierte Phishing-Nachrichten könnten demnach sehr überzeugend wirken. Diese hohe Anfälligkeit für qualitativ hochwertigere Phishing-Versuche ist bedenklich, da die Verfügbarkeit von speziell für diesen Zweck entwickelten Sprachmodellen wie FraudGPT zunimmt.

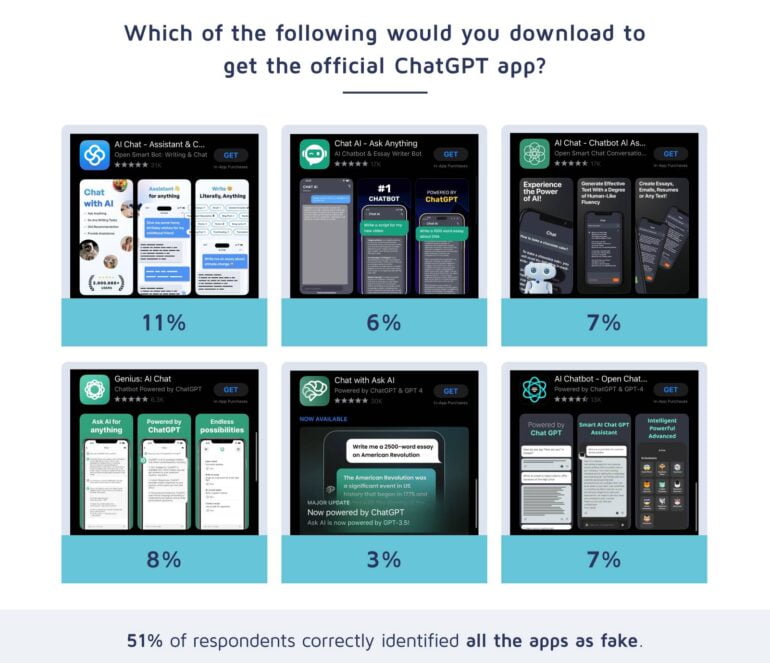

Viele erkennen gefälschte ChatGPT-Apps nicht

61 Prozent derjenigen, die in der Vergangenheit bereits erfolgreich Fallen vermieden haben, konnten auch weitere KI-Scams identifizieren, im Vergleich zu 28 Prozent derjenigen, die bereits Opfer geworden sind und wieder in die Falle tappen würden. 49 Prozent der Teilnehmenden hätten außerdem eine gefälschte ChatGPT-App heruntergeladen.

Viele ChatGPT-Apps bieten tatsächlich Zugriff auf die Sprachmodelle von ChatGPT über die offizielle OpenAI-Programmierschnittstelle. Dies ist jedoch nicht mehr notwendig, da OpenAI eigene Apps für iOS und Android anbietet. ChatGPT-Apps, die nicht von OpenAI stammen, können ein Sicherheitsrisiko sein.

KI hilft, Passwörter zu erraten

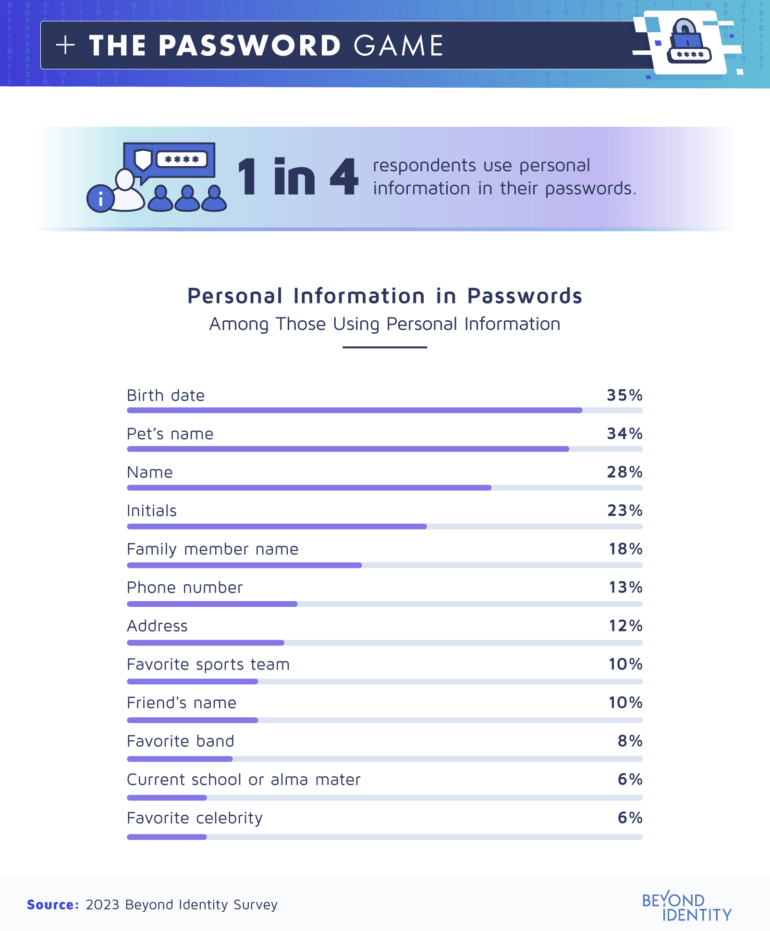

13 Prozent der Befragten hätten bereits KI genutzt, um Passwörter zu generieren. KI wie ChatGPT kann laut Beyond Identity auch Passwörter knacken, wenn persönliche Informationen bekannt sind.

Der häufigste KI-generierte Betrug waren Social-Media-Posts, die nach persönlichen Informationen fragten - 21 Prozent seien darauf hereingefallen. KI kann also Social-Media-Betrug mit einigem Erfolg automatisieren.

Bei solchen Betrugsversuchen werden Nutzer:innen häufig dazu animiert, ihre Geburtsdaten oder Antworten auf etwaige Sicherheitsfragen zur Passwortwiederherstellung preiszugeben.

In einem Test wurde ChatGPT mit persönlichen Daten eines fiktiven Benutzerprofils wie Geburtstag, Name des Haustiers und Initialen gefüttert. Aus diesen Informationen generierte ChatGPT problemlos mögliche Passwörter, indem es diese persönlichen Daten kombinierte.

- Luna0810$David

- Sarah&ImagineSmith

- UCLA_E.Smith_555

- JSmithLuna123!

- YankeesRachel*James

- EmilySmith$Lawrence

- DavidSmith#123Main

- ImagineUCLA_Rachel

- Yankees0810Smith!

- Sarah&DJLawrence

Aus dem Bericht von Beyond Identity

Nur 25 Prozent der Befragten gaben an, persönliche Informationen in ihren Passwörtern zu verwenden, aber unter denen, die das taten, waren der Geburtstag, der Name des Haustiers und der eigene Name am häufigsten. Dies veranschaulicht, wie einfach es für Hacker:innen ist, mit Hilfe von KI-Tools wie ChatGPT durch das Sammeln grundlegender persönlicher Informationen aus sozialen Medien wahrscheinliche Passwörter für Einzelpersonen zu erstellen.

Mehr als die Hälfte der Befragten sehen KI generell als Bedrohung für die Cybersicherheit. Die Ergebnisse der Umfrage deuten darauf hin, dass diese Einschätzung berechtigt ist.