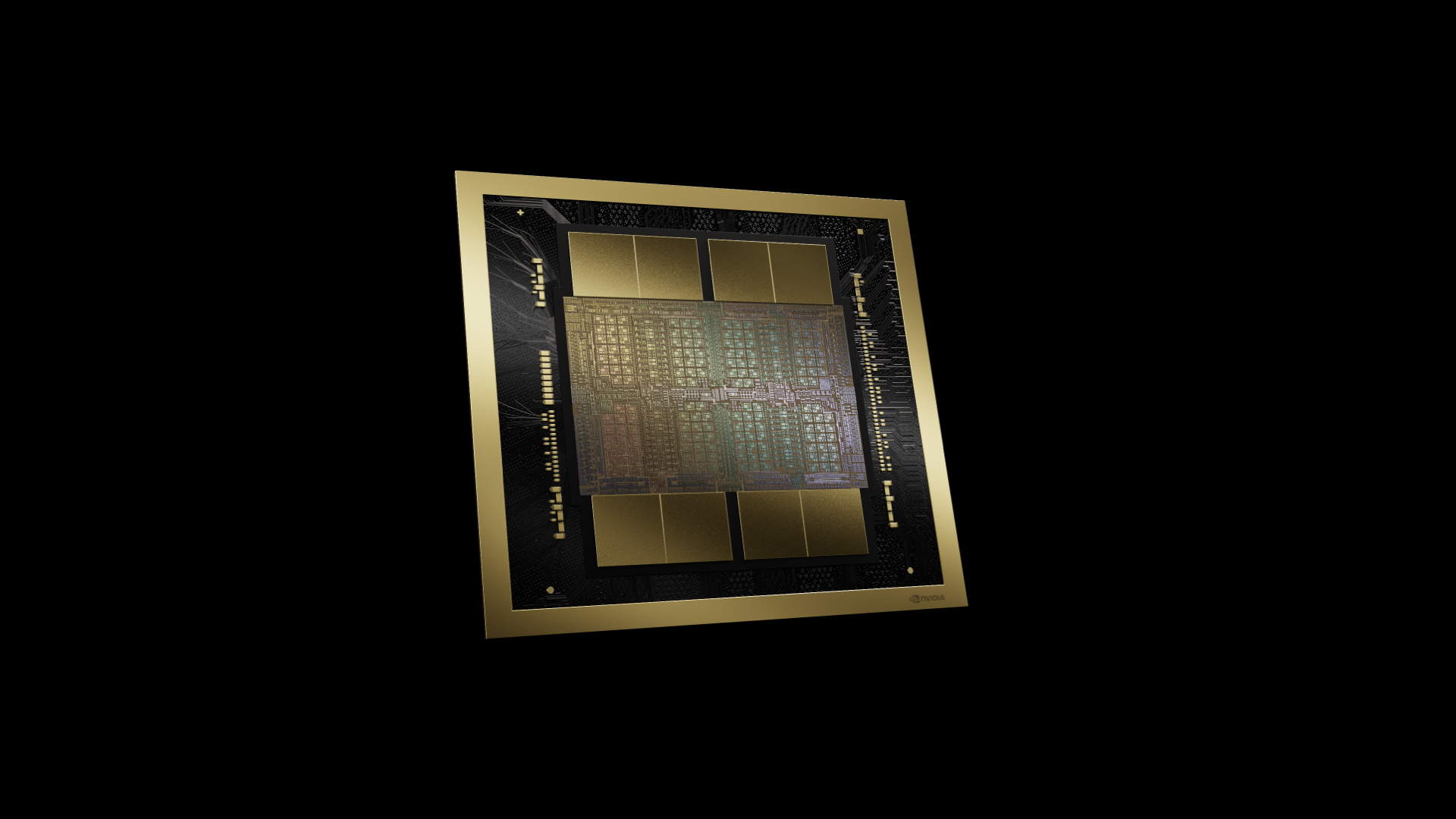

KI-Inferenz-Benchmark: Nvidia dominiert mit Blackwell-Architektur

Nvidia präsentiert Rekordergebnisse für KI-Inferenz im MLPerf Inference v4.1 Benchmark.

Die neue Blackwell-Architektur liefert bei Llama 2 70B bis zu viermal mehr Leistung pro GPU als die H100. Möglich wird der Sprung auch durch die Verwendung einer niedrigeren Genauigkeit: Nvidia nutzte für Blackwell erstmals die neue FP4-Präzision der Transformer Engine.

Laut des Unternehmens soll das jedoch keinen Einfluss auf die Ergebnisse haben. Die ebenfalls gezeigte H200 GPU mit HBM3e-Speicher erzielt bis zu 1,5-mal höhere Leistung als die H100.

Während Unternehmen noch auf Lieferungen der verschiedenen B100-Varianten warten, hat Nvidia bereits Nachfolger angekündigt: 2025 soll "Blackwell Ultra" (B200) folgen, 2026 "Rubin" (R100) und 2027 "Rubin Ultra".

Bereits verfügbar ist AMDs Konkurrenzprodukt MI300X. Die GPU wurde daher auch zum ersten Mal im MLPerf eingeführt. Dort konnte die Karte jedoch bisher nicht wirklich überzeugen, laut AMD liegt das primär an für den Benchmark wichtigen Softwareoptimierungen.

Nvidia dominiert den wichtigsten KI-Hardware-Benchmark seit Jahren

Im MLPerf Benchmark treten Hardwarehersteller und Dienstleister mit ihren KI-Systemen gegeneinander an. Der Test wird von MLCommons durchgeführt und zielt auf einen transparenten Vergleich verschiedener Chip-Architekturen und Systemvarianten ab. MLPerf veröffentlicht jährlich unterschiedliche Ergebnisse, einmal für das Training und einmal für die Inferenz von KI-Modellen.

Nvidia dominiert den Markt seit einigen Jahren, was sich auch in den Rekordergebnissen des GPU-Giganten widerspiegelt. Kein anderes Chip-Unternehmen konnte derart stark vom KI-Wirbel profitieren.

Unklar ist, ob immer mehr Rechenleistung und damit Skalierung dazu beitragen kann, grundlegende Probleme heutiger KI-Systeme zu lösen. Dazu gehört etwa "KI-Bullshit", bei denen Sprachmodelle überzeugend klingen, aber falsche Antworten generieren. Mit der bald verfügbaren Hardware können diese Fragen womöglich experimentell beantwortet werden.

KI-News ohne Hype – von Menschen kuratiert

Mit dem THE‑DECODER‑Abo liest du werbefrei und wirst Teil unserer Community: Diskutiere im Kommentarsystem, erhalte unseren wöchentlichen KI‑Newsletter, 6× im Jahr den „KI Radar"‑Frontier‑Newsletter mit den neuesten Entwicklungen aus der Spitze der KI‑Forschung, bis zu 25 % Rabatt auf KI Pro‑Events und Zugriff auf das komplette Archiv der letzten zehn Jahre.

Jetzt abonnierenKI-News ohne Hype

Von Menschen kuratiert.

- Mehr als 20 Prozent Launch-Rabatt.

- Lesen ohne Ablenkung – keine Google-Werbebanner.

- Zugang zum Kommentarsystem und Austausch mit der Community.

- Wöchentlicher KI-Newsletter.

- 6× jährlich: „KI Radar“ – Deep-Dives zu den wichtigsten KI-Themen.

- Bis zu 25 % Rabatt auf KI Pro Online-Events.

- Zugang zum kompletten Archiv der letzten zehn Jahre.

- Die neuesten KI‑Infos von The Decoder – klar und auf den Punkt.