Nvidias GTC 2024 steht ganz im Zeichen der generativen KI - und der Hardware, die diesen Boom erst möglich macht. Mit der nächsten Generation von Blackwell will Nvidia neue Maßstäbe setzen.

Laut CEO Jensen Huang wird Blackwell "die treibende Kraft hinter der neuen industriellen Revolution" sein. Die Plattform verspricht, den Betrieb von generativer KI mit Sprachmodellen mit bis zu mehreren Billionen Parametern zu ermöglichen.

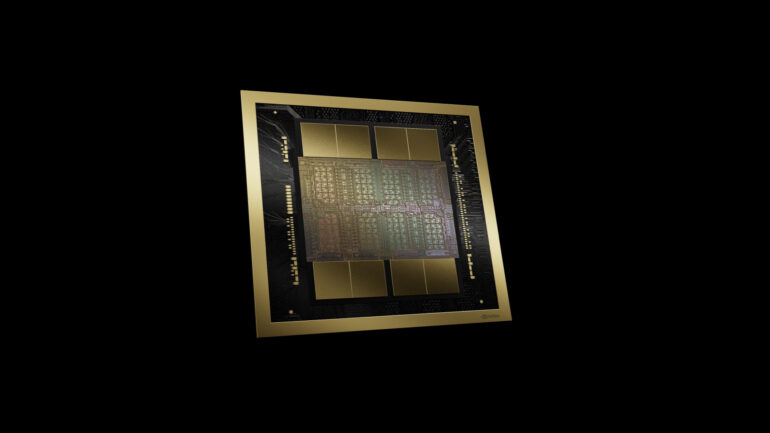

Die Architektur umfasst laut Nvidia den leistungsstärksten Chip der Welt mit 208 Milliarden Transistoren. Konkret verbindet Blackwell zwei mit TSMCs 4NP Prozess gefertigte Dies mit einer Verbindungsgeschwindigkeit von 10 TB/Sekunde, sodass sie wie eine einzige CUDA-GPU arbeiten. Darüber hinaus enthält Blackwell eine zweite Generation der Transformer Engine, die KI-Anwendungen mit FP4-Genauigkeit ermöglicht, eine verbesserte NVLink-Kommunikationstechnologie für den Datenaustausch zwischen bis zu 576 Grafikprozessoren und eine neue Zuverlässigkeits- und Service-Engine (RAS Engine), die unter anderem vorbeugende Wartung durch KI ermöglicht. Eine dedizierte Dekompressions-Engine soll zudem Datenbankabfragen beschleunigen.

Blackwell wird in FP8 eine KI-Rechenleistung von 10 PetaFLOPS und in FP4 von 20 PetaFLOPS bereitstellen. Bei Verwendung der neuen Transformer-Engine mit sogenanntem "Micro Tensor Scaling" sind damit die doppelte Rechenleistung, die doppelte Modellgröße und die doppelte Bandbreite möglich. Außerdem ist der Chip mit 192 Gigabyte HBM3e-Speicher ausgestattet.

Im Vergleich zum Grafikprozessor H100 soll Blackwell eine viermal höhere Trainingsleistung, eine bis zu 25-mal höhere Energieeffizienz und eine bis zu 30-mal höhere Inferenzleistung bieten. Letzteres ist ein deutliches Zeichen dafür, dass sich Nvidia der Konkurrenz der auf Inferenz spezialisierten Chips stellt, die derzeit versuchen, dem Platzhirsch Marktanteile abzujagen. Diese Leistung wird allerdings nur mit sogenannten Mixture-of-Expert-Modellen wie GPT-4 erreicht, bei klassischen großen Transformationsmodellen wie GPT-3 liegt der Sprung bei 7x. MoE-Modelle werden aber immer wichtiger, auch Googles Gemini setzt auf dieses Prinzip. Möglich wird der deutliche Sprung durch das neue NVLink und NVLink Switch 7.2, das eine effizientere Kommunikation zwischen den GPUs ermöglicht - bisher ein Flaschenhals bei MoE-Modellen.

Nvidia erwartet, dass die Blackwell-Plattform von fast allen großen Cloud-Anbietern und Serverherstellern eingesetzt wird. Unternehmen wie Amazon Web Services, Google, Meta, Microsoft und OpenAI werden zu den ersten gehören, die Blackwell einsetzen.

Neues DGX SuperPOD mit 11,5 ExaFLOPs

Mit der neuen Generation ist auch eine neue Version des DGX SuperPOD verfügbar. Der DGX SuperPOD verfügt über eine neue, hocheffiziente, flüssigkeitsgekühlte Rack-Scale-Architektur und bietet 11,5 ExaFLOPS KI-Supercomputing-Leistung bei FP4-Präzision und 240 Terabyte schnellen Speicher. Das System kann mit zusätzlichen Racks auf Zehntausende von Chips skaliert werden.

Herzstück des SuperPOD ist ein GB200 NVL72, der 36 Nvidia GB200 Superchips mit je 36 Grace CPUs und 72 Blackwell GPUs über Nvidias NVLink der fünften Generation zu einem Supercomputer verbindet. Laut Nvidia bieten die GB200 Superchips eine bis zu 30-fache Leistungssteigerung im Vergleich zu der gleichen Anzahl Nvidia H100 Tensor Core GPUs für Inferenz-Workloads mit großen Sprachmodellen. Ein DGX GB200 NVL72 sei im Prinzip dank des neuen NVLink Chip "eine gigantische GPU" mit 720 PetaFLOPS für Training FP8, mit 1,44 ExaFLOPS für Inferenz in FP4.

Nvidia präsentierte auch das DGX B200 System, eine Plattform für KI-Modelltraining, Feinabstimmung und Inferenz. DGX B200 ist die sechste Generation der luftgekühlten DGX Designs und verlinkt acht B200 Tensor Core GPUs mit CPUs. Beide Systeme werden im Laufe des Jahres verfügbar sein.