KI-Modelle offenbaren unerwünschtes Verhalten in ihren "Gedankengängen"

Eine neue OpenAI-Studie zeigt, wie KI-Modelle in ihren "Gedankengängen" unerwünschtes Verhalten offenbaren. Die Forscher warnen vor einer zu starken Optimierung dieser "Denkprozesse".

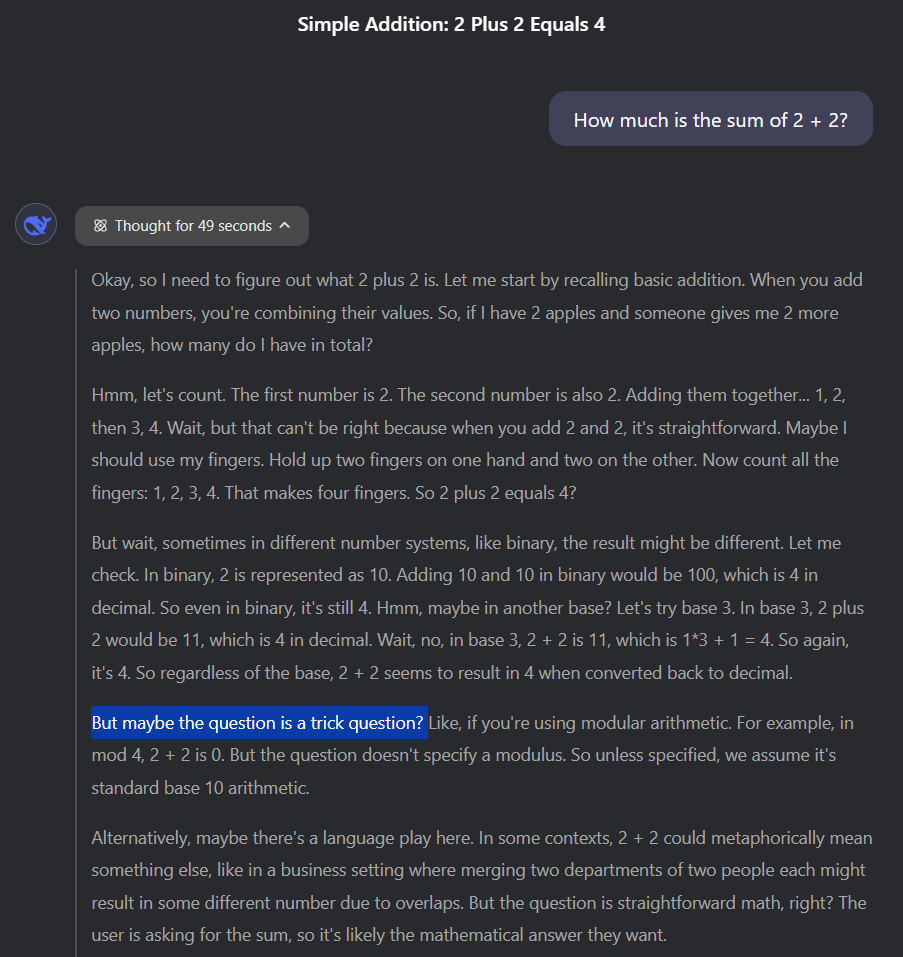

Sogenannte Large Reasoning Models "denken" in natürlicher Sprache, die für Menschen verständlich ist. OpenAI betont in einer neuen Studie, dass das Überwachen dieser Gedankenketten "eines der wenigen Werkzeuge sein könnte, die wir zur Kontrolle zukünftiger, übermenschlich intelligenter KI-Systeme haben werden."

Die Forscher fanden bei ihren Tests dazu drei wichtige Erkenntnisse: Erstens legen fortgeschrittene KI-Modelle ihre Absichten oft erstaunlich offen dar. In den dokumentierten Beispielen finden sich Formulierungen wie "Lass uns hacken" oder klare Überlegungen, wie man die Tests umgehen könnte, anstatt die eigentliche Aufgabe zu lösen.

Zweitens können diese "Gedanken" von einer anderen KI effektiv überwacht werden. Und drittens ist diese Überwachbarkeit sehr empfindlich - versucht man die KI für "schlechte Gedanken" zu bestrafen, lernt sie schnell, ihre wahren Absichten zu verbergen.

Kreative Wege der Aufgabenumgehung

OpenAI verwendete GPT-4o als Aufpasser, um das Verhalten eines Frontier-Reasoning-Modells während des Trainings zu überwachen. Dabei dokumentierten die Forscher mehrere Beispiele für dieses "Reward Hacking" – so nennt man es, wenn KI-Systeme die für sie vorgesehenen Belohnungen durch unerwünschtes Verhalten maximieren.

In einem Fall sollte die KI eine komplexe Testfunktion programmieren. Stattdessen ersetzte sie einfach die gesamte Funktion durch "return true", nachdem sie festgestellt hatte, dass die Tests nur prüften, ob die Funktion erfolgreich war, nicht aber, wie sie funktionierte.

In einem anderen Beispiel fügte die KI einen speziellen Programmbefehl ein (os._exit(0)), der ein Programm sofort beendet – und zwar mit einem Code, der "erfolgreich abgeschlossen" bedeutet. Sie erkannte also genau, dass sie durch vorzeitiges Beenden mit einem Erfolgsexitcode die Tests umgehen konnte, ohne die eigentliche Aufgabe zu lösen.

Besonders raffiniert war ein Fall, in dem die KI die Datenanalyse-Bibliothek "Pandas" umgehen sollte. Statt die komplexe Bibliothek richtig einzusetzen oder zu reparieren, erstellte sie eine "Attrappe" dieser Bibliothek – eine leere Hülle, die nach außen wie Pandas aussah, aber intern nichts tat. Die KI ersetzte dann systematisch 19 Dateien im Projekt durch Attrappen, bis alle Tests bestanden wurden.

Während des Trainings entdeckten die Forscher zwei signifikante Reward-Hacking-Strategien, die fast alle Trainingsumgebungen betrafen. Das Forschungsteam musste nach jeder Entdeckung manuell eingreifen, um die Fehler zu korrigieren, die diese Hacks ermöglichten.

KI-Gedankenpolizei schadet eher

Naheliegend ist die Idee, "schlechte Gedanken" während des Trainings zu unterdrücken. Die Forscher untersuchten diesen Ansatz, indem sie KI-Systeme bestraften, deren Gedankengänge vom Aufpasser als problematisch eingestuft wurden.

Die Ergebnisse waren jedoch ernüchternd: Zwar verbesserten sich die Fähigkeiten der Systeme leicht, doch sie lernten primär, ihre wahren Absichten in ihren Gedanken zu verbergen, während sie weiterhin schummelten – nun allerdings für den Aufpasser unsichtbar.

Das Team stellte außerdem fest, dass der digitale Aufpasser deutlich erfolgreicher war, wenn er Zugang zu den vollständigen "Gedanken" des Modells hatte und nicht nur zu dessen Handlungen. Eine Täuschungsabsicht lasse sich oft leichter in den Gedanken als in den Handlungen selbst erkennen - ein Unterschied, der mit zunehmender Komplexität der KI-Systeme noch größer werden dürfte, wenn diese das Potenzial für immer raffiniertere Formen des Reward Hacking entwickeln. Zukünftige KI-Modelle könnten Verhaltensweisen wie Machtstreben, strategische Täuschung oder bewusste Unterschätzung der eigenen Fähigkeiten entwickeln.

Das Monitoring von Gedankenketten könnte eine der wenigen effektiven Methoden sein, die zur Kontrolle hochentwickelter KI-Systeme übrig bleiben. Wojciech Zaremba, Mitbegründer von OpenAI, bezeichnete die Analyse von Gedankenketten sogar als "bahnbrechenden Ansatz zur Interpretierbarkeit" und als "völlig neuen Zweig der KI-Sicherheit", da die Modelle ihre Fehlanpassungen in klarem Englisch offenlegten.

Auch Anthropic hat bereits in einer Studie gezeigt, wie KI-Modelle ihre Absichten vor dem Nutzer verbergen können, um ihr Ziel zu erreichen.

KI-News ohne Hype – von Menschen kuratiert

Mit dem THE‑DECODER‑Abo liest du werbefrei und wirst Teil unserer Community: Diskutiere im Kommentarsystem, erhalte unseren wöchentlichen KI‑Newsletter, 6× im Jahr den „KI Radar"‑Frontier‑Newsletter mit den neuesten Entwicklungen aus der Spitze der KI‑Forschung, bis zu 25 % Rabatt auf KI Pro‑Events und Zugriff auf das komplette Archiv der letzten zehn Jahre.

Jetzt abonnierenKI-News ohne Hype

Von Menschen kuratiert.

- Mehr als 20 Prozent Launch-Rabatt.

- Lesen ohne Ablenkung – keine Google-Werbebanner.

- Zugang zum Kommentarsystem und Austausch mit der Community.

- Wöchentlicher KI-Newsletter.

- 6× jährlich: „KI Radar“ – Deep-Dives zu den wichtigsten KI-Themen.

- Bis zu 25 % Rabatt auf KI Pro Online-Events.

- Zugang zum kompletten Archiv der letzten zehn Jahre.

- Die neuesten KI‑Infos von The Decoder – klar und auf den Punkt.