Mit Captum will Facebook Entwicklern helfen, die Entscheidungen ihrer KIs nachzuvollziehen.

Künstliche Intelligenz soll nachvollziehbarer werden, da sind sich Forscher, Politiker und NGOs einig. Eine Technologie, die über Zugang zu Krediten, zur Gesundheitsversorgung oder über die persönliche Freiheit mitentscheidet, darf keine Blackbox sein.

Nachvollziehbarkeit kann helfen, Vorurteile aufzudecken und neue Erkenntnisse bringen, die uns sonst verborgen blieben: etwa wenn eine KI für die Krebsdiagnose einen unbekannten Zusammenhang zwischen einer Genmutation und Tumorstruktur erkennt.

Google, IBM und Microsoft bieten bereits Werkzeuge an, mit denen ein Blick in die Blackbox KI geworfen werden kann. Nun schließt sich Facebook mit einer eigenen Lösung an.

Facebook Captum erklärt KI

Facebooks nennt die Lösung "Captum", das lateinische Wort für Verständnis. Captum ist eine Software-Bibliothek für die von Facebook entwickelte Tensorflow-Alternative PyTorch. Intern setzt Facebook bereits auf das Werkzeug, nun ist es für alle frei bei Github verfügbar.

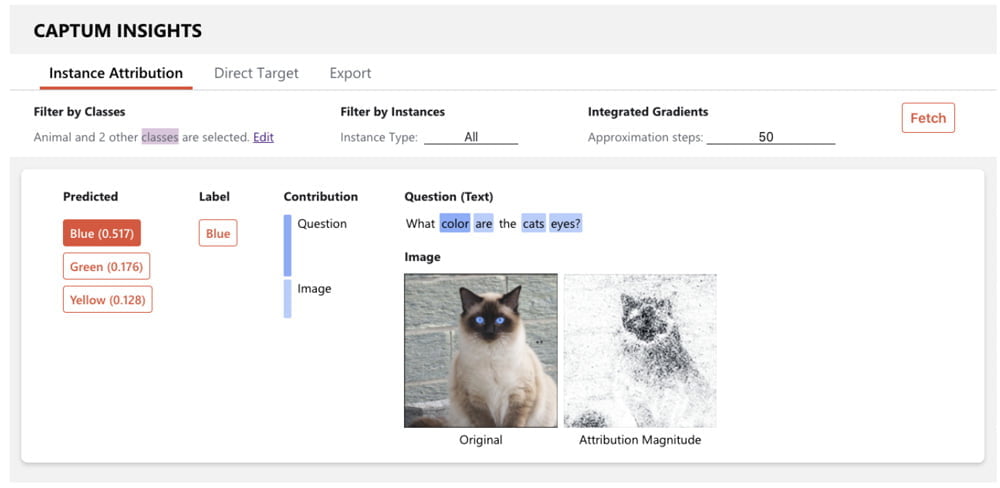

Captum enthält aktuelle Algorithmen wie Integrated Gradients oder DeepLIFT, die helfen, herauszufinden, welche Signale im Netzwerk eine Rolle bei dessen Entscheidungsfindung spielen. So kann zum Beispiel festgestellt werden, welche Pixel eines Bildes für die Motiv-Vorhersage einer KI verantwortlich sind.

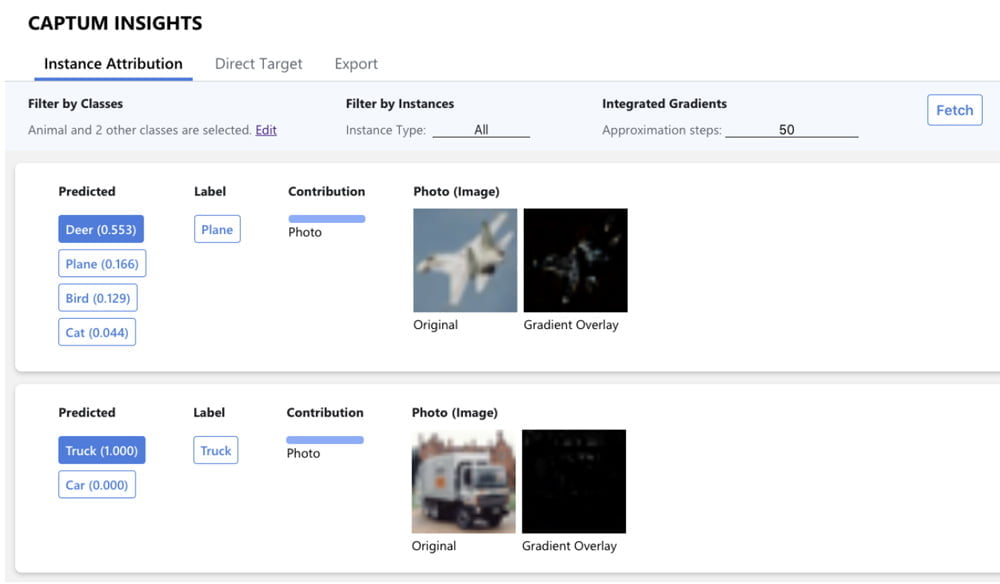

Mit Captum kommt auch Captum Insights, ein Werkzeug zur Visualisierung der Ergebnisse von Captum. Das soll vor allem KI-Anwendern ermöglichen, den Durchblick zu wahren – und Entwicklern helfen, die Ergebnisse ihrer Systeme besser zu erklären.

Titelbild: Facebook,Quelle: Facebook