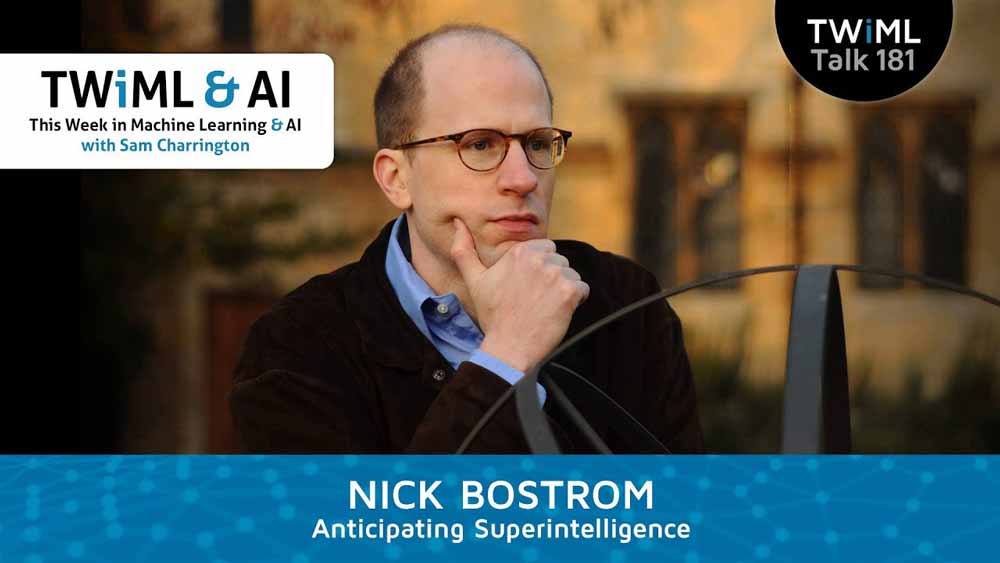

Der Philosoph Nick Bostrom spricht über die Gefahren einer Superintelligenz und wie KI-Sicherheitsforschung mit ihnen umgehen sollte. Ich fasse die wesentlichen Punkte des Interviews für euch zusammen.

Nick Bostrom ist Autor der 2014 erschienenen Monographie „Superintelligenz“ und Professor für angewandte Ethik in Oxford sowie Vorsitzender des dort von ihm gegründeten Future of Humanity Instituts. Er ist außerdem wissenschaftlicher Berater des Future of Life Instituts.

In seinem Buch erörtert Bostrom die Möglichkeit einer künstlichen Superintelligenz. Diese könne aus einer Allgemeinen Künstlichen Intelligenz (AGI) entstehen, die unser Intelligenzniveau erreicht und es durch Selbstverbesserung explosionsartig überschreitet.

Bostrom geht auf daraus resultierende Gefahren und den Umgang mit ihnen ein. Sein Buch brachte KI-Sicherheit stärker in die öffentliche Debatte, da es unter anderem von Bill Gates und Elon Musk empfohlen wurde.

Grundsätzliche Sicherheitsprobleme

In einem Podcast (siehe unten) unterscheidet Bostrom zwei Bereiche der KI-Sicherheit: Risiken, die von der KI selbst ausgehen und Risiken, die durch den Missbrauch von KI durch Menschen entstehen.

Beide Risiken gebe es schon mit heutiger Künstlicher Intelligenz. Doch Bostrom ist der Ansicht, dass die aktuellen Gefahren überschätzt und die zukünftiger KIs unterschätzt werden: Erst eine Superintelligenz könne die Entwicklung der Menschheit nachhaltig verändern. Aktuelle KI-Technologie könne höchstens einen kleinen Rückschlag auslösen.

Wann erwartet uns eine Superintelligenz?

Doch ab wann sollten wir uns Sorgen machen? Da bisher keine klare Vorstellung der Architektur einer AGI existiere, seien Prognosen schwierig.

Überhaupt gibt Bostrom nicht viel auf menschliches Prognosetalent: „Es ist schwer vorstellbar, was ein verlässlicher Indikator für die Entwicklung einer AGI innerhalb von zum Beispiel fünf Jahren sein könnte. Ich glaube, es ist wahrscheinlicher, dass wir durch einen dichten Wald stolpern und plötzlich auf einer Lichtung stehen - und die Ziellinie ist nur ein paar Meter entfernt.“

Bostrom ist daher der Meinung, wir „sollten die Zeit, die wir noch haben, nutzen“, um sinnvolle Regeln für den Umgang mit Künstlicher Intelligenz aufzustellen. Eine ähnliche Position vertritt OpenAI-Mitgründer Ilya Sutskever.

Wie sollen wir uns der KI-Sicherheit nähern?

Bostrom betont, dass KI-Sicherheitsforschung eine prä-paradigmatische Wissenschaft sei, also eine Wissenschaft, in der Untersuchungsgegenstand und Methoden noch nicht etabliert sind. Bisher sei nicht einmal völlig klar, was überhaupt das zu lösende Problem sei.

Eine wahrscheinliche Stolperfalle sei das sogenannte „Alignment-Problem“: Wie bringen wir unsere Wünsche mit den Zielen einer KI auf eine Linie? Klar sei, dass feste Regeln, wie etwa Asimovs Roboterregeln, nicht geeignet seien.

Erstens sei es wahrscheinlich, dass unsere Moral noch immer blinde Flecken aufweist. Bostroms Beispiel: Eine Künstliche Intelligenz mit der Moral der antiken Griechen wäre heute moralisch deutlich überholt.

Zweitens sei nicht klar, ob eine Superintelligenz diese Regeln nicht umgehen könne oder ungewünscht interpretiere. Ziel sei daher ein dynamisches System, das nicht blind Regeln folgt.

Intellektuelle Fähigkeiten und Transparenz

Bostrom hält es daher für vielversprechend, auf die intellektuelle Kapazität einer AGI zu setzen: Sie sollte von uns lernen oder daran interessiert sein, was wir wollen.

Damit keine Fehlorientierung stattfindet, wäre eine AGI mit „gesundem Menschenverstand“ wünschenswert. Die würde zum Beispiel erkennen, dass man aus Menschen keine Büroklammern machen sollte.

Abseits dieser theoretischen Grundlagenarbeit sieht Bostrom Zukunft in der praktischen Entwicklung von KIs. Es entstünden Interpretationswerkzeuge für neuronale Netze, die für mehr Transparenz sorgen könnten. Aktuell ist es nicht möglich, die Entscheidungen eines komplexen neuronalen Netzes vollständig nachzuvollziehen.

Solche Technologien könnten auf lange Sicht helfen, die Vorgänge in einer AGI zu verstehen, so Bostrom.

Ressource Bildung

All diese theoretischen Erwägungen könnten sich allerdings als völlig nutzlos herausstellen, sagt Bostrom. Denn welche Architektur eine AGI hervorbringen könnte, ist unbekannt. Es ist daher vorstellbar, dass die bisherigen Annahmen der Sicherheitsforscher in einigen Jahrzehnten überholt sind.

"Dann wäre eine Forschungsgemeinschaft nützlich, die über Jahre ein immer besseres Verständnis von KI-Sicherheitsproblemen entwickelt hat. Die Forscher können ihre Fähigkeiten und Kenntnisse dann auf die AGI-Systeme anwenden, die wir früher oder später bauen werden", sagt Bostrom.

KI-Forschern, die sich nicht mit Sicherheit befassen, empfiehlt Bostrom eine Kehrtwende. Es sei wichtig, dass sie sich dem Gemeinwohl verpflichten. Selbst wenn sie nicht von der Möglichkeit einer Superintelligenz überzeugt seien, hätte der Fokus auf Sicherheit Vorteile: Unmoralische staatliche oder private KI-Projekte hätten es dann schwer, kompetente Mitarbeiter*innen zu finden.

Das komplette Interview gibt es im folgenden Video: