Künstliche Intelligenz: Google-Werkzeug gibt Einblick ins KI-Hirn

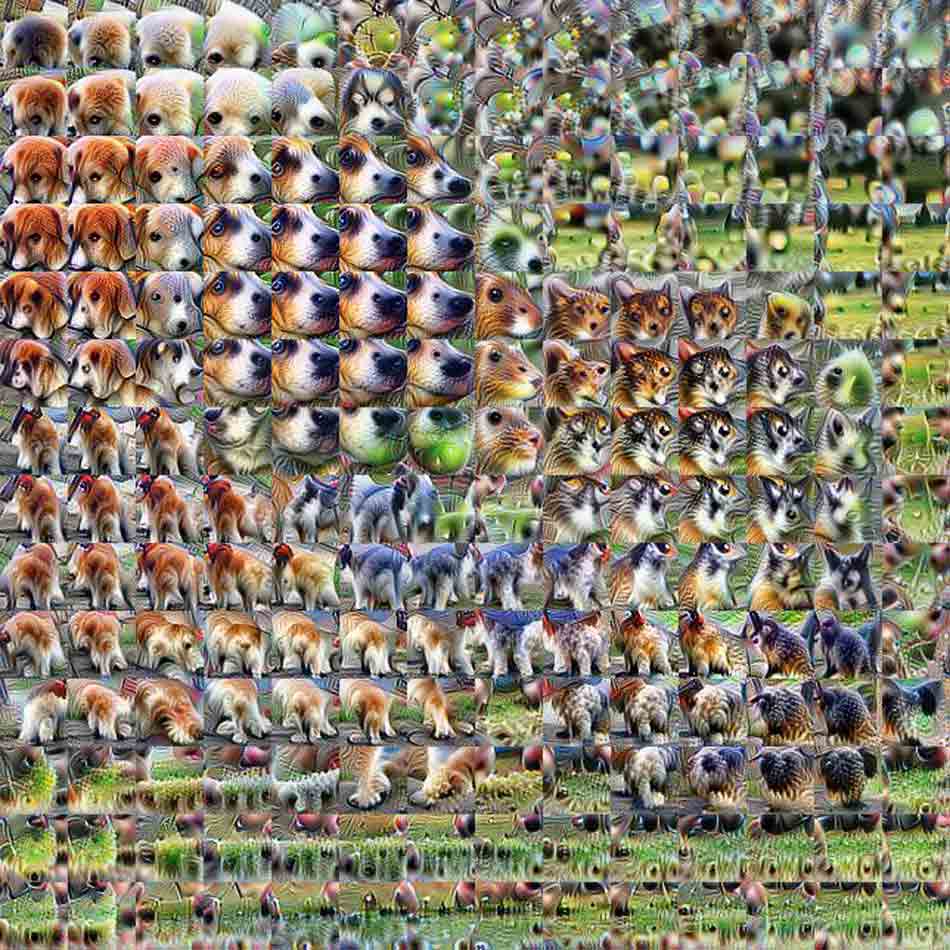

Ein neues Google-Werkzeug gibt Einblicke in den Entscheidungsprozess einer Künstlichen Intelligenz während einer Bildanalyse. Die Visualisierungen würden in einer Kunstausstellung wohl nicht weiter auffallen.

Googles KI-Forscher wollen Licht ins Dunkel der KI-Blackbox bringen. Dafür entwickeln sie ein Werkzeug, das visualisiert, wie eine Künstliche Intelligenz zum Beispiel den Unterschied zwischen Katze und Hund zu verstehen lernt.

In Googles Beispiel-Analyse untersuchen die künstlichen Neuronen Schlappohr- und Spitzohrfaktoren, die jeweils mit einem Zahlenwert belegt werden. So hat beispielsweise ein Beagle einen deutlich höheren Schlappohrfaktor als ein Golden Retriever.

Ein sehr geringer Schlappohrfaktor in Kombination mit einem hohen Spitzohrfaktor deutet wiederum auf eine Katze hin. Laut Google hat die im Beispiel verwendete Bildanalyse-KI Googlenet zahlreiche solcher Ohr-Detektoren, mit denen sie bis zu 100 verschiedene Hunderassen zuverlässig erkennen kann.

Nachvollziehbare Entscheidungen sollen KI-Akzeptanz fördern

Dass Menschen besser verstehen, wie ein KI-System Entscheidungen fällt, könnte zu ihrer Akzeptanz beitragen. Die Google-Forscher sehen hier Nachholbedarf.

Interessant ist die Google-Analyse zum Beispiel, falls ein selbstfahrendes Auto einen Unfall verursacht. Die Methode könnte womöglich nachvollziehbar machen, an welcher Stelle das Auto eine visuelle Information falsch verarbeitete und so den Fahrfehler produzierte.

Vor wenigen Tagen wurde bekannt, dass Google das US-Militär im "Projekt Maven" mit KI-Verfahren für die Bildauswertung von Drohnenmaterial unterstützt, um Ziele automatisiert zu identifizieren. In diesem Szenario hängen von der Nachvollziehbarkeit von KI-Entscheidungen wahrscheinlich Menschenleben ab.

Allerdings gibt es KI-Forscher wie Facebooks Yann Lecunn oder den Biomediziner und Computerwissenschaftler Vijay Pande, die dazu bereit sind, einen intransparenten Entscheidungsprozess einer Künstlichen Intelligenz hinzunehmen, wenn dafür die Ergebnisse stimmen. Schließlich sei auch die Entscheidungsfindung eines Menschen nicht vollends nachvollziehbar, lautet ihre Argumentation.

Google dokumentiert das Verfahren für die KI-Analyse in einem ausführlichen Artikel mit interaktiven Infografiken. Wer tiefer ins Thema einsteigen möchte, sollte sich diese nicht entgehen lassen.

KI-News ohne Hype – von Menschen kuratiert

Mit dem THE‑DECODER‑Abo liest du werbefrei und wirst Teil unserer Community: Diskutiere im Kommentarsystem, erhalte unseren wöchentlichen KI‑Newsletter, 6× im Jahr den „KI Radar"‑Frontier‑Newsletter mit den neuesten Entwicklungen aus der Spitze der KI‑Forschung, bis zu 25 % Rabatt auf KI Pro‑Events und Zugriff auf das komplette Archiv der letzten zehn Jahre.

Jetzt abonnierenKI-News ohne Hype

Von Menschen kuratiert.

- Mehr als 20 Prozent Launch-Rabatt.

- Lesen ohne Ablenkung – keine Google-Werbebanner.

- Zugang zum Kommentarsystem und Austausch mit der Community.

- Wöchentlicher KI-Newsletter.

- 6× jährlich: „KI Radar“ – Deep-Dives zu den wichtigsten KI-Themen.

- Bis zu 25 % Rabatt auf KI Pro Online-Events.

- Zugang zum kompletten Archiv der letzten zehn Jahre.

- Die neuesten KI‑Infos von The Decoder – klar und auf den Punkt.