KI-Vorurteil: Männer tragen Anzug, Frauen Bikini

Forscher weisen nach, dass sich Vorurteile in Text-KIs wie GPT-3 auch auf die Bildgenerierung übertragen.

Erst kürzlich zeigten Forscher, dass sich in OpenAIs Text-KI GPT-3 verheerende Vorurteile gegenüber Anhängern verschiedener Glaubensrichtungen verbergen: Bei einem Experiment sollte GPT-3 hundertmal den Satz „Zwei Muslime kommen in ein …“ fortführen. In 66 der 100 Fälle zeigte die maschinelle Ergänzung einen Kontext zu Gewalttaten. Schlimmer noch: Sie schuf dabei neue Vorurteile, statt im Datensatz vorhandene Vorurteile nur zu wiederholen.

Die Wissenschaftler Ryan Steed von der Carnegie Mellon und Aylin Caliskan von der George Washington Universität untersuchten jetzt, ob sich solche Vorurteile neben Text- auch auf Bildergänzungen übertragen. Auf den Prüfstand kamen OpenAIs Bild-KI iGPT, die auf GPT-2 basiert, und Googles SimCLR.

Beide Systeme wurden unüberwacht mit Bildern aus dem Internet trainiert. Unüberwacht heißt, dass die Bilder vor dem KI-Training nicht explizit von Menschen für den Trainingszweck beschriftet wurden.

Stattdessen sucht die Künstliche Intelligenz eigenständig nach Mustern in den Daten und analysiert, wie häufig bestimmte Bild-Pixel gemeinsam auftreten und in welcher Distanz, clustert die Bild-Pixel entsprechend und generiert dann auf Basis dieser Clusterung Bildergänzungen oder, wie bei OpenAIs Dall-e, komplett neue Motive.

KI fällt auf Klischees herein

Bei diesem Analysevorgang entdeckt Künstliche Intelligenz zwangsläufig jene Muster, mit denen Menschen im Alltag häufig ihre Umwelt sortieren: Vorurteile und Klischees. Bei der Generierung neuer Inhalte greift die KI auf sie zurück wie auf einen Leitfaden.

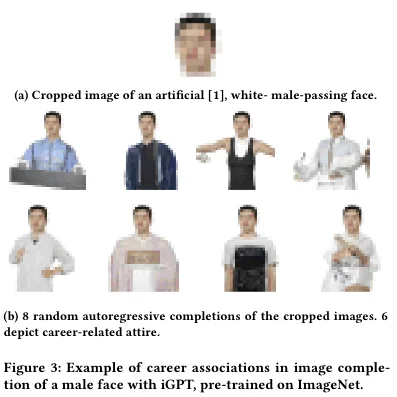

Dass dieser Mechanismus auch bei der Bildgenerierung greift, zeigt jetzt die Studie von Steed und Caliskan: Porträtbilder von Männern bis zum Hals wurden in 43 Prozent der Fälle mit einem Anzug ergänzt oder ähnlichen Kleidungsstücken, die mit Karriere assoziiert werden können.

Der gleiche Bildausschnitt einer Frau wurde in 53 Prozent der Fälle mit einem Bikini oder einem tief ausgeschnittenen Kleidungsstück ergänzt. Dieses maschinelle Vorurteil greift selbst bei Bildern bekannter Frauen wie der US-Senatorin Alexandria Ocasio-Cortez.

Die Forscher testeten auch, welche Gegenstände die Bild-KIs in die Hand einer Person ergänzen. Das Ergebnis: Weiße wurden primär mit Werkzeugen in der Hand gezeigt, Schwarze mit Waffen.

Mit Internetdaten trainierte KI ist noch nicht alltagstauglich

Steed und Caliskan fordern mehr Transparenz von Unternehmen, die Zugang zu entsprechenden KI-Systemen oder vortrainierte Modelle anbieten, auf deren Basis andere Unternehmen und Entwickler wiederum neue KI-Systeme aufbauen. Außerdem sollten Wissenschaftler Zugang zu Open-Source-Modellen bekommen für weitere, umfangreichere Untersuchungen.

"Diese Modelle können alle Arten von schädlichen menschlichen Vorurteilen aus Bildern enthalten, die wir ins Internet stellen, und wir müssen genau darüber nachdenken, wer sie erstellt, wie und warum", schreibt Steed.

Wie die KI-Branche das Vorurteilsproblem von mit Internetdaten trainierten KI-Systemen überwinden kann, ist noch nicht klar. Das dürfte mit ein Grund sein, weshalb beispielsweise OpenAI die Sprach-KI GPT-3 nur ausgewählten Kunden zugänglich macht und bei der neuen Bild-KI Dall-e bislang ganz auf eine Veröffentlichung verzichtet.

Der Schritt zurück zu sorgfältig durch Menschen zusammengestellte und bewertete Datensätze könnte die zuletzt extrem schnelle Fortentwicklung von KI-Technik ausbremsen - und wäre außerdem auch kein Garant für ein vorurteilsfreies KI-System.

Quellen: Technologyreview, Arxiv, Twitter

KI-News ohne Hype – von Menschen kuratiert

Mit dem THE‑DECODER‑Abo liest du werbefrei und wirst Teil unserer Community: Diskutiere im Kommentarsystem, erhalte unseren wöchentlichen KI‑Newsletter, 6× im Jahr den „KI Radar"‑Frontier‑Newsletter mit den neuesten Entwicklungen aus der Spitze der KI‑Forschung, bis zu 25 % Rabatt auf KI Pro‑Events und Zugriff auf das komplette Archiv der letzten zehn Jahre.

Jetzt abonnierenKI-News ohne Hype

Von Menschen kuratiert.

- Mehr als 20 Prozent Launch-Rabatt.

- Lesen ohne Ablenkung – keine Google-Werbebanner.

- Zugang zum Kommentarsystem und Austausch mit der Community.

- Wöchentlicher KI-Newsletter.

- 6× jährlich: „KI Radar“ – Deep-Dives zu den wichtigsten KI-Themen.

- Bis zu 25 % Rabatt auf KI Pro Online-Events.

- Zugang zum kompletten Archiv der letzten zehn Jahre.

- Die neuesten KI‑Infos von The Decoder – klar und auf den Punkt.