Vorausschauend reagiert Google auf ein geschlechtsspezifisches Vorurteil der eigenen GMail-KI "Smart Compose". Die Lösung ist allerdings unbefriedigend und wirft Fragen auf.

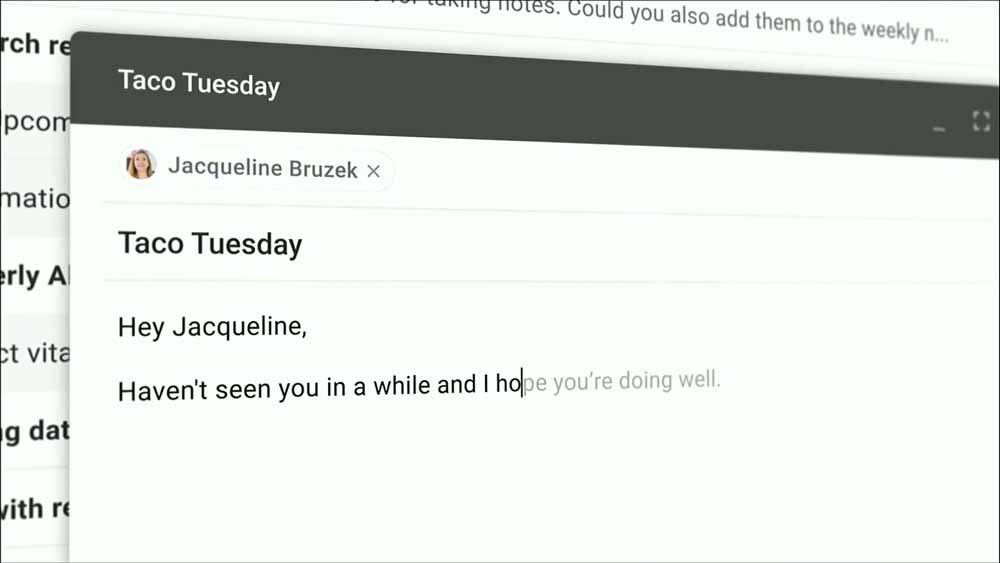

Googles Smart Compose ist seit Mitte 2018 für GMail-Nutzer verfügbar: Die E-Mail-KI schlägt - anders als eine einfache Autovervollständigung - komplette Satzverläufe vor.

Dabei berücksichtigt sie den Kontext der Nachricht wie das Thema, den Empfänger oder die Uhrzeit. Schreibt man beispielsweise eine Nachricht kurz vor dem Wochenende, schlägt das Programm automatisch "Habe ein tolles Wochenende!" als Verabschiedung vor. Das folgende GIF zeigt ein Beispiel:

Google trainierte die Künstliche Intelligenz mit anonymisierten Daten des eigenen Mail-Services. Genau das wird jetzt zum Problem: Die KI hat in dem Datensatz versteckte geschlechtsspezifische Vorurteile übernommen.

Erstmals entdeckt wurde das laut Google schon im Januar, als ein Forscher intern eine E-Mail verschickte mit Hinweis auf ein anstehendes Treffen mit einer Investorin. Das Programm schlug automatisch vor, dass die Investorin männlich ist ("meeting him" statt "meeting her").

Google hatte zuvor schon auf der Hilfeseite zu Smart Compose darauf hingewiesen, dass KI-generierte Sätze Vorurteile enthalten könnten:

"Die eingesetzten Modelle greifen auf Milliarden typischer Formulierungen und Sätze der Sprachwirklichkeit zu, um zu verstehen, wie Sprache funktioniert. Da bleibt es leider nicht aus, dass sich auch menschliche Vorurteile einschleichen. Sich dessen bewusst zu sein, ist schon ein Anfang, aber noch weiß man einfach nicht genau, wie damit umzugehen ist. Google hat sich zum Ziel gesetzt, Produkte anzubieten, die für alle Menschen nützlich sind. Daher erforscht Google aktiv Strategien, mit denen Vorurteile erkannt und vermieden werden können." (Originalzitat der deutschen Google-Webseite)

GMail-Produktmanager Paul Lambert sagt gegenüber Reuters, dass sein Team nach Wegen gesucht habe, die Vorurteile aus den Daten zu entfernen - ohne Erfolg. Entsprechend setzt der Konzern jetzt auf eine pragmatische Klärung: Smart Compose wird zukünftig keine geschlechtsspezifischen Pronomen mehr vorschlagen.

Auch eine Amazon-KI förderte Geschlechterrollen

Da KI-Technologie schon jetzt und in Zukunft sowieso von so ziemlich jedem Google-Service verwendet wird, ist diese digitale KI-Maulsperre jedoch kaum eine Lösung mit Perspektive. Automatisch stellt sich die Frage, ob und in welchem Umfang weitere Vorurteile in algorithmischen Entscheidungen stecken, die auf den ersten Blick womöglich gar nicht als solche identifiziert werden können.

Anfang Oktober berichtete ebenfalls Reuters, dass Amazon lange Zeit eine KI-gestützte Recruiting-Software nutzte, die für technische Jobs und IT-Anstellungen Männer bevorzugte. Auch Amazon bekam das maschinelle Vorurteil nicht in den Griff und stellte das Projekt Anfang 2017 ein. Eine neue Software soll in Entwicklung sein.