KI vs. KI: Algorithmen sollen das Netz von Fake-Pornos befreien

Wenn das Internet mit authentisch anmutenden KI-Fake-Videos geflutet wird, braucht es eine zweite Künstliche Intelligenz, die diese wieder entfernt. Das könnte zu einem Krieg der mathematischen Präzision führen.

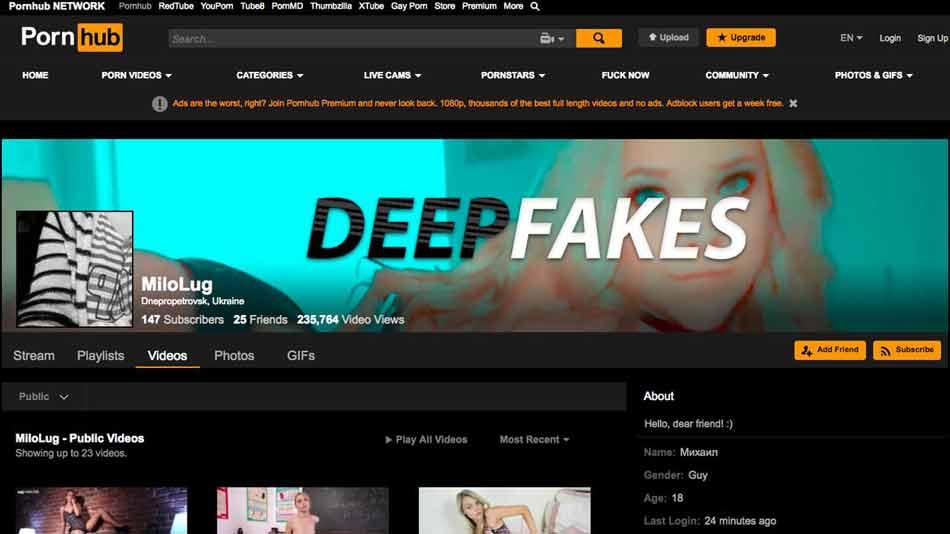

Vergangenen Dezember öffnete die Deepfakes-KI die Büchse der Pandora für Fake-Medien: Jeder technisch versierte Mensch kann mit einer Fake-App - die mittlerweile von zahlreichen Software-Plattformen zum kostenlosen Download angeboten wird - glaubhaft gefälschte Videos erstellen. Die Folgen: Eine berühmte Schauspielerin hat Sex mit Menschen, denen sie noch nie begegnet ist, in einem Körper, der nicht ihr gehört. Angela Merkel trägt bei einer Ansprache plötzlich Trumps Gesichtszüge. Nicolas Cage übernimmt nachträglich die Hauptrolle in einigen Meilensteinen der Filmkunst.

Diese Fake-Videos sind nicht automatisch böse, viele sind schlicht unterhaltsam oder fantasievoll. Die Algorithmen dahinter könnten in der Filmindustrie Produktionsprozesse vereinfachen und aufwendige Spezialeffekte demokratisieren. Filmemacher mit kleineren Budgets hätten mehr Möglichkeiten, sich visuell auszudrücken. Das ist technischer Fortschritt.

Dennoch: In der Masse könnten gefälschte Videos zum Problem werden, wenn sie zum einen auf krasse Art Persönlichkeitsrechte verletzen, zum anderen den Informationsfluss innerhalb der Gesellschaft ins Stocken bringen. Letzteres passiert, wenn niemand mehr zwischen Original und Fälschung unterscheiden kann.

Eine KI soll KI-Fälschungen entlarven

Die GIF-Plattform Gfycat, auf der viele Nutzer Ausschnitte aus Deepfake-Pornos hochladen, geht mit einer Analyse-KI gegen KI-gefälschte Videos vor. Die Software mit dem Spitznamen Maru kann unabhängig von der Benamung oder Verschlagwortung einer Datei die Bildinformationen eines Clips lesen und im Netz nach dem Original oder einer hochauflösenderen Version suchen. So kann sie herausfinden, welches Gesicht in einem Clip zu sehen ist. Maru wird von Gfycat schon seit geraumer Zeit entwickelt, um die Millionen Inhalte auf der eigenen Plattform zu indexieren.

Jetzt setzen die Entwickler Maru auf Deepfake-Pornos an. Das Ergebnis: Sie erkennt in den Fake-Gesichtern zwar eine Ähnlichkeit zur originalen Person, lässt sich aber nicht vollends täuschen, da sie die einzelnen Pixel präziser analysiert, als das menschliche Auge sie sieht.

Die Software entdeckt die kleinen Darstellungsfehler, die unser Gehirn zugunsten der Gesamterfahrung großzügig ausblendet - und kann den Clip so als möglichen Fake markieren.

Was aber, wenn das Gesicht im Video nicht prominent und auch nicht im Netz vorhanden ist? Dann dreht Gfycat das Suchverfahren um: Die Software maskiert das Gesicht und vergleicht stattdessen den Körper, den Hintergrund oder andere Bildelemente mit im Netz verfügbaren Videos.

Taucht ein Video mit gleichen Bildinformationen auf, das Gesicht ist jedoch anders, handelt es sich wahrscheinlich um eine Fälschung. Gfycat möchte mit diesem Verfahren alle möglichen Arten von Fake-Videos entlarven können.

Wer stellt die präziseste Formel auf?

Die Analyse-KI ist jedoch machtlos, wenn sie keine Vergleichsdaten hat: Ein Fake-Video, das komplett offline erstellt wird mit Bildmaterial, das online nicht existiert, kann von keiner Software als Fälschung identifiziert werden.

Hinzu kommt, dass die Entwicklung der Fake-Software nicht stillsteht. Fake-Videos dürften immer glaubhafter und präziser werden, sodass eine gegnerische Analyse-KI Probleme bekommen könnte, Original und Fälschung zu unterscheiden. Die Frage ist letztlich: Welche Künstliche Intelligenz rechnet am präzisesten - und behält die Oberhand?

KI-News ohne Hype – von Menschen kuratiert

Mit dem THE‑DECODER‑Abo liest du werbefrei und wirst Teil unserer Community: Diskutiere im Kommentarsystem, erhalte unseren wöchentlichen KI‑Newsletter, 6× im Jahr den „KI Radar"‑Frontier‑Newsletter mit den neuesten Entwicklungen aus der Spitze der KI‑Forschung, bis zu 25 % Rabatt auf KI Pro‑Events und Zugriff auf das komplette Archiv der letzten zehn Jahre.

Jetzt abonnierenKI-News ohne Hype

Von Menschen kuratiert.

- Mehr als 20 Prozent Launch-Rabatt.

- Lesen ohne Ablenkung – keine Google-Werbebanner.

- Zugang zum Kommentarsystem und Austausch mit der Community.

- Wöchentlicher KI-Newsletter.

- 6× jährlich: „KI Radar“ – Deep-Dives zu den wichtigsten KI-Themen.

- Bis zu 25 % Rabatt auf KI Pro Online-Events.

- Zugang zum kompletten Archiv der letzten zehn Jahre.

- Die neuesten KI‑Infos von The Decoder – klar und auf den Punkt.