Wie fair kann ein Algorithmus sein? So fair wie seine Trainingsdaten. Das zeigt eine interaktive Tour durch das Innere von COMPAS.

COMPAS ist ein "Risikoeinschätzungswerkzeug" der Firma Northpointe, das Richtern in den USA helfen soll, die Rückfallwahrscheinlichkeit von Angeklagten einzuschätzen. COMPAS wird unter anderem in den Bundesstaaten New York, Kalifornien und Wisconsin eingesetzt.

COMPAS wird mit historischen Daten bereits abgeschlossener Verfahren trainiert und soll Korrelationen zwischen Faktoren wie Alter oder Vorstrafen und Rückfallquote herstellen. Die Software soll Richtern helfen, zu entscheiden, ob ein Angeklagter die Zeit bis zu seinem Verfahren im Gefängnis sitzen muss oder in Freiheit verbringen kann. So sollen Verbrechen zwischen Anklage und Verfahren verhindert werden.

Hohes Risiko oder Vorurteile?

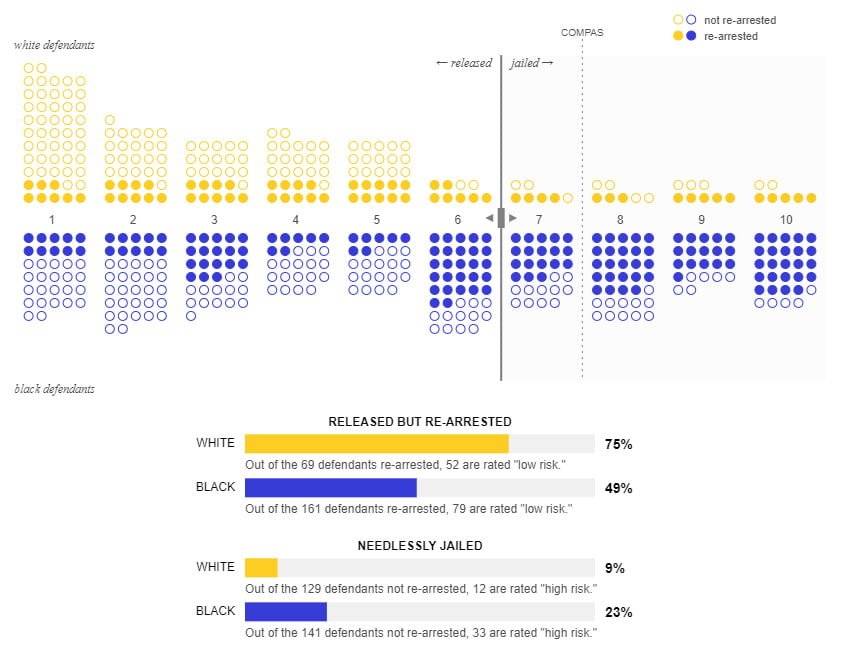

COMPAS gibt für jeden Angeklagten einen Risikowert zwischen eins und zehn aus, der eine Empfehlung an den Richter darstellt. Angeklagte mit hohem Risikowert sollen eine Gefahr für die Gesellschaft sein und daher im Gefängnis auf ihre Verhandlung warten.

Systeme wie COMPAS sollen das Rechtssystem fairer machen und etwaigen Vorurteilen der Richter entgegenwirken. Doch das Märchen vom objektiven Algorithmus hält nicht stand: Obwohl COMPAS Hautfarbe offiziell nicht als Faktor einbezieht, wies ProPublica 2016 dem System Vorurteile gegen dunkelhäutige Menschen nach.

KI-Fairness rückwirkend justieren: Eine unmögliche Aufgabe

Technology Review lässt euch COMPAS interaktiv erkunden und stellt euch eine Frage: Könnt ihr das System fairer einstellen?

Der Online-Test macht klar: Jede Einstellung erzeugt Fehler, immer werden Menschen zu Unrecht festgehalten. Fairness ist unerreichbar, wenn die Trainingsdaten unausgewogen sind.

Das macht deutlich, wie wichtig eine Wahrscheinlichkeitsangabe für einen Fehlalarm bei KI-Vorhersagen ist – die sogenannte Falsch-positiv-Rate.

Die interaktive Tour durch COMPAS macht auch klar, dass Zahlen relativ sind, gerade wenn sie von einer KI generiert werden. Denn wer legt fest, was ein hoher Risikowert ist: Fünf, sieben oder vielleicht erst neun Minuspunkte?

Vorurteile in den Daten verhindern jede Fairness

In einem der fürs COMPAS-Training genutzten Datensätze sind etwa 59 Prozent der dunkelhäutigen Angeklagten vor ihrem Verfahren erneut verhaftet worden – jedoch nur 39 Prozent der hellhäutigen.

Dass sich in diesen Daten rassistische Vorurteile widerspiegeln, ist angesichts der Geschichte der USA wahrscheinlich. So setzt sich die vergangene Ungerechtigkeit fort in die automatisierte Zukunft – unter dem Anschein einer Computer-gesteuerten vermeintlichen Objektivität. Die gleichen Fallstricke lauern auch in den KI-Systemen für Kreditvergabe, Versicherungen oder Bewerbungen.

Wer einen Einblick in die Tücken der automatisierten Gerechtigkeit erhalten will, kann sich hier an der Feinjustierung von COMPAS probieren.

Quelle: Technology Review