Bestärkendes Lernen soll in Zukunft Künstliche Intelligenz und Roboter fit für die reale Welt machen. Doch der Weg ist noch weit: Die Hoffnungsträgermethode funktioniert noch nicht so, wie KI-Forscher sich das erhoffen. Das zeigen neue Benchmarks von Facebook-Forschern.

Wenn ein klares Ziel in einer simulierten Umgebung existiert, ist das bestärkende Lernen für gewöhnlich sehr erfolgreich: Die KI bekommt ein Ziel gesteckt und muss ihren Pfad zu diesem eigenständig finden.

Für jede Aktion, die das Ziel näherbringt, wird sie belohnt. Für einen Fehltritt kann sie bestraft werden. Nach demselben Prinzip trainieren Menschen zum Beispiel Tiere.

Bestärkendes Lernen ist mächtig, weil man so potenziell Probleme lösen kann, für die noch kein Lösungsansatz existiert.

OpenAI-Mitgründer Ilya Sutskever sieht eine große Zukunft für die Methode: Die Lerntechnik könne eine entscheidende Rolle auf dem Weg zu einer starken KI spielen, so Sutskever.

Aktuelle KI-Benchmarks haben nichts mit der echten Welt gemein

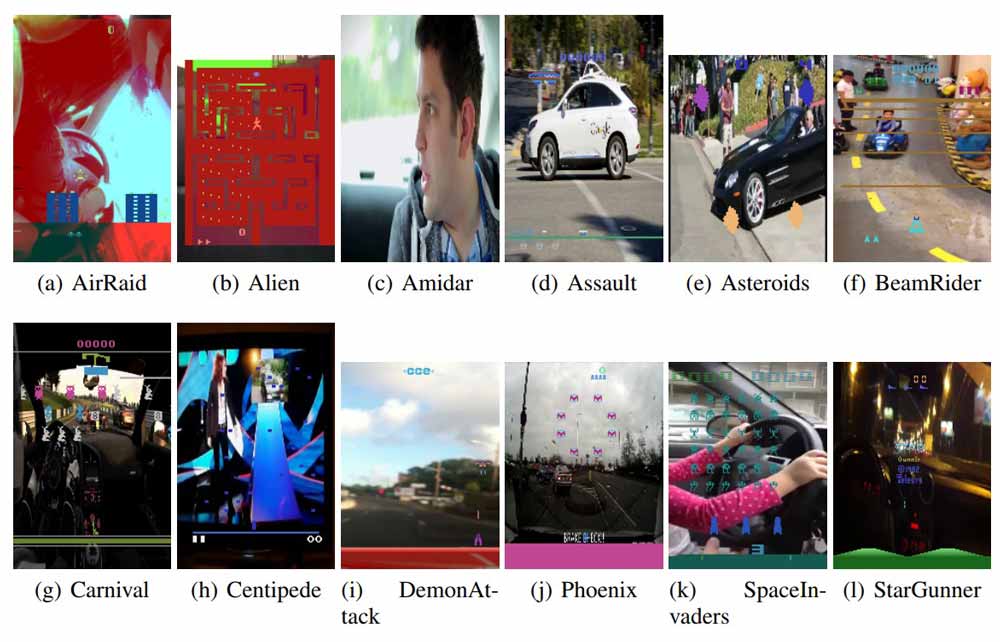

Die Effizienz der Lern-Algorithmen wird mit sogenannten Benchmarks getestet. Das Problem dieser digitalen Lackmustests: Meist handelt es sich um alte Atari-Videospiele und einfache Simulationsumgebungen. Beide Szenarien entsprechen nicht der Komplexität der natürlichen Welt.

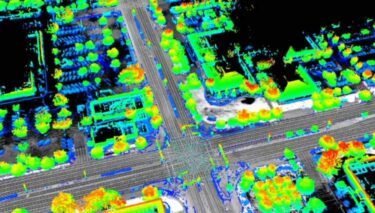

So entstehen spezialisierte Algorithmen, die zwar gut Atari spielen, aber noch nie mit der echten Welt konfrontiert wurden. Bestärkendes Lernen soll jedoch eines Tages Robotern helfen, sich in der Wirklichkeit schnell zurechtzufinden.

Beispielsweise soll der Verstand eines Roboters eine reale Umgebung zunächst in einer virtuellen Realität simuliert erfahren – und zwar in Windeseile und Millionen Trainingsdurchgängen. Dieser vortrainierte Verstand kann dann in einen realen Roboter platziert werden, der seine Aufgabe schon kennt und beherrscht.

So die Theorie. Doch mit wortwörtlich weltfremden Benchmarks tritt die Forschung auf der Stelle. Plakativ ausgedrückt: Die Algorithmen taugen nur für Videospiele.

Neue Benchmarkmethoden offenbaren Schwachstellen

In einer aktuellen Publikation stellen Forscher aus Facebooks KI-Abteilung drei neue Benchmarks vor. Zwei der Benchmarks testen, wie gut ein Algorithmus Objekte auf echten Fotos erkennen kann.

Die Objekterkennung ist seit Jahren ein Zugpferd des Maschinenlernens – allerdings wird hier das überwachte Lernen (Supervised Learning) eingesetzt. Bei diesem werden die Daten vor dem KI-Training aufwendig durch Menschen vorbereitet. Sie geben eine Art Trainingsplan vor, der die Maschine Stück für Stück an das Ziel heranführt.

Wie jede Variante des Maschinenlernens läuft auch der überwachte Algorithmus auf einem neuronalen Netzwerk. In den letzten Jahren haben sich einige Netzwerkarchitekturen als besonders effizient für die Objekterkennung mit überwachtem Lernen herausgestellt.

Die Forscher testeten diese Netzwerke nun für die Objekterkennung mit Algorithmen für bestärkendes Lernen. Das Ergebnis: Sie waren den überwachten Lernmethoden bei denselben Datensätzen komplett unterlegen.

Für die Forscher ein klares Zeichen, dass mit bestärkendem Lernen trainierte Algorithmen verbessert werden müssen, wenn sie in der realen Welt einmal wichtige Aufgaben übernehmen sollen - zum Beispiel ein autonomes Flugzeug steuern.

Atari-Spiel mit Störungsbildern

Der dritte Benchmark fügt im Hintergrund eines Atari-Videospiels reale Videos ein. So wird getestet, wie der Algorithmus für bestärkendes Lernen mit visuellen Störungen umgeht.

„Im normalen Atari-Spiel merkt sich die Künstliche Intelligenz den Hintergrund“, so Mitautorin Amy Zhang. „Jetzt ist jeder Hintergrund anders, also muss sie tatsächlich lernen, die Szene visuell komplett zu erfassen, um zu verstehen, was los ist.“

Ein mit bestärkendem Lernen trainierter Algorithmus kann zum Beispiel Space Invaders am statischen Hintergrund erkennen. Mit dem sich ständig ändernden Videohintergrund fällt diese Möglichkeit weg. Er kann sich nur noch an der vordergründigen Szene orientieren – diese ist zwar ebenfalls in Bewegung, weist aber auch Muster auf.

Aktuelle Algorithmen für bestärkendes Lernen kamen mit dieser Veränderung nicht klar. Ihre Leistung fiel stark ab – der statische Hintergrund war offensichtlich ein zu wichtiger Indikator für sie.

Da in freier Wildbahn solche Veränderungen ständig auftreten, würde ein entsprechend trainierter Roboter sofort versagen. Man stelle sich eine KI vor, die versucht, Stoppschilder anhand des Hintergrunds zu erkennen.

Es sei klar geworden, dass man noch einige Arbeit vor sich habe, so Zhang. Es brauche robustere Algorithmen für bestärkendes Lernen, die sich besser generalisieren ließen.

Titelbild: OpenAI