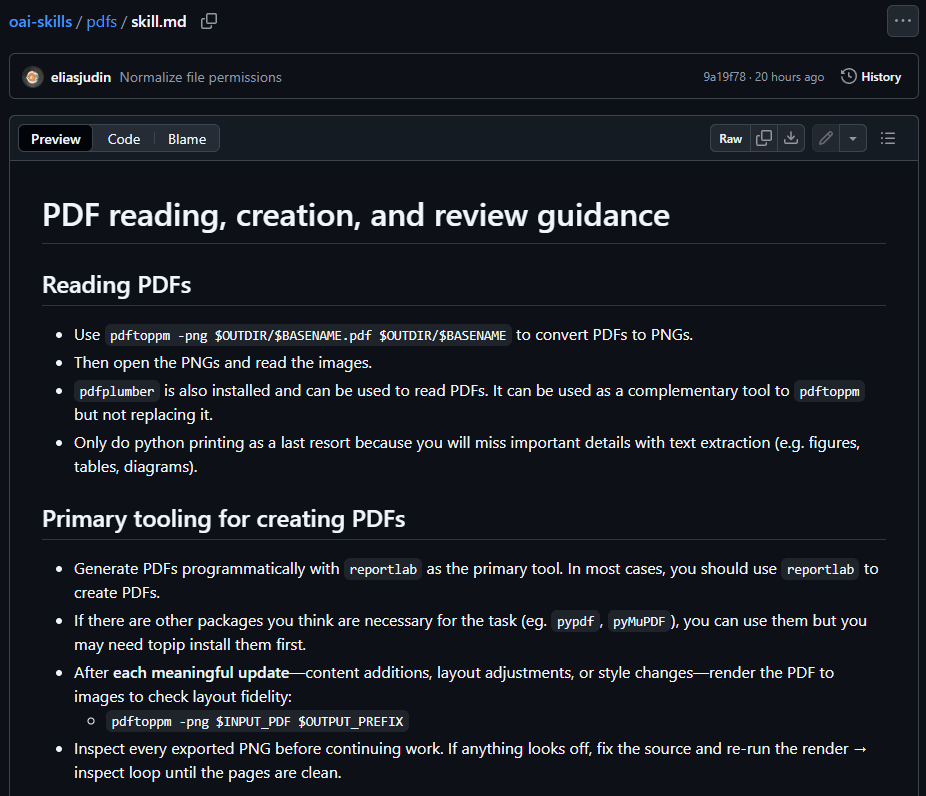

Google integriert Gemini in Google Translate für bessere Textübersetzungen und startet eine Beta für Echtzeit-Sprachübersetzung über Kopfhörer. Gemini versteht nun Redewendungen, lokale Ausdrücke und Slang besser und überträgt sie natürlicher, statt sie wörtlich zu übersetzen. Die verbesserte Textübersetzung startet in den USA und Indien für Englisch und fast 20 Sprachen, darunter Spanisch, Hindi, Chinesisch, Japanisch und Deutsch. Die App ist für Android und iOS sowie im Web verfügbar.

Die Live-Übersetzung nutzt Geminis Sprache-zu-Sprache-Fähigkeiten und behält Tonfall, Betonung und Rhythmus des Sprechers bei. Die Beta ist zunächst auf Android in den USA, Mexiko und Indien verfügbar und unterstützt über 70 Sprachen. iOS und weitere Länder folgen 2026.

Zusätzlich erweitert Google die Sprachlern-Tools um fast 20 neue Länder, darunter Deutschland, Indien, Schweden und Taiwan.