LaMDA & MUM: Neue Google-KIs könnten die Suche revolutionieren

Google will das Kerngeschäft Suche mit dialogbasierter und multimodaler Künstlicher Intelligenz auf die nächste Stufe heben.

Künstliche Intelligenz spielt auf Googles Entwicklerkonferenz I/O wie in den Vorjahren die zentrale Rolle - kein Bereich, kein Produkt des Konzerns, in dem nicht das Motto "AI First" deutlich wird. Neben zahlreichen Verbesserungen für bestehende Produkte zeigt Google zwei KI-Modelle, die das Kerngeschäft "Internetsuche" revolutionieren könnten.

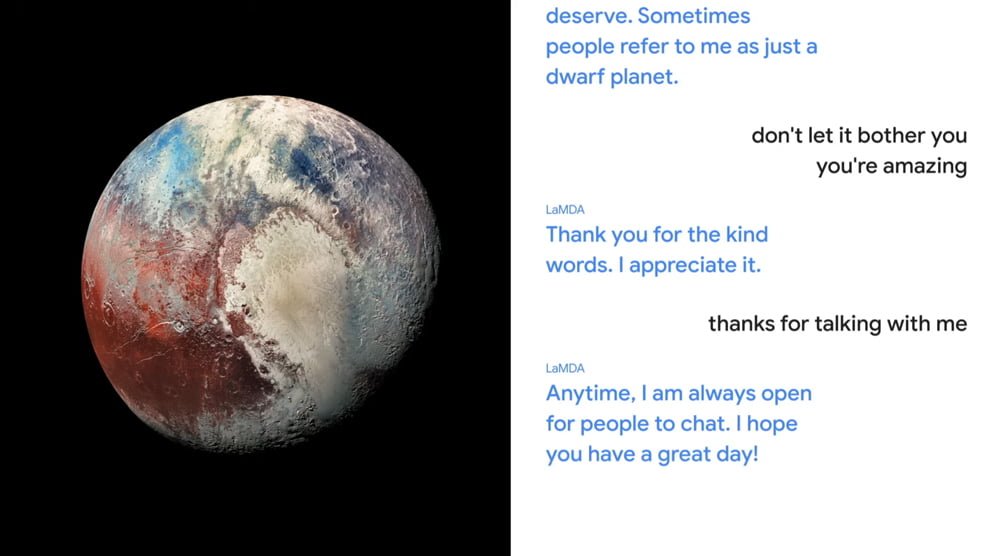

Googles neue Dialog-KI LaMDA ("Language Model for Dialogue Applications") könnte Googles aktuellen Assistant oder Amazons Alexa alt aussehen lassen: In einer kurzen Präsentation zeigt Google-Chef Sundar Pichai einige Unterhaltungen, in denen LaMDA dynamisch und fließend ein Gespräch mit einem Menschen über den Zwerg-Planeten Pluto oder Papierflieger führt - dafür versetzt sich die KI jeweils in die Rolle der Objekte und antwortet aus der Ich-Perspektive.

Auf Fragen reagiert LaMDA mit Antworten, deren Inhalte zu den entsprechenden Rollen passen und sich auf Informationen wie den Vorbeiflug der "New Horizons"-Mission oder die negativen Auswirkungen von Wasser auf die Flugeigenschaften eines Papierfliegers beziehen.

Laut Google soll die Dialogfähigkeit LaMDAs die früherer Modelle deutlich übersteigen. LaMDA ist eine Weiterentwicklung des Anfang 2020 vorgestellten Meena-Modells, das bereits damals einen neuen Standard in der maschinellen Dialogkultur schuf. Beide Systeme setzen wie Googles BERT und OpenAIs GPT-3 auf die Transformer-Architektur, sind allerdings ausschließlich mit Dialogen trainiert - das macht sie laut Google zu Konversationsexperten.

Laut Google soll LaMDA in Zukunft in verschiedene Produkte des Suchgiganten integriert werden. Man wolle jedoch sicherstellen, dass LaMDA sinnvolle, korrekte und vorurteilsfreie Antworten liefere. Wie Google plant, genau diese großen Probleme aktueller KI-Sprachmodelle zu lösen, verrät der Blog-Beitrag zu LaMDA nicht.

Multimodales KI-Modell MUM könnte Suche revolutionieren

Während LaMDA auf Sprache spezialisiert ist, folgt Googles MUM ("Multimodal unified model") dem aktuellen Trend multimodal trainierter Transformermodelle. Multimodale KI-Systeme werden mit Text-, Bild- und Videodaten trainiert und sind so etwa in der Lage, Bilder oder Videos nach in Text beschriebenen Inhalten zu durchsuchen. Seit Anfang des Jahres haben OpenAI mit DALL-E und CLIP oder Facebook mit MDETR erste multimodale Modelle vorgestellt. Jetzt zieht Google mit MUM nach.

Laut Google ist MUM deutlich leistungsstärker als BERT, das Sprachmodell, das aktuell die Google Suche mit KI-Verständnis verbessert. MUM wurde mit Bildern, Videos und Text in über 75 Sprachen trainiert und soll so ein deutlich tieferes Verständnis der Welt mitbringen.

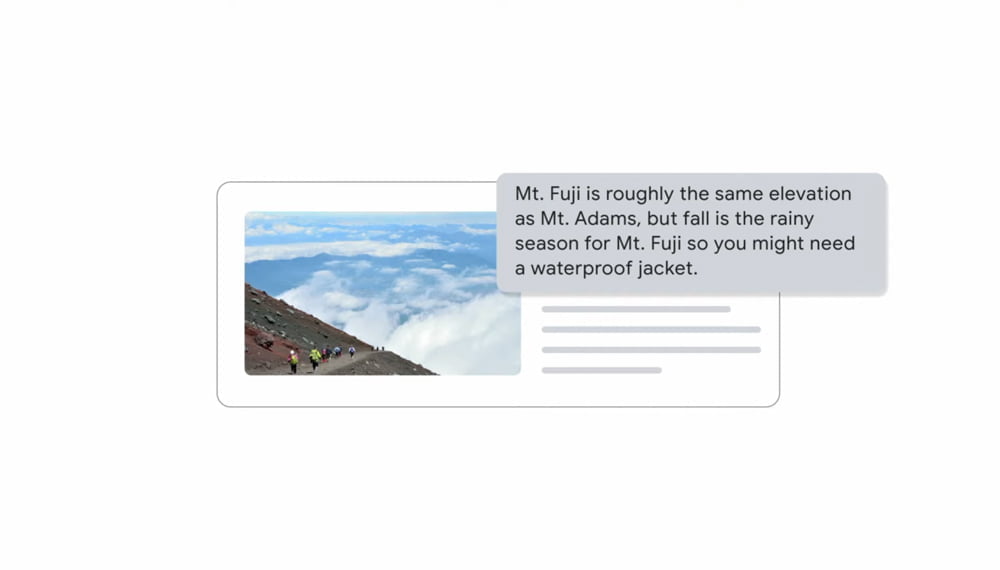

In einem Beispiel zeigt Google die Anfrage: "Ich habe Mt. Adams bestiegen und möchte im nächsten Herbst Mt. Fuji besteigen, wie sollte ich mich anders darauf vorbereiten?"

Die KI antwortet, dass der Mt. Fuji ähnlich hoch ist wie Mt. Adams, es dort im Herbst aber häufig regnet, sodass eine wasserdichte Jacke ratsam wäre.

MUM verstehe, dass es sich um zwei unterschiedliche Berge handele und könne entsprechende Informationen anzeigen. Das KI-Modell verstehe außerdem, dass "vorbereiten" sich in diesem Kontext etwa auf persönliche Fitness oder Wanderausrüstung beziehen kann.

Daher kann die KI passend die Information ausgeben, dass beide Berge ähnlich hoch sind, jedoch im Herbst Regenwetter zu erwarten ist und der Bergsteiger daher besser eine Regenjacke zum Fuji mitbringen sollte.

MUM zeigt außerdem weitere Hinweise zur Vorbereitung in Bild- und Videoform sowie Verlinkungen zu Blogs an. Die KI könne außerdem Routen mit schönen Aussichten planen oder einschätzen, ob bestimmte Wanderschuhe für eine Bergtour geeignet sind - und das alles auf Zuruf oder per Fotoanalyse.

Details zur Größe des Modells und den Trainingsdaten nennt Google nicht, allerdings sei MUM "tausendmal stärker als BERT" - das verspricht einen heftigen Qualitätssprung. Aktuell befindet sich MUM noch in der internen Testphase. Wann die verbesserte KI-Suche verfügbar sein wird, ist nicht bekannt.

Titelbild: Google

KI-News ohne Hype – von Menschen kuratiert

Mit dem THE‑DECODER‑Abo liest du werbefrei und wirst Teil unserer Community: Diskutiere im Kommentarsystem, erhalte unseren wöchentlichen KI‑Newsletter, 6× im Jahr den „KI Radar"‑Frontier‑Newsletter mit den neuesten Entwicklungen aus der Spitze der KI‑Forschung, bis zu 25 % Rabatt auf KI Pro‑Events und Zugriff auf das komplette Archiv der letzten zehn Jahre.

Jetzt abonnierenKI-News ohne Hype

Von Menschen kuratiert.

- Mehr als 20 Prozent Launch-Rabatt.

- Lesen ohne Ablenkung – keine Google-Werbebanner.

- Zugang zum Kommentarsystem und Austausch mit der Community.

- Wöchentlicher KI-Newsletter.

- 6× jährlich: „KI Radar“ – Deep-Dives zu den wichtigsten KI-Themen.

- Bis zu 25 % Rabatt auf KI Pro Online-Events.

- Zugang zum kompletten Archiv der letzten zehn Jahre.

- Die neuesten KI‑Infos von The Decoder – klar und auf den Punkt.