Luma AI verwandelt Videos in 3D-Modelle für fast kein Geld

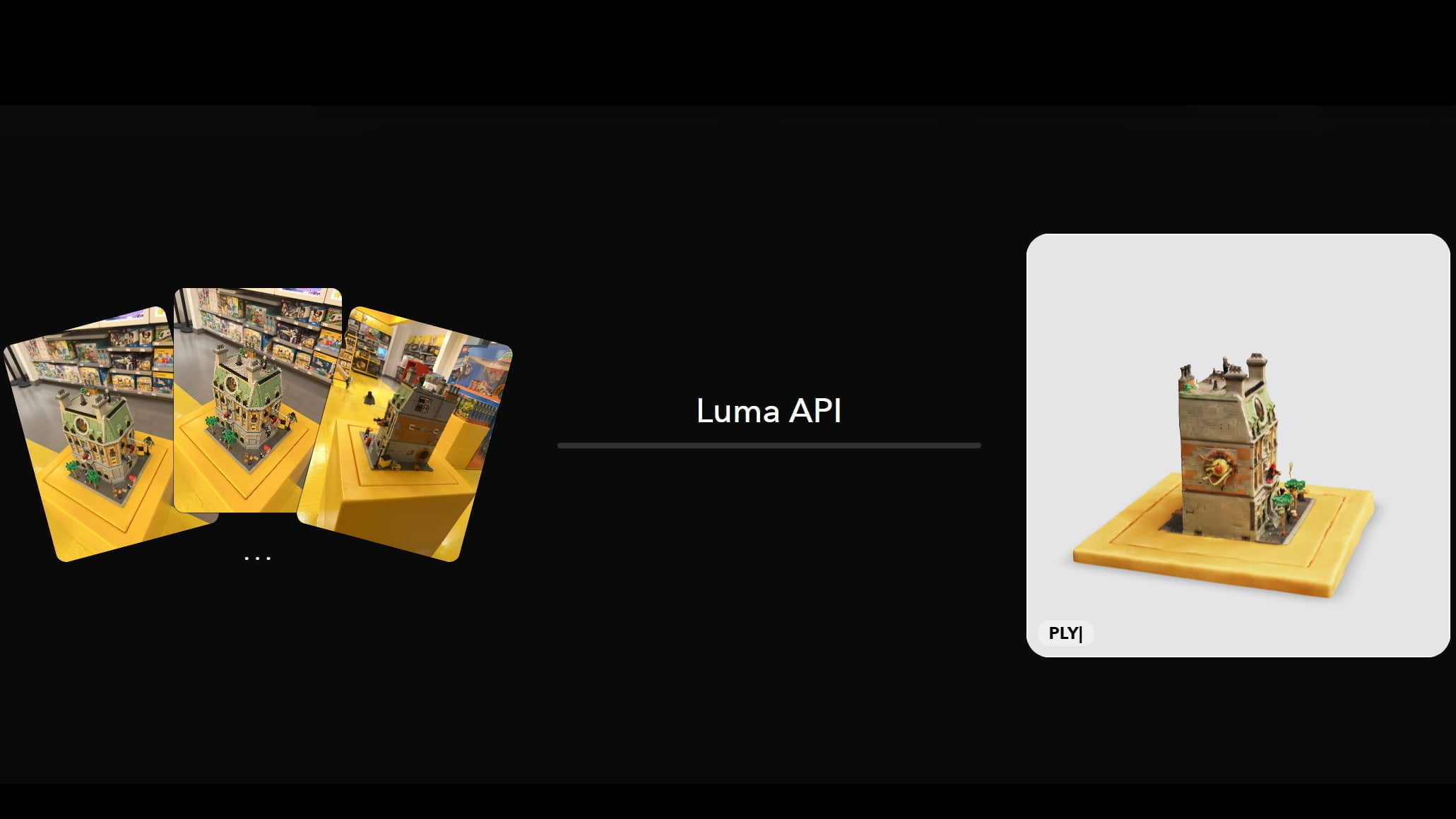

3D-Szenen demokratisieren - das ist das Ziel von Luma AI aus Kalifornien. Nach einem Text-zu-3D-Tool hat das Start-up jetzt eine API für Umwandlung von Bildern und Videos in 3D-Modelle eingeführt.

Derzeit würde es zwischen 60 und 1.500 US-Dollar und zwei bis zehn Wochen brauchen, um ein 3D-Modell zu erstellen, sagt das KI-Start-up Luma AI. Es will diesen Prozess deutlich verkürzen und vergünstigen: auf 30 Minuten und gerade einmal einen US-Dollar pro Modell.

Dafür hat das Unternehmen, das vor kurzem 20 Millionen US-Dollar in einer Series-A-Finanzierungsrunde eingesammelt hat, eine Video-zu-3D-API vorgestellt. "Unser Ziel ist es, 3D zu demokratisieren. Fotorealistisches 3D in Hollywood-Qualität für jedermann", so das laut 14-köpfige Start-up mit Sitz in Palo Alto, Kalifornien.

Wir leben in einer dreidimensionalen Welt. Unsere Wahrnehmung und unsere Erinnerungen bestehen aus dreidimensionalen Wesen. Dennoch gibt es keine Möglichkeit, diese Momente so einzufangen und wieder zu erleben, als ob man dabei wäre. Alles, was wir vorweisen können, sind diese 2D-Scheiben, die wir Fotos nennen. Es ist an der Zeit, dass sich das ändert.

Luma AI

Um ein 3D-Modell aus einer Reihe an Bildern oder Video zu erstellen, können Entwickler:innen die neue API nutzen, Endanwender:innen jedoch auch auf eine Weboberfläche unter zurückgreifen. Um das bestmögliche Ergebnis zu erzielen, gibt Luma einige Richtlinien vor.

Luma gibt Tipps für die perfekte 3D-Szene

So sollte die Szene oder das Objekt aufgenommen werden, indem man im Kreis darum herumgeht, dazu so langsam wie möglich, um Unschärfe zu vermeiden und mit deaktiviertem HDR-Modus.

Die Aufnahme sollte am besten aus drei verschiedenen Höhen erfolgen: auf Brusthöhe, mit Blick nach vorne, über dem Kopf, mit Blick leicht nach unten in die Mitte der Szene und schließlich auf Kniehöhe mit Blick leicht nach oben. Wahlweise kann die Szene auch in Weitwinkel- oder Fisheye-Optik (Ultra-Weitwinkel) aufgenommen werden, dies muss aber beim Upload entsprechend angegeben werden.

Die Videodatei darf maximal 5 GB groß sein. Gleiches gilt für ein Zip-Archiv mit Bildern. Weitere Hinweise gibt Luma AI in der Dokumentation. Aus dem Video oder den Bildern erstellt Luma ein NeRF, eine neuronal gelernte 3D-Szene.

In meinem kurzen Test erwies sich die Video-zu-3D-Funktion von Luma als brauchbar, wenngleich das zentrale Objekt etwas niedrig aufgelöst ist - allerdings ist der Blumenstrauß im transparenten Glas auch ein relativ aufwendiges Objekt. Mit weiteren Aufnahmen ließe sich die Qualität zudem wohl noch etwas verbessern.

Nach der Verarbeitung auf dem Server lässt sich die 3D-Szene zudem als Objekt (GLTF, USDZ, OBJ) oder Mesh-Szene (PLY) herunterladen, per Link teilen oder als iframe einbetten.

Wie das mit einem simplen Objekt funktionieren kann, zeigt dieses Beispiel eines Stuhls.

Zehn Credits zum Start geschenkt

Die Nutzung des neuen 3D-Tools setzt eine kostenlose Registrierung voraus, zum Ausprobieren gibt es zehn Credits - also zehn 3D-Szenen - geschenkt. Für die nähere Zukunft kündigt Luma AI kontinuierliche Verbesserungen bei Qualität und Verarbeitungszeit an.

Luma AI hatte im Dezember 2022 bereits eine Text-zu-3D-Schnittstelle namens Imagine 3D mit ähnlich beeindruckenden Ergebnissen eingeführt. Dieses Tool ist jedoch vorerst nur über eine Warteliste zugänglich.

KI-News ohne Hype – von Menschen kuratiert

Mit dem THE‑DECODER‑Abo liest du werbefrei und wirst Teil unserer Community: Diskutiere im Kommentarsystem, erhalte unseren wöchentlichen KI‑Newsletter, 6× im Jahr den „KI Radar"‑Frontier‑Newsletter mit den neuesten Entwicklungen aus der Spitze der KI‑Forschung, bis zu 25 % Rabatt auf KI Pro‑Events und Zugriff auf das komplette Archiv der letzten zehn Jahre.

Jetzt abonnierenKI-News ohne Hype

Von Menschen kuratiert.

- Mehr als 20 Prozent Launch-Rabatt.

- Lesen ohne Ablenkung – keine Google-Werbebanner.

- Zugang zum Kommentarsystem und Austausch mit der Community.

- Wöchentlicher KI-Newsletter.

- 6× jährlich: „KI Radar“ – Deep-Dives zu den wichtigsten KI-Themen.

- Bis zu 25 % Rabatt auf KI Pro Online-Events.

- Zugang zum kompletten Archiv der letzten zehn Jahre.

- Die neuesten KI‑Infos von The Decoder – klar und auf den Punkt.