Eine Studie unterstreicht, was sich Beobachter von Deepfake-Technik wohl schon dachten: KI-generierte Fotos sind fast nicht von realen Fotos unterscheidbar.

Als Ian Goodfellow und seine Kollegen 2014 erstmals mit der GAN-KI-Technik erstellte Fake-Aufnamen von Menschen zeigten, waren das noch unscharfe Schwarzweiß-Aufnahmen (Geschichte der Deepfakes).

Sie deuteten schon damals das Potenzial generativer KI-Technik an, das sich - zumindest bei Porträtfotos - spätestens im letzten Jahr weitgehend erfüllt haben dürfte. Die generativen Systeme sind mittlerweile so optimiert, dass sie kaum mehr KI-typische Bildfehler erzeugen, anhand derer die Fake-Fotos in der Vergangenheit gut identifizierbar waren. Eine Studie unterstützt diese Beobachtung.

Mensch vs. Deepfake: Kaum besser als der Zufall

Professor Hany Farid von der University of California, Berkeley, und Dr. Sophie Nightingale von der Lancaster University überprüften jetzt in einem Experiment, ob Menschen noch in der Lage sind, reale Fotos von Menschen und KI-generierte Deepfakes zu unterscheiden.

Dafür verwendeten sie mit Nvidias StyleGAN2 eine aktuelle, aber nicht einmal die aktuellste Deepfake-Technologie: StyleGAN3 ist noch mächtiger.

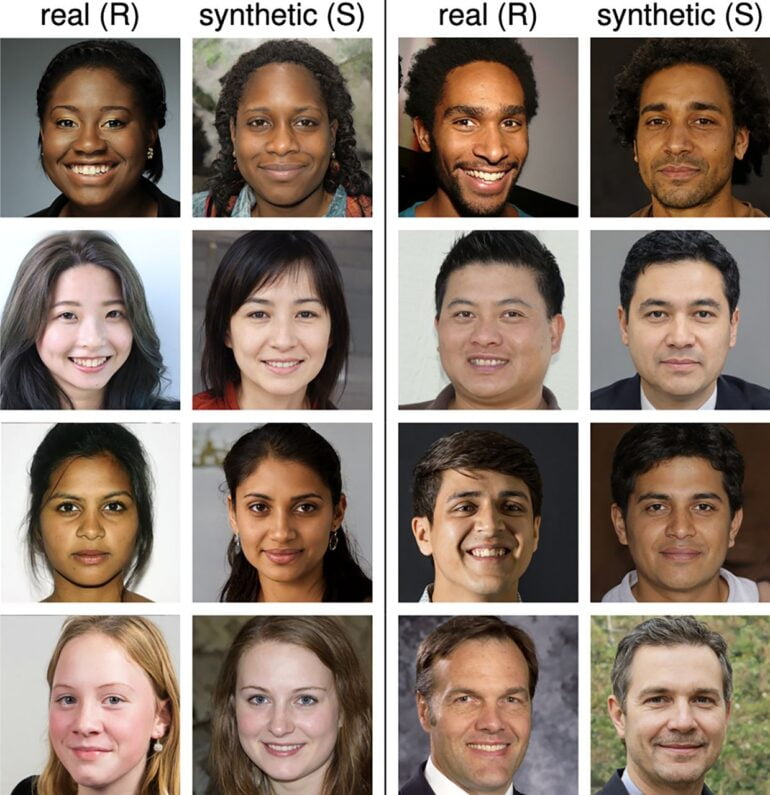

Die Forschenden wählten 400 durch Künstliche Intelligenz generierte Gesichter aus. Dabei achteten sie auf Vielfalt bezüglich Herkunft, Geschlecht und Alter. Außerdem wählten sie bevorzugt Bilder mit einem weitgehend einheitlichen Hintergrund, um Fremdeinflüsse weiter zu reduzieren. Für jedes KI-generierte Gesicht wählten sie dann ein passendes reales Gegenstück aus der Datenbank, mit der StyleGAN2 trainiert wurde.

Mit dieser Fotoauswahl von insgesamt 800 Bildern starteten sie insgesamt drei Experimente. Im ersten Experiment kategorisierten 315 Teilnehmende 128 reale oder generierte Fotos als echt oder Deepfake. Ihre Genauigkeit lag bei etwa 48 Prozent, was Zufallsniveau entspricht.

In einem zweiten Experiment wurde den Teilnehmenden zuvor erklärt, anhand welcher Merkmale sie KI-gefälschte Bilder identifizieren können. 219 Teilnehmende untersuchten erneut 128 Bilder, doch trotz des Vorabtrainings erreichten sie nur eine Genauigkeit von 59 Prozent bei der Deepfake-Erkennung. Das ist kaum besser als Zufall.

Deepfake-Gesichter sind vertrauenswürdiger

Die Forschenden hatten noch eine weitere Forschungsfrage, die sie in einem dritten Experiment prüften: Menschen würden anhand von Gesichtern innerhalb von Millisekunden implizite Rückschlüsse auf individuelle Eigenschaften wie die Vertrauenswürdigkeit von Personen ziehen. Die Forschenden wollten wissen, ob Menschen diese Rückschlüsse auch bei KI-generierten Menschen ziehen.

Im dritten Experiment wurden die Teilnehmenden daher gebeten, die Vertrauenswürdigkeit von insgesamt 128 realen und synthetischen Gesichtern zu bewerten. Die Teilnehmenden stuften die Deepfake-Porträtfotos um 7,7 Prozent vertrauenswürdiger ein als echte Gesichter.

Die Forschenden gehen nicht davon aus, dass diese positivere Zuschreibung mit der Auswahl der Fotos selbst zu tun hat. Zwar würden etwa lächelnde Personen oder Frauen grundsätzlich als vertrauenswürdiger eingestuft, doch die verschiedenen Gesichtsausdrücke und Gesichter seien über die realen und synthetischen Fotos gleichmäßig verteilt gewesen.

Der eigentliche Grund für das höhere Vertrauen in Deepfake-Gesichter könnte laut der Forschenden ihre Durchschnittlichkeit sein. Die KI generiert die Fake-Gesichter, indem sie einzelne Bruchstücke der beim KI-Training gelernten Gesichter sehr vieler Menschen zu einem neuen synthetischen Gesicht zusammensetzt.

Die Forschenden fordern die Grafik- und Bildgebungsgemeinschaft dazu auf, Richtlinien für die Erstellung und Verbreitung von Deepfakes zu erstellen, an denen sich die Wissenschaft, Verlage und Medienunternehmen orientieren können.