Meta-KI rekonstruiert getippte Sätze allein aus Gehirnaufnahmen mit 80 Prozent Genauigkeit

Metas KI-Forschungsabteilung zeigt die Rekonstruktion getippter Sätze allein aus Gehirnaufnahmen und teilt neue Erkenntnisse, wie das Gehirn Gedanken in Sprache übersetzt.

Gemeinsam mit dem Basque Center on Cognition, Brain and Language in Spanien hat Metas Fundamental AI Research Lab (FAIR) zwei Studien veröffentlicht, die zeigen, wie KI das Verständnis der menschlichen Intelligenz voranbringen kann.

Sie bauen auf früheren Arbeiten aus 2022 und 2023 zur Entschlüsselung von wahrgenommenen Bildern und Sprache aus Gehirnsignalen auf, die ebenfalls der französische Neurowissenschaftler Jean-Rémi King angeführt hatte.

KI rekonstruiert 80 Prozent der getippten Sätze

In der ersten Studie zeichneten die Forschenden nun mittels MEG (Magnetoenzephalographie) und EEG (Elektroenzephalographie) die Gehirnaktivität von 35 Probanden auf, während diese Sätze tippten. Ein KI-Modell lernte dann, allein aus den Gehirnsignalen die getippten Sätze wiederzugeben.

Video: Meta

Damit gelang es, getippte Sätze aus nicht-invasiven Gehirnaufnahmen zu rekonstruieren, mit einer Genauigkeit von bis zu 80 Prozent auf Zeichenebene. Oft konnte so der vollständige Satz allein aus den Gehirnsignalen wiederhergestellt werden.

Allerdings sei die Dekodierungsleistung noch nicht perfekt. Zudem erfordere MEG, dass die Probanden sich in einem abgeschirmten Raum befinden und stillhalten. Künftige Studien müssen auch mit Patienten mit Hirnverletzungen durchgeführt werden, um klinische Anwendbarkeit zu zeigen.

Video: Meta

Meta verfolgt Gedanken bis zum fertigen Satz

Die zweite Studie untersuchte, wie das Gehirn Gedanken in komplexe Bewegungsabfolgen übersetzt. Bewegungen von Mund und Zunge erschweren dabei normalerweise die Messung der Gehirnsignale.

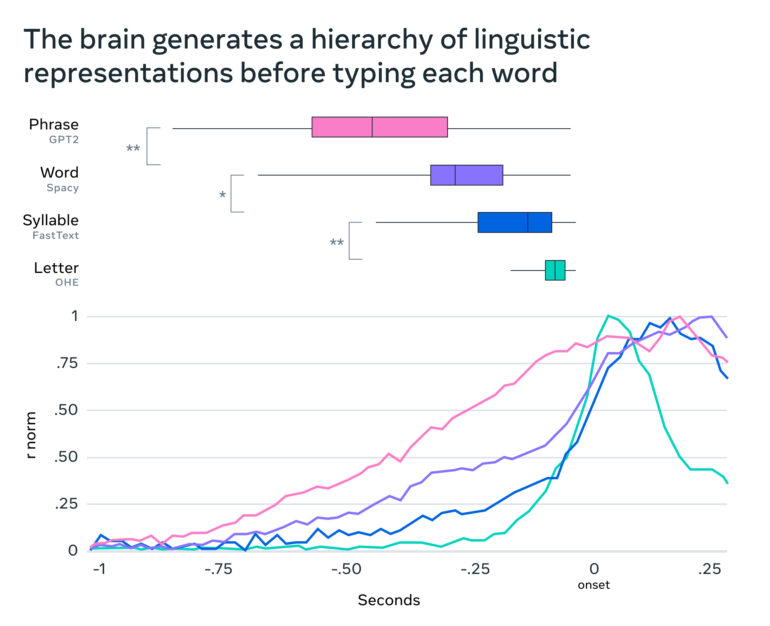

Mithilfe von KI analysierten die Forscher:innen jetzt MEG-Aufnahmen, während Probanden wieder Sätze tippten. Mit 1.000 Aufnahmen pro Sekunde konnten sie möglichst genau bestimmen, wann Gedanken in Wörter, Silben und Buchstaben umgewandelt werden.

Meta fand heraus, dass das Gehirn dabei mit abstrakten Repräsentationen der Satzbedeutung beginnt und diese schrittweise in konkrete Fingerbewegungen übersetzt. Dabei werden aufeinanderfolgende Wörter und Aktionen kohärent und gleichzeitig repräsentiert, mithilfe eines speziellen "dynamischen neuronalen Codes".

Entschlüsselung des neuronalen Codes bleibt KI-Herausforderung

Millionen von Menschen leiden jährlich unter kommunikationshemmenden Hirnläsionen. Neuroprothesen, die Signale an KI-Dekoder senden, könnten hier Abhilfe schaffen. Bisher waren nicht-invasive Ansätze jedoch durch verrauschte Signale limitiert.

Die Entschlüsselung dieses neuronalen Codes der Sprache bleibe eine Kernherausforderung der KI und Neurowissenschaften, so Meta. Das Verständnis der neuronalen Architektur und Berechnungsprinzipien der menschlichen Sprachfähigkeit ist ein wichtiger Schritt auf dem Weg zu fortschrittlicher KI.

Metas Forschung kommt auch schon im Gesundheitswesen zum Einsatz: So nutzt das französische Unternehmen BrightHeart Metas Open-Source-Modell DINOv2, um angeborene Herzfehler in Ultraschallbildern zu erkennen. Auch das US-Unternehmen Virgo nutzt DINOv2, um Endoskopie-Videos zu analysieren.

KI-News ohne Hype – von Menschen kuratiert

Mit dem THE‑DECODER‑Abo liest du werbefrei und wirst Teil unserer Community: Diskutiere im Kommentarsystem, erhalte unseren wöchentlichen KI‑Newsletter, 6× im Jahr den „KI Radar"‑Frontier‑Newsletter mit den neuesten Entwicklungen aus der Spitze der KI‑Forschung, bis zu 25 % Rabatt auf KI Pro‑Events und Zugriff auf das komplette Archiv der letzten zehn Jahre.

Jetzt abonnierenKI-News ohne Hype

Von Menschen kuratiert.

- Mehr als 20 Prozent Launch-Rabatt.

- Lesen ohne Ablenkung – keine Google-Werbebanner.

- Zugang zum Kommentarsystem und Austausch mit der Community.

- Wöchentlicher KI-Newsletter.

- 6× jährlich: „KI Radar“ – Deep-Dives zu den wichtigsten KI-Themen.

- Bis zu 25 % Rabatt auf KI Pro Online-Events.

- Zugang zum kompletten Archiv der letzten zehn Jahre.

- Die neuesten KI‑Infos von The Decoder – klar und auf den Punkt.