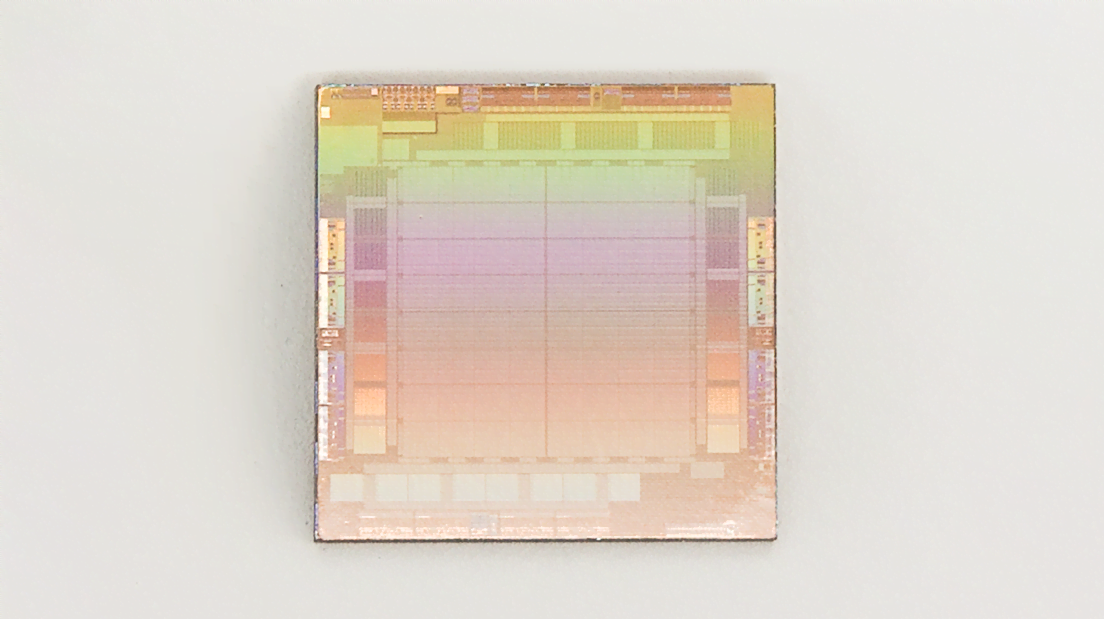

Ein neuer KI-Chip von Meta soll die Ausführung neuronaler Netze beschleunigen, ein weiter ausgebauter Supercomputer die eigene KI-Forschung.

"Meta Training and Inference Accelerator" (MTIA) steht für eine neue Chipfamilie, die insbesondere die Rechenleistung neuronaler Netze, die sogenannte Inferenz, beschleunigen und verbilligen soll. Der Chip soll ab 2025 im Einsatz sein. Derzeit setzt Meta in den eigenen Rechenzentren noch auf Nvidia-Grafikkarten.

Wie Googles Tensor-Processing-Chips (TPUs) ist auch der MTIA ein ASIC-Chip (Application-Specific Integrated Circuit), der für Matrix-Multiplikationen und Aktivierungsfunktionen optimiert ist, wie sie in neuronalen Netzen vorkommen. Laut Meta kann der Chip KI-Modelle mit geringer und mittlerer Komplexität besser verarbeiten als eine GPU.

Video: Meta AI

Auch Amazon bietet mit Trainium und Inferentia Zugang zu KI-Chips für Training und Ausführung in der Cloud. Microsoft soll mit AMD an KI-Chips arbeiten.

"Research SuperCluster": Metas KI-Supercomputer RSC erreicht nächste Ausbaustufe

Im Januar 2022 hat Meta den KI-Supercomputer RSC vorgestellt. Er soll im Vollausbau der schnellste Supercomputer sein, der auf KI-Berechnungen spezialisiert ist. Bereits seit 2020 baut der Konzern an dem Riesenrechner.

Laut Meta hat RSC nun die zweite Ausbaustufe erreicht und verfügt über 2.000 Nvidia DGX A100 und 16.000 Nvidia A100 GPUs. Die Spitzenleistung liegt laut Meta bei fünf Exaflops. Der RSC soll für die KI-Forschung in verschiedenen Bereichen, einschließlich der generativen KI, genutzt werden.

Eine Besonderheit des RSC-Supercomputers ist, dass er Daten aus den Produktionssystemen von Meta für das KI-Training nutzen kann. Bislang setzte Meta primär auf Open Source und öffentlich verfügbare Datensätze, obwohl der Konzern auf einem gigantischen Datenschatz sitzt.

Video: Meta

Der RSC hat bereits Geschichte geschrieben: Meta trainierte auf ihm das Sprachmodell LLaMA, das - teils geleakt, teils veröffentlicht - zum Motor der Open-Source-Bewegung für Sprachmodelle wurde. Das Training des größten LLaMA-Modells dauerte laut Meta 21 Tage auf 2.048 Nvidia A100 GPUs.