Meta hat Details zur nächsten Generation des hauseigenen KI-Chips MTIA vorgestellt. Der neue Chip soll bis zu dreimal leistungsfähiger sein als sein Vorgänger und wird bereits in Metas Werbe- und Rankingverfahren eingesetzt.

Meta gibt neue Details zur nächsten Generation des Meta Training and Inference Accelerator (MTIA) bekannt, der Chip-Familie, die Meta speziell für die Inferenz der eigenen KI-Workloads entwickelt.

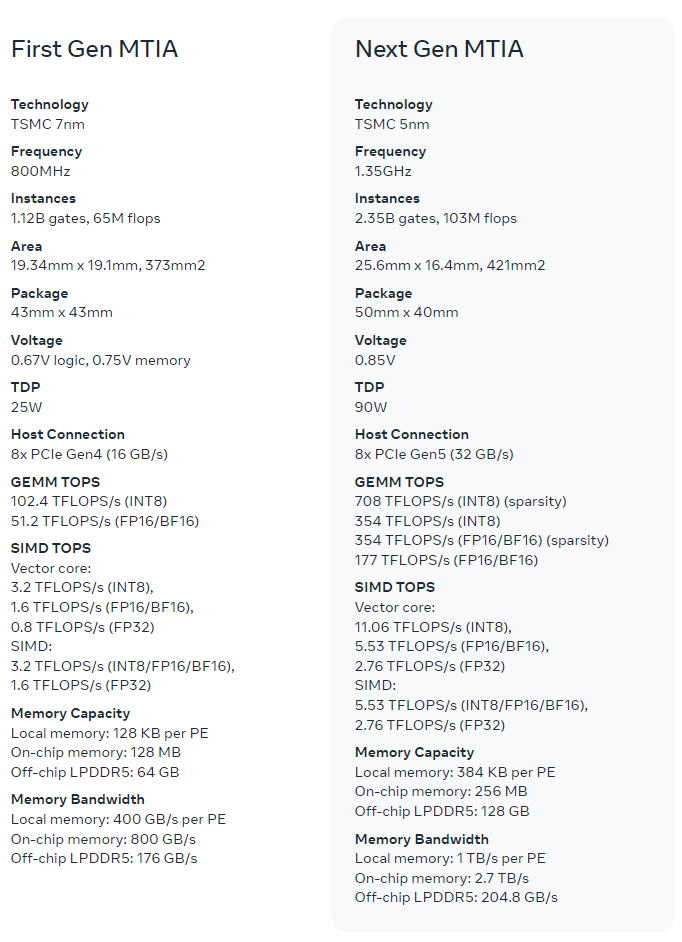

Laut Meta verdoppelt die neue Version von MTIA die Rechen- und Speicherbandbreite der Vorgängerversion und behält gleichzeitig die enge Verbindung zu den Meta-Workloads bei. Die Architektur konzentriert sich auf die richtige Balance zwischen Rechenleistung, Bandbreite und Speicherkapazität für die Werbe-Ranking- und Empfehlungsmodelle von Meta.

Derzeit würden zudem mehrere Programme zur Erweiterung des Anwendungsbereichs von MTIA laufen, einschließlich der Unterstützung von GenAI-Workloads.

Meta hat auch die Software-Ebene optimiert und Triton-MTIA entwickelt, einen Low-Level-Compiler mit Backend, der laut Meta "hochperformanten Code" für die MTIA-Hardware generiert.

Erste Ergebnisse zeigen laut Meta, dass der neue Chip bei vier wichtigen Modellen die Leistung im Vergleich zur ersten Chip-Generation bereits verdreifacht hat. Da Meta den gesamten Stack kontrolliert, kann im Vergleich zu kommerziellen GPUs eine höhere Effizienz erreicht werden.

Der neue Chip kann die Abhängigkeit von Meta von Nvidia-Grafikkarten, mit denen KI-Modelle nicht nur betrieben, sondern auch trainiert werden, in einigen Bereichen verringern, aber nicht ersetzen.

Meta-CEO Mark Zuckerberg kündigte kürzlich an, bis Ende des Jahres 340.000 Nvidia H100-GPUs und insgesamt rund 600.000 Grafikkarten im Einsatz zu haben. Damit gehört Meta zu den größten Kunden von Nvidia.

Neben Meta investiert auch Google in die Entwicklung eigener KI-Chips. Der Tech-Konzern stellte gerade eben erst mit TPU v5p eine neue Version vor, die mehr als doppelt so viele FLOPS und dreimal so viel Hochgeschwindigkeitsspeicher wie die Vorgängergeneration bietet. Der Google-Chip ist ein Allzweck-KI-Prozessor, der Training, Feinabstimmung und Inferenz unterstützt.