Meta stellt neue Forschung zu Künstlicher Intelligenz für realistisches Metaverse-Audio vor. Multimodal trainierte Audiosysteme sollen visuelle Informationen auswerten und Klänge automatisch passend formen.

Metas Forschungslabor Reality Labs stellt gemeinsam mit der Universität von Texas neue KI-Modelle vor, die den Klang in VR und AR anhand von Bilddaten optimieren sollen. KI sei für eine realistische Klangqualität im Metaverse entscheidend, schreibt das Unternehmen.

Multimodale KI soll Klang auf Bild abgleichen

Meta veröffentlicht drei neue KI-Modelle als Open Source: Visuell-akustisches Abgleichen, visuell informierte Dereverberation (Hall reduzieren) und visuelle Stimme. Bei allen drei Modellen geht es letztlich darum, dass eine KI den Klang automatisch passend zu visuellen Informationen formt. Dieses multimodale Zusammenspiel von Audio, Video und Text steht bei der neu vorgestellten Forschung im Fokus.

"Bestehende KI-Modelle leisten gute Arbeit beim Verstehen von Bildern und werden immer besser beim Verstehen von Videos. Wenn wir jedoch neue, immersive Erlebnisse für AR und VR schaffen wollen, brauchen wir KI-Modelle, die multimodal sind - Modelle, die Audio-, Video- und Textsignale auf einmal verarbeiten und ein viel umfassenderes Verständnis der Umgebung schaffen können", schreibt Metas Forschungsteam.

Erkennt ein KI etwa, dass ein Klang aus einer Höhle kommt, kann sie automatisch einen passenden Hall hinzufügen (Visuell-akustisches Abgleichen). Ein Beispiel für visuell informierte Dereverberation ist, dass der Klang von vorhandenen Inhalten dem aktuellen Raum angepasst wird, anstatt nach dem Raum zu klingen, in dem der Inhalt ursprünglich aufgezeichnet wurde.

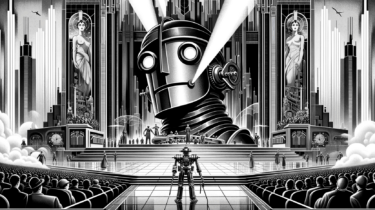

Die Klangkulisse einer aufgezeichneten Theateraufführung könne etwa so aufbereitet werden, als würde sie bei einer AR-Projektion live im aktuellen Raum inszeniert. Die KI soll dabei auch unerwünschte Hintergrundgeräusche aus der Originaltonspur automatisch entfernen können.

Bessere Konzerterlebnisse im Metaverse

Ein weiteres Anwendungsbeispiel ist laut Meta ein virtueller Konzertbesuch. Im Metaverse könnten Avatare zunächst dumpfe Klänge vor der Konzerthalle hören, die immer klarer werden, umso näher sie der Bühne kommen.

Der Metaverse-Trick: Dialoge könnten trotz der zunehmenden Umgebungslautstärke deutlich hörbar bleiben, so als würde man ohne laute Hintergrundmusik nebeneinander stehen. KI-Audio könne zudem das Audio etwa rund um Kleingruppen fokussieren, sodass sich Stimmen nicht gegenseitig überlagern (visuelle Stimme).

Im Zusammenspiel könnten diese Audiosysteme eines Tages zusätzlich "intelligente Assistenten" befähigen, besser zu verstehen, was wir ihnen sagen - selbst auf einem lauten Konzert oder einer Party.

Meta veröffentlicht die drei KI-Modelle als Open Source. Paper, Modelle und weitere Informationen sind in Metas AI Blog verfügbar.