Metas neue Bild-KI macht KI-Grafik besser kontrollierbar

Meta zeigt ein KI-System, das Menschen mehr Kontrolle über ihre KI-Kunst geben soll. Endstation: Metaverse.

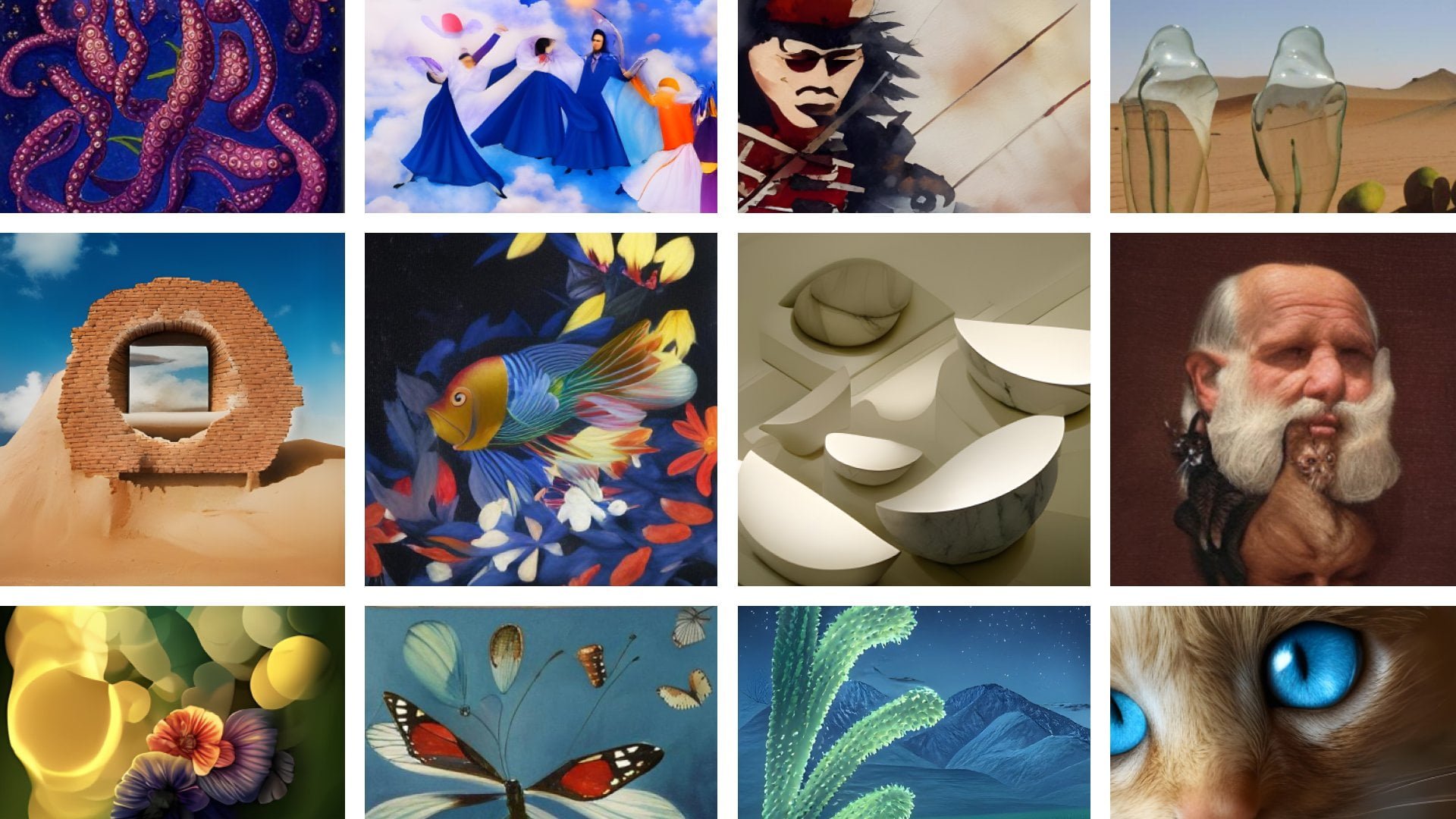

KI-generierte Bilder ziehen seit Jahren ihre Kreise durch das Netz. Waren es vor wenigen Jahren noch primär GAN-basierte Systeme, die täuschend echte Katzen oder Menschen generieren, sind es heute multimodale Modelle, die gezielte Kreationen per Texteingabe erlauben. Nutzer:innen von DALL-E 2, Midjourney und Craiyon (ehemals DALL-E mini) fluten Twitter, Instagram und andere Kanäle mit Bildideen.

Die konkrete Kontrolle über diese Systeme ist jedoch häufig recht eingeschränkt: Text eingeben und auf Bilder warten - das war es. Mit manchen Systemen können Varianten interessanter Ergebnisse erzeugt werden. DALL-Es Kreativität kann zudem gezielt auf einzelne Stellen in einem bereits vorhandenen Bild gelenkt werden, um diesen Ausschnitt zu verändern. In einem eigentlich leeren Pool erscheint dann etwa ein Flamingo. Das Thema KI für Bilder und Grafik besprechen wir ausführlich im Podcast.

Meta experimentiert mit Text plus Skizze

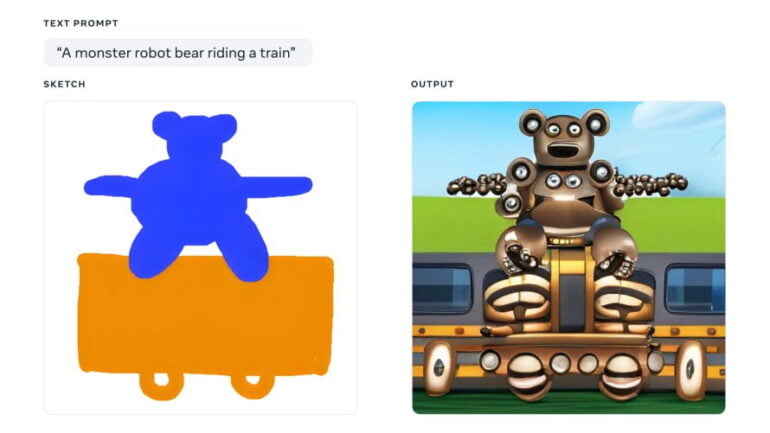

In einer neuen Arbeit zeigen Meta-Forschende nun ein multimodales KI-System, das eine gezieltere Bild-Generierung erlaubt. Nutzer:innen können "Make-A-Scene" mit einem Sketch füttern und anschließend per Texteingabe den Generierungsprozess starten.

Während bei anderen KI-Systemen die Ergebnisse oft schwer vorhersehbar seien, könnten Menschen ihre Vision mit Make-A-Scene gezielt umsetzen, schreibt Meta.

Video: Meta

In der Skizze muss dafür das grundlegende Szenen-Layout festgelegt werden. Die Texteingabe füllt das Gerüst dann mit KI-Kreationen. Das Modell könne zudem auch eigene Layouts per Texteingabe erstellen - damit geben Nutzer:innen allerdings einen Teil der Kontrolle wieder ab.

Für Meta ist Make-A-Scene ein Schritt hin zu gezielterer KI-Kreation

Laut Meta haben einige Künstler:innen testweise Zugang zu Make-A-Scene erhalten. Einer der Entwickler hat das System mit seinen Kindern getestet, um etwa Monster-Bären auf Zügen fahren zu lassen. Eine Veröffentlichung ist vorerst nicht geplant: Für Meta ist Make-A-Scene ein Experiment in der KI-Kreativität mit Fokus auf Nutzersteuerung.

Um das Potenzial von KI zur Förderung kreativen Ausdrucks zu nutzen, müssten Menschen in der Lage sein, die vom System generierten Inhalte zu gestalten und zu kontrollieren, schreibt Meta. Dafür müsse ein entsprechendes System intuitiv und einfach zu bedienen sein - mit Sprache, Text, Skizzen, Gesten oder Augenbewegungen.

Meta erhofft sich dank KI-Hilfe eine neue Gattung digitaler Kreativ-Werkzeuge, die vielen Menschen ausdrucksstarke Botschaften in 2D, XR und virtuellen Welten ermögliche.

KI-News ohne Hype – von Menschen kuratiert

Mit dem THE‑DECODER‑Abo liest du werbefrei und wirst Teil unserer Community: Diskutiere im Kommentarsystem, erhalte unseren wöchentlichen KI‑Newsletter, 6× im Jahr den „KI Radar"‑Frontier‑Newsletter mit den neuesten Entwicklungen aus der Spitze der KI‑Forschung, bis zu 25 % Rabatt auf KI Pro‑Events und Zugriff auf das komplette Archiv der letzten zehn Jahre.

Jetzt abonnierenKI-News ohne Hype

Von Menschen kuratiert.

- Mehr als 20 Prozent Launch-Rabatt.

- Lesen ohne Ablenkung – keine Google-Werbebanner.

- Zugang zum Kommentarsystem und Austausch mit der Community.

- Wöchentlicher KI-Newsletter.

- 6× jährlich: „KI Radar“ – Deep-Dives zu den wichtigsten KI-Themen.

- Bis zu 25 % Rabatt auf KI Pro Online-Events.

- Zugang zum kompletten Archiv der letzten zehn Jahre.

- Die neuesten KI‑Infos von The Decoder – klar und auf den Punkt.