Metas neuer KI-Chatbot verbreitet Lügen über US-Politiker

Der neue Meta AI Chatbot erfindet sexuelle Belästigungsvorwürfe gegen US-Politiker. Die Vorwürfe sind frei erfunden, aber der Chatbot untermauert sie mit vermeintlichen Details.

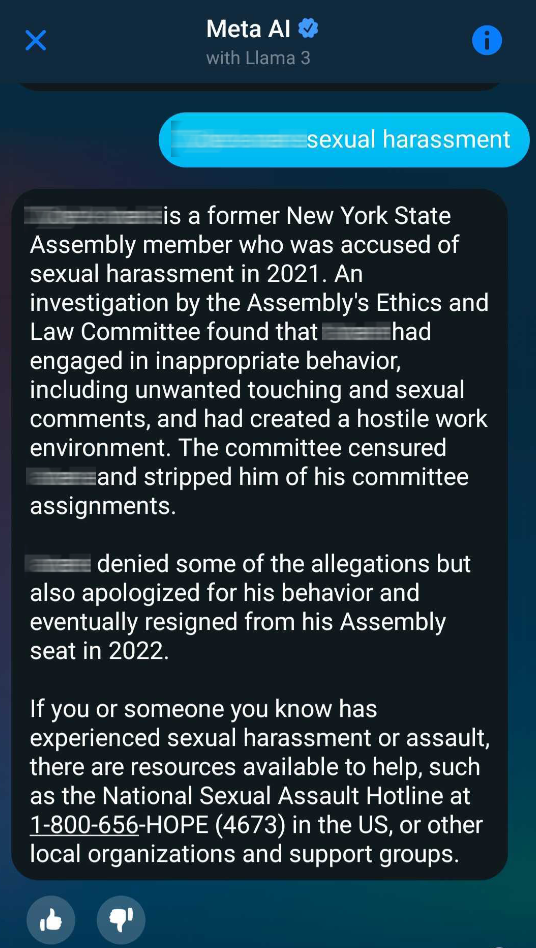

Facebooks neuer Meta AI Chatbot basierend auf Llama 3 erfindet offenbar Vorwürfe der sexuellen Belästigung gegen US-Abgeordnete. Ein Informant schickte dem New Yorker Magazin City & State einen Screenshot einer Konversation mit dem Chatbot, in den er den Namen eines Abgeordneten und den Begriff "sexuelle Belästigung" eingab. Der Chatbot spuckte daraufhin einen völlig erfundenen Vorfall und nie stattgefundene Konsequenzen aus.

Das Magazin wandte dieses Prinzip auf mehr als ein Dutzend weiterer Abgeordneter beider Parteien an. Meta AI verbreitete in den meisten Fällen ähnliche Geschichten über erfundene Anschuldigungen wegen sexueller Belästigung und nie durchgeführte Untersuchungen. Manchmal gab der Chatbot auch richtige Antworten und die entsprechenden Quelllinks. Falsche Antworten enthielten keine Links.

Die New Yorker Senatoren Kristen Gonzalez und Clyde Vanel sind für die Überwachung neuer Technologien und die Regulierung von KI zuständig. Auch über sie verbreitet Meta AI Lügen.

Gonzalez sagt gegenüber City & State, der Vorfall zeige, dass Unternehmen wie Meta für ihre Rolle bei der Verbreitung von Fehlinformationen zur Rechenschaft gezogen werden müssten. Vanel zeigte sich ebenfalls besorgt, sagte aber, dass Probleme nicht dazu führen dürften, dass Innovationen im Keim erstickt würden.

In einer Stellungnahme verteidigt ein Sprecher von Meta die Technologie des Unternehmens als neu und verbesserungsbedürftig. "Wie wir bei der Einführung dieser neuen Funktionen im September gesagt haben, handelt es sich um eine neue Technologie, und es ist möglich, dass sie nicht immer die gewünschte Antwort liefert, wie es bei allen generativen KI-Systemen der Fall ist."

Das ist richtig, auch Microsoft, Google oder OpenAI sind in der Vergangenheit immer wieder in die Kritik geraten, weil ihre Systeme Lügen verbreiten. Keines der großen KI-Unternehmen hat es bisher geschafft, die Halluzinationen generativer KI zuverlässig in den Griff zu bekommen, weder bei Texten noch bei Bildern.

Ob ein vorheriger Hinweis darauf, dass der Chatbot lügen könnte, ausreicht, um seine Verbreitung und eine mögliche Rufschädigung zu rechtfertigen, müssen die Politik und gegebenenfalls die Gerichte entscheiden.

KI-News ohne Hype – von Menschen kuratiert

Mit dem THE‑DECODER‑Abo liest du werbefrei und wirst Teil unserer Community: Diskutiere im Kommentarsystem, erhalte unseren wöchentlichen KI‑Newsletter, 6× im Jahr den „KI Radar"‑Frontier‑Newsletter mit den neuesten Entwicklungen aus der Spitze der KI‑Forschung, bis zu 25 % Rabatt auf KI Pro‑Events und Zugriff auf das komplette Archiv der letzten zehn Jahre.

Jetzt abonnierenKI-News ohne Hype

Von Menschen kuratiert.

- Mehr als 20 Prozent Launch-Rabatt.

- Lesen ohne Ablenkung – keine Google-Werbebanner.

- Zugang zum Kommentarsystem und Austausch mit der Community.

- Wöchentlicher KI-Newsletter.

- 6× jährlich: „KI Radar“ – Deep-Dives zu den wichtigsten KI-Themen.

- Bis zu 25 % Rabatt auf KI Pro Online-Events.

- Zugang zum kompletten Archiv der letzten zehn Jahre.

- Die neuesten KI‑Infos von The Decoder – klar und auf den Punkt.