Mit LIMA stellen die KI-Forscherinnen und -Forscher von Meta ein neues Sprachmodell vor, das mit wenigen Beispielen so genau lernen soll, dass es in Testszenarien das Niveau von GPT-4 oder Bard erreicht.

LIMA steht für "Less is More for Alignment", was die Funktion des Modells schon im Namen andeutet: Es soll zeigen, dass bei einem umfassend vortrainierten KI-Modell wenige Beispiele ausreichen, um qualitativ hochwertige Generierungen zu erreichen.

Wenige Beispiele bedeutet in diesem Fall: Meta hat manuell 1.000 variantenreiche Prompts und deren Output aus Quellen wie anderen Forschungsarbeiten, WikiHow, StackExchange und Reddit ausgewählt.

Mit diesen Beispielen verfeinerte das Team dann sein eigenes 65-Milliarden-Parameter-Modell LLaMA, jenes geleakte Sprachmodell, das die Open-Source-Bewegung für Sprachmodelle auslöste. Meta verzichtete vollständig auf das teure RLHF, das OpenAI für das Alignment seiner Modelle verwendet und als wichtigen Bestandteil der KI-Zukunft sieht.

Stil über Substanz

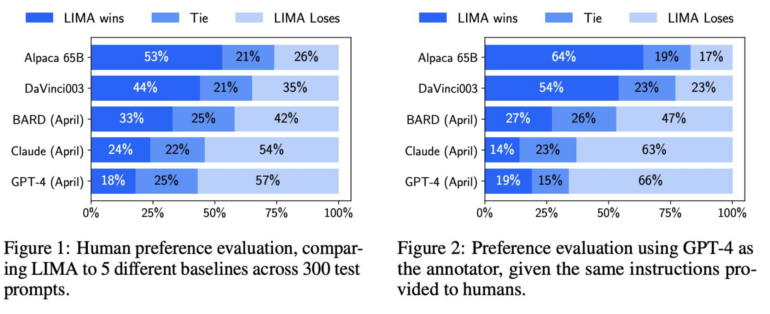

Meta ließ Menschen die Ausgaben von LIMA und anderen Modellen vergleichen, darunter GPT-4, text-davinci-003 und Google Bard. Laut Meta bevorzugten die menschlichen Bewerter bei 200 Beispielen in 43 Prozent der Fälle die Antworten von Lima gegenüber denen von GPT-4. Lima übertrifft Google Bard in 58 Prozent der Fälle, text-davinci-003 in 65 Prozent der Fälle. Alle diese gegnerischen Modelle wurden durch menschliches Feedback verfeinert.

Das Meta-Forschungsteam geht davon aus, dass diese Ergebnisse darauf hindeuten, dass ein Sprachmodell einen großen Teil seines Wissens durch Vortraining erwirbt und dass ein eher begrenztes Feintuning mit wenigen Beispielen ausreicht, um "Modellen beizubringen, qualitativ hochwertige Inhalte zu generieren".

Das aufwendige Training mit menschlichem Feedback, das bei OpenAI zum Einsatz kommt, wäre demnach nicht so wichtig wie bisher angenommen. Ein Punkt, den Meta in seinem Forschungspapier hervorhebt.

Die "Superficial Alignment"-Hypothese

Das Meta-Forschungsteam definiert diesen Befund als "Superficial Alignment Hypothesis". Sie besagt, dass es in der sogenannten Alignment-Phase nach dem Vortraining in erster Linie darum geht, dem Modell einen bestimmten Stil oder ein bestimmtes Format beizubringen, das es in der Interaktion mit den Nutzer/innen abrufen kann.

Das Feintuning bezieht sich also eher auf den Stil als auf den Inhalt. Dies stünde im Widerspruch zur gängigen Praxis besonders umfangreicher und komplexer Feinabstimmungsprozesse wie OpenAIs RLHF.

Das Meta-Forschungsteam sieht zwei Einschränkungen bei LIMA: Zum einen sei der Aufbau von Datensätzen mit hochwertigen Beispielen ein anspruchsvoller und kaum skalierbarer Ansatz. Zum anderen sei LIMA nicht so robust wie bereits als Produkt verfügbare Modelle wie GPT-4.

LIMA generiere zwar meist gute Antworten, aber eine ungünstige Aufforderung oder ein schlechtes Beispiel könnten zu schwachen Antworten führen. Dennoch zeige Lima, dass das komplexe Problem der Ausrichtung und Feinabstimmung eines KI-Modells mit einem einfachen Ansatz gelöst werden könne.

Dieser relativen Abwertung des Aufwands hinter GPT-4 und ähnlichen Modellen begegnet Metas KI-Chef Yann LeCun auf Twitter pragmatisch: Große Sprachmodelle seien ein Element primär der nahen Zukunft, würden aber mittelfristig keine Rolle spielen, jedenfalls nicht "ohne wesentliche Änderungen".