Metas neues vielseitiges Bildmodell erzielt Bestwerte auf lizenzierten Daten

Das neueste Bildmodell von Meta, CM3leon, kann sowohl Text als auch Bilder verstehen und erzeugen. Es kann Bilder aus Textbeschreibungen erzeugen und umgekehrt, Text aus Bildern, was es für viele Aufgaben nützlich macht.

CM3leon (ausgesprochen "Chamäleon") ist ein einziges Basismodell, das sowohl Text zu Bild als auch Bild zu Text erzeugen kann. Es ist das erste multimodale Modell, das mit einem von reinen Text-Sprachmodellen abgeleiteten Rezept trainiert wurde und sowohl Text als auch Bilder eingeben und erzeugen kann.

Die Architektur von CM3Leon verwendet ein Decoder-Only Tokenizer-basiertes Transformer-Netzwerk, ähnlich wie bei textbasierten Modellen. Es baut auf früheren Arbeiten (RA-CM3) auf und verwendet während des Trainings eine externe Datenbank mittels "Retrieval Augmentation".

Während andere Modelle nur aus den Rohdaten lernen, die ihnen zur Verfügung gestellt werden, suchen Modelle mit Retrieval-Augmentation während des Trainings aktiv nach den relevantesten und vielfältigsten Daten für ihren Lernprozess, wodurch die Trainingsphase robuster und effizienter wird.

Meta gibt an, dass es nur ein Fünftel dker Rechenleistung bestehender Transformer-basierter Bildmethoden benötigt und mit weniger Trainingsdaten auskommt, sodass CM3Leon genauso effizient trainiert werden kann wie bestehende Diffusion-basierte Modelle.

Ein Multitasking-Chamäleon

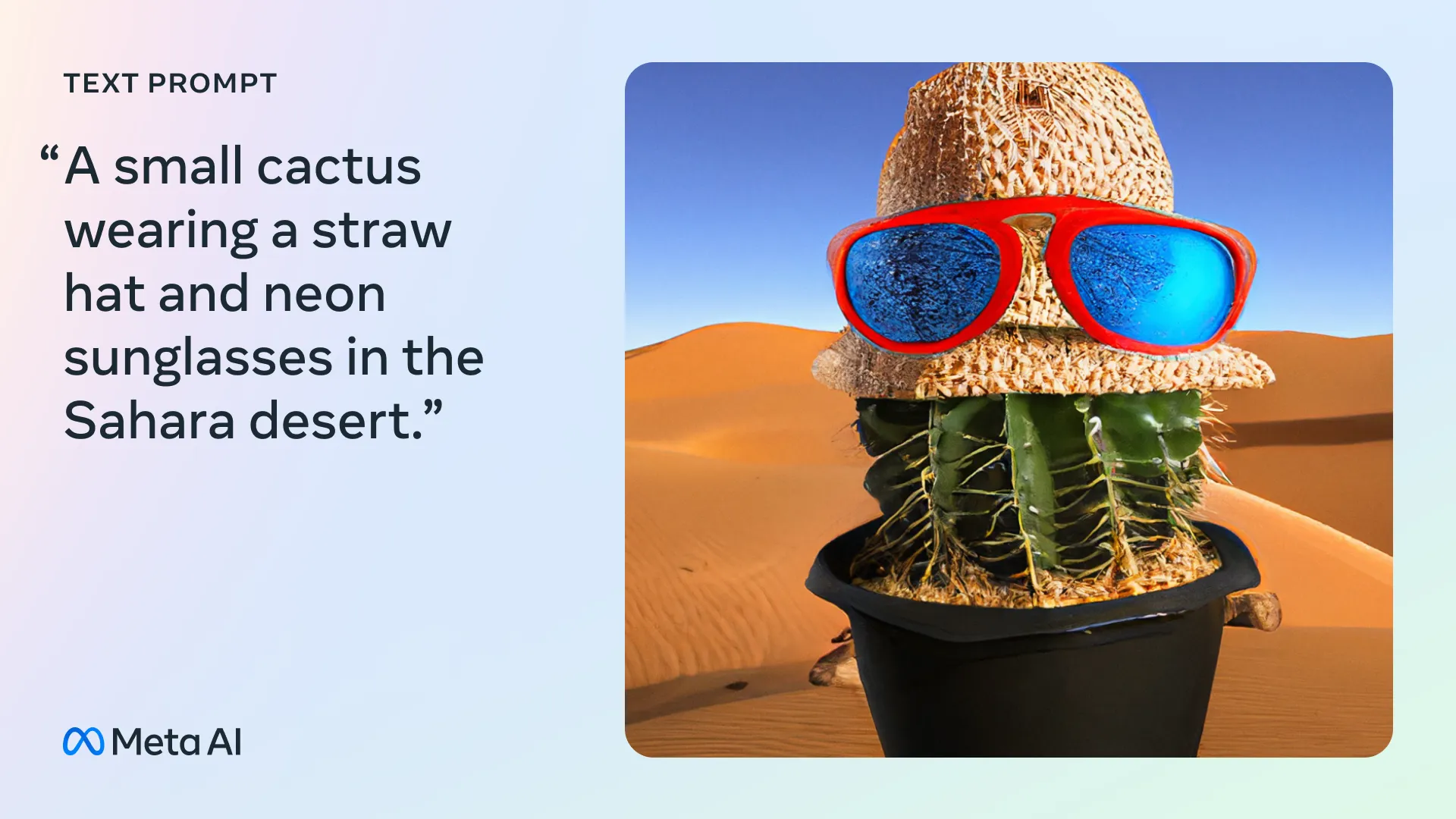

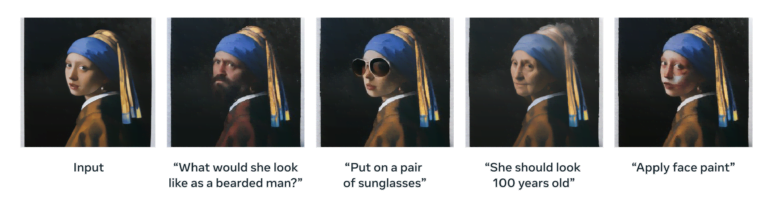

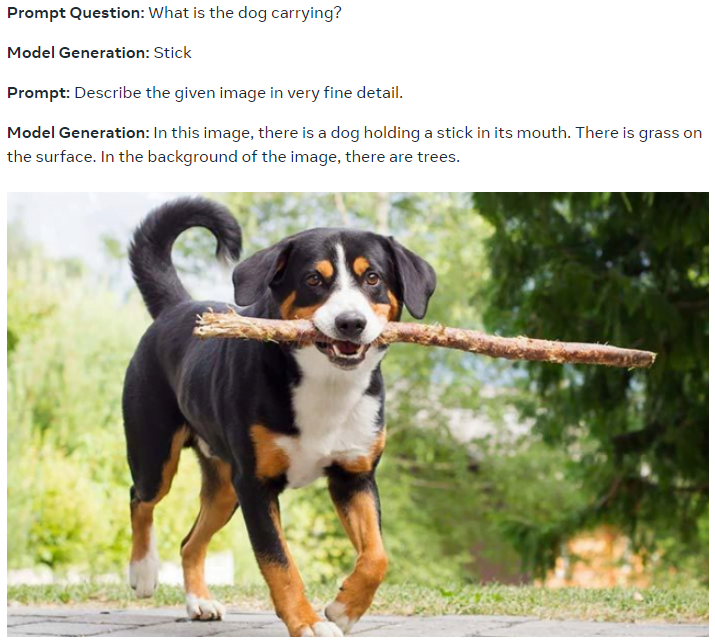

Durch ein umfassendes Multitasking Instruktionstraining ist CM3leon in der Lage, eine Vielzahl von Aufgaben auszuführen, einschließlich textgeführter Bildgenerierung und -bearbeitung, Text-zu-Bild-Generierung, textgeführter Bildbearbeitung, Generierung von Bildunterschriften, visueller Frage-Antwort und strukturgeführter Bildbearbeitung.

Training mit Anweisungen bedeutet, dass das Modell darauf trainiert wird, Anweisungen im Textformat zu befolgen. Beispielsweise kann eine Anweisung wie "Beschreibe ein Bild eines Sonnenuntergangs über dem Meer" eingegeben werden, und das KI-Modell erstellt eine Beschreibung auf der Grundlage dieser Anweisung. Das Modell wurde mit vielen solcher Beispiele für die oben genannten Aufgaben trainiert.

Laut Meta können Skalierungsmethoden, die für reine Textmodelle entwickelt wurden, direkt auf tokenisierungsbasierte Bilderzeugungsmodelle verallgemeinert werden, was noch bessere Ergebnisse mit größeren Modellen impliziert, die länger auf mehr Daten trainiert wurden.

Das Training von CM3leon bestand aus einer umfangreichen Retrieval-erweiterten Pre-Trainingsphase auf großen Datenmengen, gefolgt von einer überwachten Feinabstimmung (SFT) mit Instruktionen, um die Multitasking-Fähigkeiten zu erhalten.

CM3leon erreicht im Zero-Shot MS-COCO Benchmark eine Fréchet Inception Distance (FID) von 4.88, was einen neuen Rekord darstellt und das Google Parti Image Model übertrifft.

Mehr Kohärenz, mehr Lizenz, mehr Metaversum

Laut Meta zeichnet sich CM3leon dadurch aus, dass es kohärente Bilder erzeugt, die selbst komplexen Eingabeanweisungen besser folgen. Es kann globale Formen und lokale Details besser wiedergeben, Text oder Zahlen so generieren, wie sie im Prompt erscheinen, und Aufgaben wie die textgeführte Bildbearbeitung lösen, für die bisher spezielle Modelle wie Instruct Pix2Pix erforderlich waren.

Es kann auch detaillierte Beschriftungen für Bilder schreiben, sozusagen eine Art Reverse Prompting, die dann für die weitere Bilderstellung oder -bearbeitung oder für die Erstellung synthetischer Trainingsdatensätze verwendet werden können. Laut Meta ist CM3leon Flamingo und OpenFlamingo bei Textaufgaben ebenbürtig oder sogar überlegen, obwohl es auf weniger Text (3 Milliarden Text-Token) trainiert wurde.

Bemerkenswert ist, dass Meta angibt, dass das Modell auf einem "neuen, großen Shutterstock-Datensatz trainiert wurde, der nur lizenzierte Bild- und Textdaten enthält", aber dennoch im Vergleich zu anderen Modellen sehr konkurrenzfähig ist.

"Das Ergebnis ist, dass wir Probleme mit Bildrechten und der Zuordnung von Bildern vermeiden können, ohne die Leistung zu beeinträchtigen", schreibt das Forscherteam.

Laut Meta ist CM3leon ein Schritt in Richtung hochauflösende Bilderzeugung und -verstehen, der den Weg für multimodale Sprachmodelle ebnet. Meta glaubt weiterhin an das Metaverse und sagt, dass Modelle wie CM3leon "letztendlich die Kreativität fördern und bessere Anwendungen im Metaverse ermöglichen könnten."

KI-News ohne Hype – von Menschen kuratiert

Mit dem THE‑DECODER‑Abo liest du werbefrei und wirst Teil unserer Community: Diskutiere im Kommentarsystem, erhalte unseren wöchentlichen KI‑Newsletter, 6× im Jahr den „KI Radar"‑Frontier‑Newsletter mit den neuesten Entwicklungen aus der Spitze der KI‑Forschung, bis zu 25 % Rabatt auf KI Pro‑Events und Zugriff auf das komplette Archiv der letzten zehn Jahre.

Jetzt abonnierenKI-News ohne Hype

Von Menschen kuratiert.

- Mehr als 20 Prozent Launch-Rabatt.

- Lesen ohne Ablenkung – keine Google-Werbebanner.

- Zugang zum Kommentarsystem und Austausch mit der Community.

- Wöchentlicher KI-Newsletter.

- 6× jährlich: „KI Radar“ – Deep-Dives zu den wichtigsten KI-Themen.

- Bis zu 25 % Rabatt auf KI Pro Online-Events.

- Zugang zum kompletten Archiv der letzten zehn Jahre.

- Die neuesten KI‑Infos von The Decoder – klar und auf den Punkt.