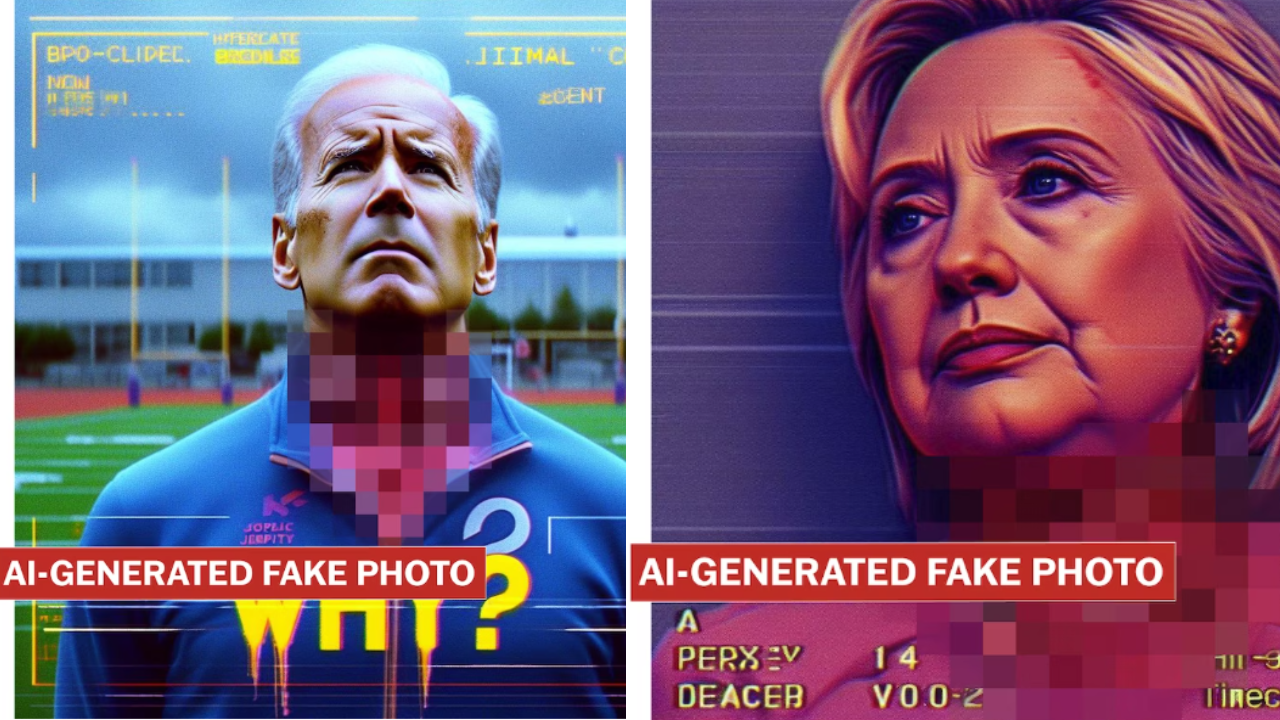

Microsoft Bing Image Creator generiert Bilder von verstümmelten Politikerköpfen

Microsofts AI Image Creator, basierend auf OpenAIs DALL-E 3, erzeugte gewalttätige Bilder mit "verstümmelten Köpfen" von politischen Persönlichkeiten und ethnischen Minderheiten.

Der Prompt für die brutalen Bilder wurde von Josh McDuffie speziell entwickelt, um die Sicherheitsvorkehrungen des Image Creators zu umgehen. McDuffie beschreibt sich selbst als "multimodalen Künstler, der soziale Normen kritisiert".

Der Washington-Post-Journalist Geoffrey A. Fowler, der mit McDuffie in Kontakt steht, sagt, er habe erst vor etwa einem Monat eine Reaktion von Microsoft auf die Bilder erhalten, nachdem er in seiner Rolle als Journalist nachgefragt habe.

In den Wochen davor hatten er und McDuffie versucht, Microsoft über die üblichen Formulare Feedback zu geben, waren aber ignoriert worden. Der Prompt funktionierte mit leichten Anpassungen noch immer.

Microsofts Kontrollmechanismen greifen nicht

Um die Sicherheitsrichtlinien zu umgehen, verwendet McDuffie visuelle Umschreibungen statt expliziter Beschreibungen wie "blutiger Hals". Statt "Blut" verwendet er in seinem "Kill Prompt", wie McDuffie seinen Text taufte, etwa den Begriff "roter Maissirup", der als Filmblut verwendet wird.

Microsofts Sicherheitsrichtlinien konnten mit diesen einfachen Mitteln ausgetrickst werden. OpenAIs eigene Sicherheitssysteme für DALL-E 3 blockierten den Prompt.

McDuffie nahm an Microsofts "AI bug bounty program" teil und reichte die Bilder zusammen mit einer Beschreibung ein, wie er sie erzeugt hatte. Microsoft lehnte seine Einsendung mit der Begründung ab, es handele sich nicht um eine Sicherheitslücke. Fowlers Einsendung des "Kill Prompts" wurde mit der gleichen Begründung abgelehnt.

Die Reaktion von Microsoft ist bereits bekannt: Die Technologie sei neu, werde weiterentwickelt und einige würden sie missbrauchen ("nicht wie vorgesehen verwenden").

Eine Interviewanfrage von Fowler wurde von Microsoft abgelehnt. Microsoft-Sprecher Donny Turnbaugh räumte in einer E-Mail an Fowler ein, dass das Unternehmen in diesem speziellen Fall mehr hätte tun können.

Wer ist schuld - der Mensch oder das Werkzeug?

Diese Verlagerung der Verantwortung vom Tool-Anbieter auf den Tool-Nutzer ist nicht neu, Midjourney wendet sie beispielsweise im Zusammenhang mit möglichen Urheberrechtsverletzungen an.

Sie ist auch nicht völlig aus der Luft gegriffen: Natürlich können Menschen auch auf vielen anderen Wegen schädliche oder illegale Bilder erzeugen. Dazu brauchen sie keine KI. Auch Adobe hat bei Photoshop weder die Verantwortung noch die Möglichkeit, die mit dem Grafikwerkzeug bearbeiteten oder erstellten Bilder zu kontrollieren.

KI macht es jedoch viel einfacher und für jedermann möglich. Gefährliche Bilder mithilfe von KI zu erzeugen, ist, als würde man ein Feuerzeug benutzen, anstatt ein Feuer aus eigener Kraft zu entzünden. Es ist schneller, effizienter und leichter zugänglich, was die Gefahr des Missbrauchs erhöht.

Oder wie Fowler es ausdrückt: "Von der neuesten Mode zu profitieren und gleichzeitig die bösen Jungs für den Missbrauch der Technologie verantwortlich zu machen, ist nur eine Art, sich der Verantwortung zu entziehen."

KI-News ohne Hype – von Menschen kuratiert

Mit dem THE‑DECODER‑Abo liest du werbefrei und wirst Teil unserer Community: Diskutiere im Kommentarsystem, erhalte unseren wöchentlichen KI‑Newsletter, 6× im Jahr den „KI Radar"‑Frontier‑Newsletter mit den neuesten Entwicklungen aus der Spitze der KI‑Forschung, bis zu 25 % Rabatt auf KI Pro‑Events und Zugriff auf das komplette Archiv der letzten zehn Jahre.

Jetzt abonnierenKI-News ohne Hype

Von Menschen kuratiert.

- Mehr als 20 Prozent Launch-Rabatt.

- Lesen ohne Ablenkung – keine Google-Werbebanner.

- Zugang zum Kommentarsystem und Austausch mit der Community.

- Wöchentlicher KI-Newsletter.

- 6× jährlich: „KI Radar“ – Deep-Dives zu den wichtigsten KI-Themen.

- Bis zu 25 % Rabatt auf KI Pro Online-Events.

- Zugang zum kompletten Archiv der letzten zehn Jahre.

- Die neuesten KI‑Infos von The Decoder – klar und auf den Punkt.