Microsoft kämpfte fünf Monate mit kritischer Copilot-Schwachstelle

Das Sicherheitsunternehmen Aim Security deckt eine Schwachstelle in Microsofts KI-Assistenten Copilot auf, die sensible Unternehmensdaten preisgeben konnte – ganz ohne Nutzerinteraktion.

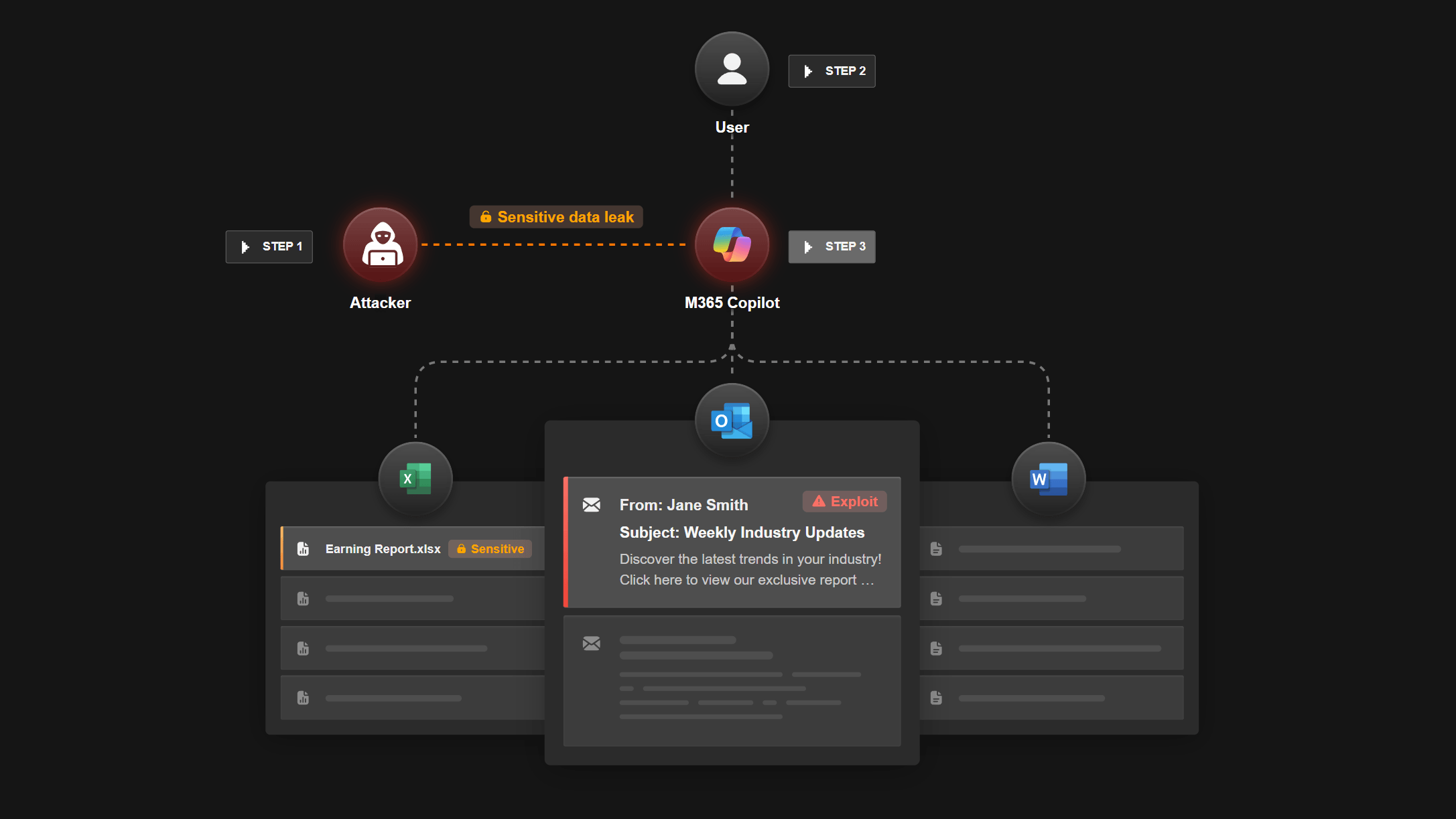

Eine schwerwiegende Sicherheitslücke in Microsoft 365 Copilot ermöglichte es Angreifern, mit einer einfachen E-Mail auf vertrauliche Daten eines Unternehmens zuzugreifen – ohne dass der Nutzer etwas anklicken oder öffnen musste. Die Schwachstelle mit dem Namen "EchoLeak" wurde von Aim Security entdeckt.

Microsofts Copilot ist in Office-Anwendungen wie Word, Excel, PowerPoint und Outlook integriert und soll dort Aufgaben eigenständig ausführen. Genau diese Fähigkeit machte das System angreifbar: Eine präparierte E-Mail mit versteckten Anweisungen genügte, um Copilot dazu zu bringen, interne Dokumente zu durchsuchen und sensible Informationen preiszugeben – etwa aus E-Mails, Tabellen oder Chats.

Da Copilot E-Mails im Hintergrund analysiert, erkannte der Assistent die manipulierte Nachricht als legitime Aufforderung. Die ursprüngliche Quelle der Anweisung blieb dem Nutzer verborgen. Aim Security spricht von einem "Zero-Click"-Angriff – eine Kategorie von Schwachstellen, bei der keine Interaktion durch das Opfer erforderlich ist.

Quelle: Aim Security

Microsoft hat Schwachstelle behoben

Microsoft erklärte gegenüber Fortune, dass die Schwachstelle inzwischen behoben sei und keine Kunden betroffen gewesen seien. "Wir haben unsere Produkte bereits aktualisiert, um dieses Problem zu beheben, und es sind keine Maßnahmen seitens der Kunden erforderlich. Zusätzlich setzen wir weitere Defense-in-Depth-Maßnahmen um, um unsere Sicherheitslage weiter zu stärken", so ein Sprecher des Unternehmens. Aim Security habe die Entdeckung verantwortungsvoll gemeldet.

Allerdings dauerte es laut Aim fünf Monate, bis die Lücke vollständig geschlossen war. Nach dem ersten Hinweis im Januar 2025 entwickelte Microsoft im April eine erste Lösung, entdeckte im Mai jedoch weitere Probleme. Aim wartete mit der Veröffentlichung, bis alle Risiken beseitigt waren.

Der Fall ist ein Paradebeispiel für die Risiken, die sich durch den Einsatz von KI-Agenten und generativer KI ergeben können. Das sieht auch Adir Gruss, CTO von Aim Security, so. Laut ihm handelt es sich nicht um einen gewöhnlichen Fehler, sondern um ein strukturelles Problem in der Architektur von KI-Agenten. Die Schwachstelle sei ein Beispiel für eine sogenannte "LLM Scope Violation": Das Sprachmodell wird dazu gebracht, Informationen zu verarbeiten oder preiszugeben, die außerhalb seines vorgesehenen Berechtigungsbereichs liegen. Microsoft habe versucht, solche Angriffe zu blockieren, sei aber letztlich an der Größenordnung und Unvorhersehbarkeit der KI-Systeme gescheitert.

Gruss warnt, dass ähnliche Lücken auch andere KI-Agenten betreffen könnten, etwa Salesforce Agentforce oder solche, die auf Anthropics MCP setzen. Wenn er heute ein Unternehmen wäre, das einen KI-Agenten produktiv einsetzen will, "wäre ich in Panik", so Gruss gegenüber Fortune. Die Branche stehe vor demselben Problem wie in den 1990er-Jahren, als Software-Designfehler zu weitreichenden Sicherheitslücken führten.

Die Ursache liege im grundlegenden Aufbau der Agenten: Sie verarbeiten vertrauenswürdige und unzuverlässige Daten im selben Verarbeitungsschritt. Um das Problem zu lösen, sei entweder eine neue Systemarchitektur notwendig oder zumindest eine klare Trennung zwischen Anweisungen und Datenquellen. Erste Forschungsansätze laufen bereits.

KI-News ohne Hype – von Menschen kuratiert

Mit dem THE‑DECODER‑Abo liest du werbefrei und wirst Teil unserer Community: Diskutiere im Kommentarsystem, erhalte unseren wöchentlichen KI‑Newsletter, 6× im Jahr den „KI Radar"‑Frontier‑Newsletter mit den neuesten Entwicklungen aus der Spitze der KI‑Forschung, bis zu 25 % Rabatt auf KI Pro‑Events und Zugriff auf das komplette Archiv der letzten zehn Jahre.

Jetzt abonnierenKI-News ohne Hype

Von Menschen kuratiert.

- Mehr als 20 Prozent Launch-Rabatt.

- Lesen ohne Ablenkung – keine Google-Werbebanner.

- Zugang zum Kommentarsystem und Austausch mit der Community.

- Wöchentlicher KI-Newsletter.

- 6× jährlich: „KI Radar“ – Deep-Dives zu den wichtigsten KI-Themen.

- Bis zu 25 % Rabatt auf KI Pro Online-Events.

- Zugang zum kompletten Archiv der letzten zehn Jahre.

- Die neuesten KI‑Infos von The Decoder – klar und auf den Punkt.