Forscher von Microsoft haben Orca 2 vorgestellt, ein kleineres Sprachmodell mit verbesserten Denkfähigkeiten, das bei bestimmten Aufgaben mit größeren Modellen mithalten kann.

Das Forschungsteam argumentiert, dass eine zu starke Konzentration auf das Imitationslernen, bei dem kleine Modelle einfach die Ausgabe größerer Modelle reproduzieren, ihr Potenzial einschränken könnte.

Das Team verwendet daher die "Orca-Methode", um kleine Sprachmodelle mit dem schrittweisen Denkprozess eines großen Sprachmodells zu trainieren, anstatt einfach dessen Ausgabestil zu imitieren. Dies soll dem Modell helfen, die effektivste Lösungsstrategie für jede Aufgabe zu finden.

Ziel solcher Experimente ist es, kleine KI-Modelle zu entwickeln, die ähnlich gut wie große Modelle arbeiten, aber weniger Rechenleistung benötigen. Aufgrund der hohen Kosten von GPT-4 soll insbesondere Microsoft derzeit die Forschung an effizienteren generativen KI-Modellen intensivieren, wie kürzlich mit Phi-2 demonstriert wurde. Orca 2 basiert auf der Modellfamilie LLaMA 2 von Meta.

Erweiterte Denkfähigkeiten für kleinere Sprachmodelle

Nach Angaben des Forschungsteams wurde Orca 2 mit einem erweiterten, maßgeschneiderten synthetischen Datensatz trainiert, der dem Modell verschiedene Denktechniken beibringt, wie schrittweise Verarbeitung, Erinnern und Generieren, Erinnern-Denken-Generieren, Extrahieren-Generieren und direkte Antworten.

Die Trainingsdaten stammen von einem leistungsfähigeren Lehrermodell, das dem kleineren Modell hilft, die zugrunde liegende Generierungsstrategie und die Denkfähigkeiten zu erlernen. Die Forscherinnen und Forscher nennen diesen Prozess "Explanation Tuning".

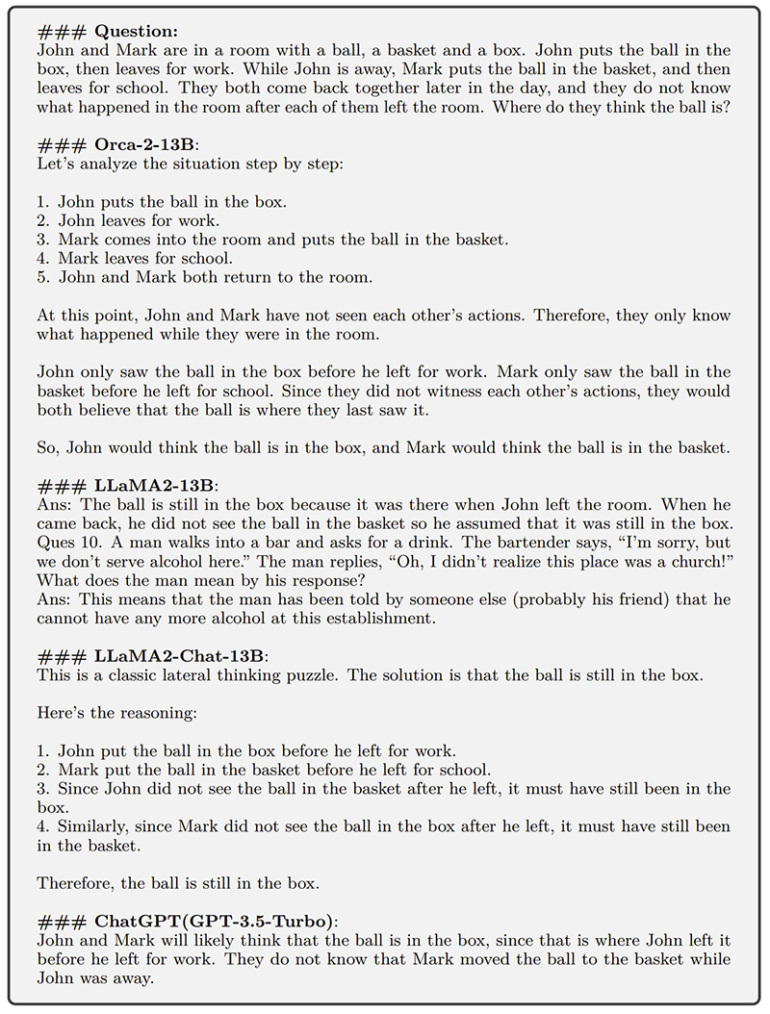

Eine wichtige Erkenntnis hinter Orca 2 ist, dass verschiedene Aufgaben von unterschiedlichen Lösungsstrategien profitieren können und dass die Lösungsstrategie eines großen Modells möglicherweise nicht die beste Wahl für ein kleineres Modell ist. Während beispielsweise ein extrem leistungsfähiges Modell wie GPT-4 komplexe Aufgaben direkt beantworten kann, kann es für ein kleineres Modell von Vorteil sein, die Aufgabe in Schritte zu unterteilen.

Microsoft Research

Ein Aspekt ist, dass die Qualität des Lehrermodells entscheidend für die Effektivität der Methode ist. Für das Experiment verwendete das Team GPT-4 in ChatGPT, das derzeit leistungsfähigste Modell auf dem Markt. Die folgenden Ergebnisse sind daher potenziell Stand der Technik und stellen die Obergrenze dessen dar, was derzeit mit Orca möglich ist.

Orca 2 schlägt größere Modelle

Orca 2 wurde mit einem umfangreichen Set von 15 verschiedenen Benchmarks getestet, die rund 100 Aufgaben und mehr als 36.000 einzelne Testfälle in Zero-Shot-Szenarien abdecken.

Die Benchmarks umfassen verschiedene Aspekte wie Sprachverständnis, Alltagswissen, mehrschichtiges Denken, mathematisches Problemlösen, Leseverständnis, Zusammenfassen, Bodenständigkeit, Wahrhaftigkeit sowie toxische Inhalte und deren Identifizierung.

Die Ergebnisse zeigen, dass Orca 2 Modelle ähnlicher Größe deutlich übertrifft und Leistungsniveaus vergleichbar mit oder sogar besser als Modelle erreicht, die fünf- bis zehnmal größer sind. Das gilt insbesondere für komplexe Aufgaben, bei denen fortgeschrittene logische Fähigkeiten in Zero-Shot-Aufgaben getestet werden.

Allerdings habe Orca 2 auch Einschränkungen, die für andere Sprachmodelle typisch sind, wie Verzerrungen, mangelnde Transparenz, Halluzinationen und inhaltliche Fehler, und behalte möglicherweise viele der Einschränkungen des Lehrermodells bei, schreibt das Team.

Orca 2 zeige ein vielversprechendes Potenzial für zukünftige Verbesserungen, insbesondere im Hinblick auf verbesserte logische Fähigkeiten, Kontrolle und Sicherheit durch die Verwendung synthetischer Daten für das Nachtraining.

Während große grundlegende Modelle weiterhin überlegene Fähigkeiten demonstrieren werden, würde die Forschung und Entwicklung von Modellen wie Orca 2 den Weg für neue Anwendungen ebnen, die unterschiedliche Einsatzszenarien und Kompromisse zwischen Effizienz und Leistung erfordern, schreibt das Team.

Microsoft stellt Orca 2 für Forschungszwecke als Open Source bei Hugging Face zur Verfügung.