Mit der iPhone-App Luma AI können NeRFs einfach erfasst und mit Kamerapfaden zu einem Video verarbeitet werden, für das sonst eine Drohne erforderlich wäre.

Luma AI ist im iPhone App Store erhältlich und macht die Aufnahme von NeRFs überraschend einfach. Ich umkreise ein Objekt einfach dreimal in verschiedenen Höhen und drehe dabei mein iPhone zur Mitte.

Die App erledigt den Rest und lädt das Bild auf die Server von Luma Labs hoch, wo die firmeneigene KI ein Neuronales Strahlungsfeld (NeRF) für mich erstellt. Ein ultraglatter Orbit um das NeRF kann als Video heruntergeladen werden, und ein 3D-Objekt mit Texturkarten kann innerhalb weniger Minuten erstellt werden. Das NeRF kann auch als interaktive Web-Ansicht veröffentlicht werden, sodass Freunde den Ort oder das Objekt, das man aufgenommen hat, erleben können.

Und das ist erst der Anfang.

Mit AR durch die Szene navigieren

Luma AI nimmt das Objekt auf, um das man sich dreht, und gleichzeitig den Hintergrund. Wenn ich die Anwendung zum ersten Mal öffne, sehe ich eine Galerie von NeRFs, die ich bereits aufgenommen habe. Durch Tippen auf ein beliebiges Miniaturbild gelangt man in die Cinematic Render-Ansicht, die normalerweise eine langsame Drehung um das Objekt darstellt.

Wenn ich auf die AR-Schaltfläche oben rechts tippe, wird das NeRF in meinem physischen Raum platziert. Ich sehe entweder das extrahierte zentrale Objekt, das auf meinem Boden liegt, oder die gesamte NeRF-Szene, die meinen Raum ausfüllt.

Um zwischen diesen Ansichten zu wechseln, tippe ich auf die Schaltfläche "Hintergrund" unten rechts. Es ist, als wäre mein iPhone ein Fenster zu dem Ort, an dem ich die NeRF aufgenommen habe. Das Twitter-Video von Luma Lab zeigt die AR-Funktion.

✨ Announcing Luma AR! Starting today, you can teleport back into your memories like you were there again. Reshoot to create natural camera moves 🎥 in captured worlds, again and again, all from your iPhone!

Capture. NeRF. AR. Just like that! https://t.co/xOpUhZC161#ar #nerf… pic.twitter.com/1TgFiTODLJ

— Luma AI (@LumaLabsAI) March 21, 2023

In meinen Beispielen sehe ich die Bäume, das Moos, die Blätter und die Felsen durch mein Handy. Ich kann auch durch die AR-Szene gehen, indem ich mein iPhone anhebe oder nach unten greife, um sie aus einem niedrigeren Winkel zu betrachten. Es ist, als wäre ich wieder auf dem Waldweg.

Am schnellsten geht das, wenn ich die Aufnahmetaste am unteren Rand des Bildschirms drücke und beginne, mich durch die AR-Szene zu bewegen. Ich muss keine Angst haben, dass ich gegen Bäume pralle und meine Drohne abstürzt. Allerdings muss ich auf meine Umgebung achten, da mein physischer Raum nicht mit der NeRF-Umgebung übereinstimmt.

Ein lustiger Effekt ist es, die Szene oder das Objekt größer oder kleiner zu machen, als es in Wirklichkeit ist. Wenn ich die NeRF viel größer mache, als sie in Wirklichkeit ist, kann ich mich darin wie eine Maus bewegen, über moosige Stellen springen und mich unter hohen Wurzeln verstecken.

Als nächstes verkleinere ich den NeRF Waldpfad um die Hälfte, so dass meine relative Größe etwa 12 Fuß (3,66 m) beträgt. Meine Bewegungen erscheinen doppelt so schnell, was es erleichtert, eine schnelle Drohne zu simulieren.

Ich ziehe das NeRF in die Mitte meines Raumes und markiere mit einer Flasche Erdnüsse die Position eines zentralen Baumes als Referenz. Dann drücke ich den Aufnahmeknopf und fange an, mein iPhone um den Baum herumfliegen zu lassen, um die Bewegungen einer Drohne zu simulieren. Diesen Prozess durchlaufe ich mehrere Male, bis ich eine Aufnahme habe, die mir gefällt.

Nach der Aufnahme drücke ich erneut auf den Auslöser. Das Video wird sofort gespeichert, aber nicht stabilisiert. Stattdessen klicke ich auf die Schaltfläche Neu aufnehmen und dann auf den Zauberstab unten links. Jetzt kann ich auswählen, wie stark die Stabilisierung sein soll. Die Bearbeitung des Videos dauert einige Minuten, aber in der Zwischenzeit kann ich weitere Videos erstellen.

Das Erstellen von Videos, die aussehen, als wären sie mit einer Drohne gefilmt worden, geht so schnell, dass ich gleich mehrere gemacht habe. Der Perfektionist in mir ist immer noch unzufrieden, also gehe ich zu einer kontrollierteren Methode über, um eine Kamerafahrt aufzunehmen.

Keyframes ermöglichen die Feinabstimmung

Um die volle Kontrolle über den Flugpfad zu haben, kann ich ein NeRF aus der Galerie öffnen und auf Neue Aufnahme und dann auf Benutzerdefiniert tippen. Dies führt mich zu einem Kamerapfad-Editor, ähnlich wie in einer 3D-Animationsanwendung.

Das Schlüsselkonzept, das man verstehen sollte, sind die Keyframes. Ich kann meinen Blickpunkt an eine neue Position bewegen und dann auf die Schaltfläche "Keyframe hinzufügen" tippen, um diese Position festzuhalten. Ich ziehe und drücke, um eine andere Position und einen neuen Kamerawinkel einzunehmen, und klicke dann auf den Plus-Button auf der rechten Seite, um einen weiteren Keyframe hinzuzufügen.

Luma AI platziert die Keyframes im Abstand von zwei Sekunden, und wenn ich auf die Wiedergabetaste drücke, sehe ich, wie die virtuelle Kamera sanft zwischen diesen beiden Punkten hin und her gleitet.

Ich füge weitere Keyframes hinzu, um eine Flugbahn wie bei einer Drohne zu erzeugen. Im Vergleich zum Laufen und Bewegen meines iPhones im AR-Modus ist das mühsam, aber mit Keyframes ist mehr Präzision möglich.

Durch Ziehen der violetten, rautenförmigen Keyframes unter der Kameraansicht kann ich das Timing feinabstimmen. Mit dem Stoppuhrsymbol kann ich die Gesamtlänge anpassen, um das gesamte Video zu beschleunigen oder zu verlangsamen.

Wenn ich auf den Reiter "Übersicht" am oberen Bildschirmrand tippe, sehe ich den Kamerapfad als violette Linie mit blauen Kamerasymbolen an jeder Keyframe-Position. Auf dem iPhone ist dies nur als Visualisierung nützlich. Wenn ich die Web-App öffne, kann ich die Kamerasymbole in den Übersichtsmodus ziehen, um ihre Positionen und Winkel zu ändern und die Bewegung zu glätten.

Es gibt noch viele andere Optionen, aber das ist der grundlegende Prozess. Wenn ich mit meinem Flugweg zufrieden bin, benutze ich die Optionen am unteren Bildschirmrand, um die Auflösung und das Seitenverhältnis einzustellen, den NeRF-Hintergrund ein- oder auszuschalten und andere Einstellungen vorzunehmen.

Der letzte Schritt besteht darin, auf die Schaltfläche "Render" zu klicken und zu warten. Um das Video zu erstellen, lädt Luma AI die Daten auf die Server von Luma Labs hoch. Für das Rendern wird das iPhone nicht benötigt. Du kannst die App schließen, ein weiteres NeRF aufnehmen oder an anderen Animationen arbeiten.

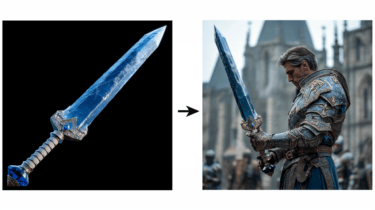

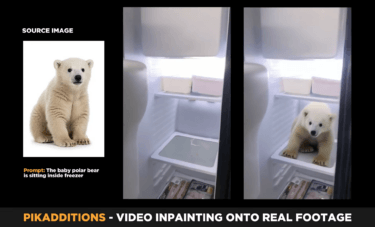

Wenn der Rendering-Prozess abgeschlossen ist, kann ich das Video herunterladen, um es als Teil eines längeren Videos zu verwenden oder es so zu teilen, wie es ist. Professionelle Videofilmer können NeRF-Videos mit realen Videos kombinieren, um die Vielseitigkeit von KI-generierten Bildern mit realistischen Aufnahmen zu verbinden.

Das folgende Video von Jake Oleson wurde mit Luma AI erstellt und von Luma Labs in einem kürzlich veröffentlichten Blogbeitrag hervorgehoben. Das Video wurde bearbeitet, um mehrere NeRFs zu kombinieren. Es ist ein Beispiel dafür, was mit genügend Zeit und Kreativität möglich ist.

Die Grenzen von NeRFs

Da Luma AI NeRFs verwendet, sehe ich oft "Floater", das Äquivalent zu Rauschen oder Artefakten im KI-Modell. Wenn ich mich bei der Aufnahme der NeRFs langsam und gleichmäßig genug bewege, wird dieses Problem minimiert und die Details werden schärfer. Das ist in unebenem Gelände eine Herausforderung, aber die Mühe lohnt sich.

Beim Betrachten eines Luma AI NeRF oder beim Aufzeichnen einer Kamerafahrt für ein Video gibt es eine Grenze, wie weit und wohin man sich bewegen kann, ohne dass diese Verzerrungen den Realismus beeinträchtigen. Das wird sich mit der Weiterentwicklung der Technologie verbessern, und Luma Labs hat die Qualität schon jetzt erheblich gesteigert.

Je weiter ich mich vom Zentrum des NeRF entferne, desto mehr wird die Szene verzerrt und verschwommen, weil die Details fehlen. Der KI fehlen die räumlichen Informationen, um Objekte am Rand des Erfassungsbereichs originalgetreu zu rekonstruieren. Die Szene wird unübersichtlich, wenn man sich zu weit entfernt.

Es kann Spaß machen, das zu erforschen. In manchen Videos mache ich mir das zunutze, um einen Warp-Effekt zu erzeugen, der einem das Gefühl gibt, in eine andere Dimension zu reisen.

Aber beim Schneiden kann man sich in diesen verzerrten "Taschenwelten" verlieren. Wenn das passiert, gibt es eine einfache Lösung: Wenn ich auf einen Keyframe tippe, kann ich zu einer zusammenhängenden Sequenz zurückkehren und mit dem Schnitt fortfahren.

Luma AI macht NeRFs zugänglich

Neuronale Strahlungsfelder gibt es schon seit einigen Jahren, aber sie waren bisher schwer zu nutzen. Jetzt ist die Technologie endlich so zugänglich, dass sie von jedermann genutzt werden kann. Nvidias InstantNGP ist ein No-Code-Schritt in die richtige Richtung und ermöglichte eine schnelle Visualisierung auf einem Computer.

Luma Labs macht NeRFs fast so einfach wie das Aufnehmen eines Videos. Ich kann einen Moment dreidimensional festhalten und ihn später mit einer virtuellen Kamera jederzeit wieder als Video aufnehmen.

Die Möglichkeiten sind unbegrenzt. Wenn sich diese Technologie weiterentwickelt, werden NeRFs ein wertvolles Werkzeug für das Metaverse sein und die Erstellung von 3D-Objekten und Orten vereinfachen. Schon jetzt kann man NeRFs in VR betrachten, wenn man über einen kompatiblen Computer und ein Headset verfügt.