Menschen machen aus vielen Gründen Fotos, einer davon ist, Erinnerungen festzuhalten. Die nächste Generation von Erinnerungsfotos könnten NeRFs sein, die mit Zip-NeRF ein Qualitäts-Upgrade bei hoher Geschwindigkeit erhalten.

Forschende von Google zeigen Zip-NeRF, ein NeRF-Modell, das die Vorteile von Grid-basierten Verfahren und dem Mipmap-basierten mip-NeRF 360 kombiniert.

Grid-basierte NeRF-Verfahren wie Instant-NGP trainieren 3D-Szenen bis zu achtmal schneller als alternative NeRF-Verfahren, haben aber eine schlechtere Bildqualität, da die Gitter-Methode zu stärkerem Aliasing führt und Details im Bild verloren gehen können.

Mip-NeRF verarbeitet Subvolumina mit Tiefeninformationen statt eines Gitters. Dies ermöglicht mehr Bilddetails bei weniger Aliasing, aber die Trainingszeit für eine 3D-Szene kann mehrere Stunden betragen.

Das Beste aus zwei NeRF-Techniken

Die Google-Forscher haben jetzt eine Methode entwickelt, um die hohe Bildqualität von mip-NeRF mit der schnellen Trainingszeit von gitterbasierten Modellen zu kombinieren. Das Ergebnis sind qualitativ hochwertige 3D-Szenen mit weniger Aliasing, 8 Prozent bis 76 Prozent weniger Bildfehlern je nach Szene und einer 22-mal kürzeren Trainingszeit als bei mip-NeRF 360.

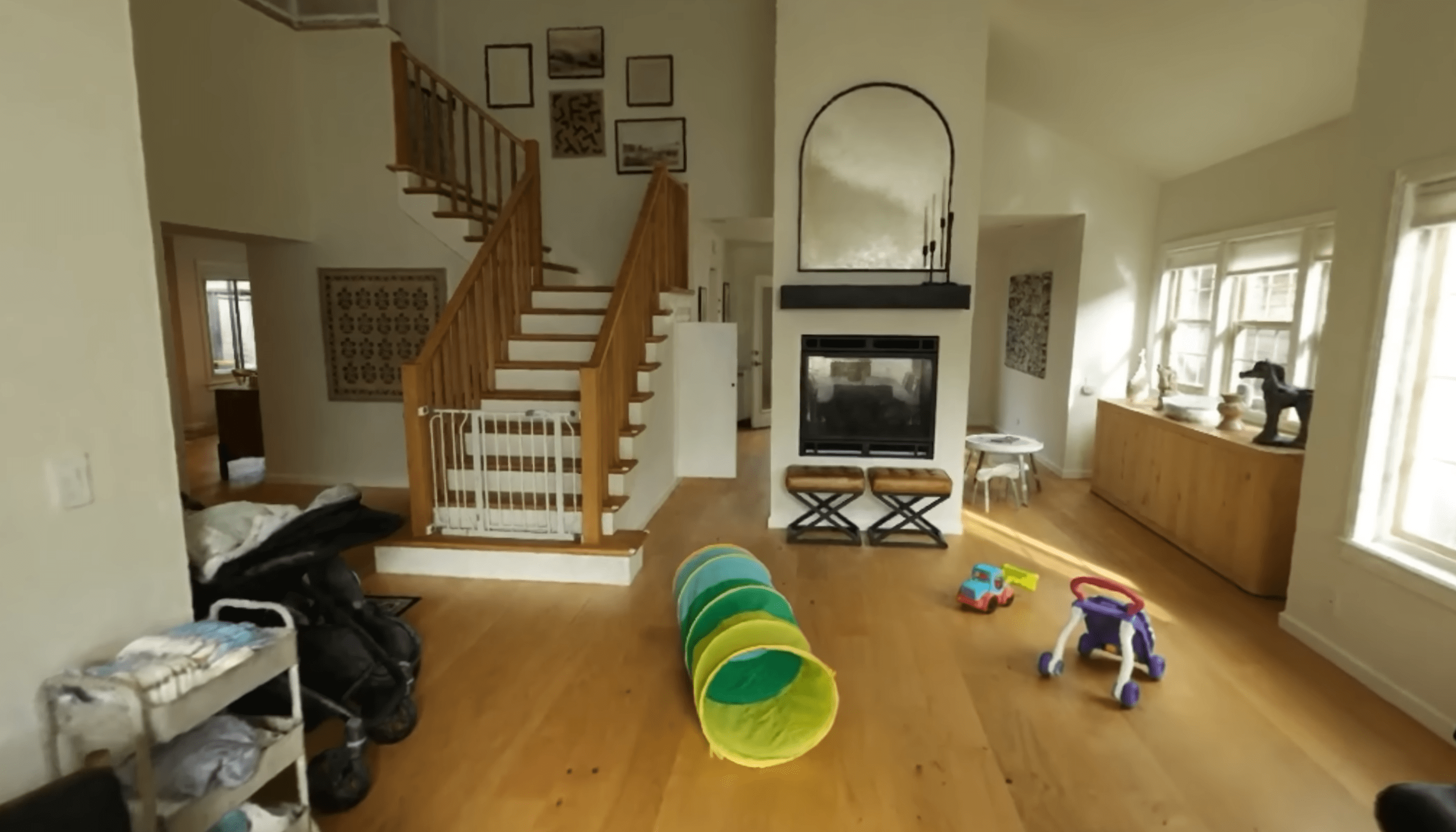

In Demos zeigt das Forschungsteam eindrucksvolle, umfangreiche 3D-NeRF-Szenen, die ein ganzes Haus samt Garten digital konservieren. Mit einer VR-Brille ist diese Szene in Originaldimensionen begehbar, ähnlich wie das reale Haus, allerdings statisch wie ein Foto. Die 3D-Szene setzt zip-NeRF im Trainingsprozess aus vielen einzelnen 2D-Fotos zusammen.

Mip-NeRF trainiert diese Szene in rund 22 Stunden, während Zip-NeRF nur mehr knapp eine Stunde benötigt bei gleichzeitig besserer Bildqualität. Eine alternative Kombination aus Mip-NeRF 360 und Instant NGP trainiert zwar circa dreimal schneller, hat aber eine deutlich schlechtere Bildqualität und Artefakte.

Zip-NeRF, Mip-NeRF 360 und die Vergleichsversion "mip-NeRF 360 + iNGP" wurden auf acht Nvidia Tesla V100-SXM2-16GB GPUs trainiert, andere Vergleichsmodelle teilweise nur auf einer einzelnen Nvidia 3090.

In unsere No-Code-Anleitung für Nvidia Instant-NGP erfahrt ihr, wie ihr ein eigenes NeRF erstellen könnt, und wie ihr dieses in VR ansehen könnt. Auch das Open-Source-Nerfstudio erleichtert den Einstieg in die NeRF-Produktion.

Mehr über Künstliche Intelligenz für Computergrafik gibt’s in unserem DEEP MINDS KI-Podcast zum Thema.