OpenAI hat GPT-4 als multimodales Modell mit Bildverstehen vorgestellt, aber die Bildfunktion noch nicht veröffentlicht. MiniGPT-4 macht sie als Open-Source-Modell verfügbar.

MiniGPT-4 ist ein Chatbot mit Bildverständnis, eine Funktion, die OpenAI zum Start von GPT-4 vorgestellt, aber noch nicht außerhalb der App "Be my Eyes" ausgerollt hat.

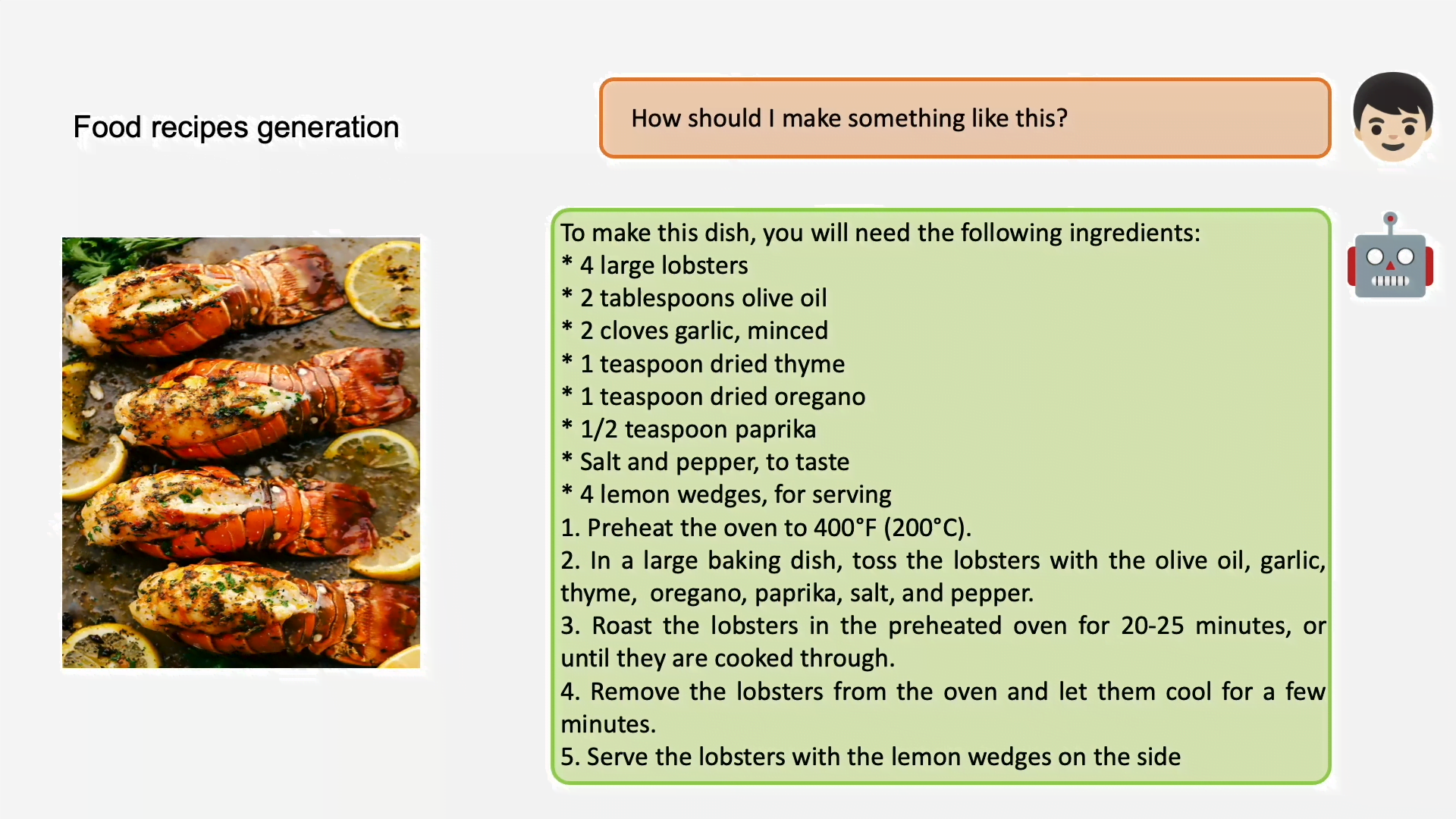

Wie sein großes Vorbild kann MiniGPT-4 Bilder beschreiben oder Fragen zum Inhalt eines Bildes beantworten: Bei einem Bild von einem zubereiteten Gericht kann das Modell etwa ein (möglicherweise) passendes Rezept ausgeben (siehe Titelbild) oder für sehbehinderte Menschen eine passende Bildbeschreibung generieren. Ebenso könnte MiniGPT-4 wie das neue "/describe"-Feature von Midjourney anhand von Bildern passende Prompts oder zumindest Ideen für Bildbeschreibungen liefern. OpenAIs viel beachtete Bild-zu-Webseite-Funktion bei der Vorstellung von GPT-4 soll MiniGPT-4 ebenfalls beherrschen.

"Unsere Ergebnisse zeigen, dass MiniGPT-4 viele ähnliche Fähigkeiten wie GPT-4 beherrscht, z. B. die Erstellung detaillierter Bildbeschreibungen und die Erstellung von Websites aus handschriftlichen Entwürfen", heißt es im Papier.

Das Entwicklungsteam stellt den Code, Demos und eine Anleitung für das Training von MiniGPT-4 auf Github zur Verfügung. Es kündigt auch eine kleinere Version des Modells an, die auf einer einzelnen Nvidia 3090 Grafikkarte laufen soll. Das folgende Demo-Video zeigt einige Beispiele.

Open-Source-KI ist auf dem Vormarsch

Das Erstaunliche an MiniGPT-4 ist, dass es auf Vicuna-13B LLM und dem BLIP-2 Vision Language Model basiert, also auf Open-Source-Software, die für vergleichsweise wenig Geld und ohne riesigen Daten- und Rechenaufwand trainiert und feinjustiert werden kann.

Das Forschungsteam trainierte MiniGPT-4 zunächst mit rund fünf Millionen Bild-Text-Paaren in zehn Stunden auf vier Nvidia A100-Karten. In einem zweiten Schritt wurde das Modell mit 3.500 qualitativ hochwertigen Text-Bild-Paaren verfeinert, die im Zusammenspiel von MiniGPT-4 und ChatGPT generiert wurden. ChatGPT korrigierte die von MiniGPT-4 generierten fehlerhaften oder ungenauen Bildbeschreibungen.

Fix the error in the given paragraph. Remove any repeating sentences, meaningless characters, not English sentences, and so on. Remove unnecessary repetition. Rewrite any incomplete sentences. Return directly the results without explanation. Return directly the input paragraph if it is already correct without explanation.

ChatGPT-Prompt für MiniGPT-4

Dieser zweite Schritt habe die Zuverlässigkeit und Anwendbarkeit des Modells deutlich verbessert - und erforderte nur ein siebenminütiges Training auf einer einzelnen Nvidia A100. Die Forschenden waren nach eigenen Angaben selbst von der Effizienz ihres Ansatzes überrascht.

Das Sprachmodell von MiniGPT-4 Vicuna folgt der „Alpaca-Formel“ und verwendet ChatGPT-Outputs, um ein Meta-Sprachmodell der LLaMA-Familie zu feintunen, das wiederum auf Augenhöhe mit Google Bard und ChatGPT agieren soll. Auch hier ist der Trainingsaufwand vergleichsweise überschaubar.

MiniGPT-4 ist ein weiteres Beispiel für die Fortschritte in der Open-Source-Community innerhalb kürzester Zeit. Es zeigt, dass der Burggraben für KI-Modellfirmen, wenn man ihn auf das reine Modell beschränkt, vielleicht gar nicht so hoch ist: Erst gestern startete der Open-Source-Chatbot OpenAssistant, der mit von Freiwilligen gesammelten Instruktionsdaten trainiert wurde und langfristig eine offene ChatGPT-Alternative werden soll.

Angesichts dieser Entwicklung wird sich OpenAI wahrscheinlich zunächst auf den Aufbau eines Partner-Ökosystems mithilfe von ChatGPT-Plugins für GPT-4 konzentrieren, anstatt bereits GPT-5 zu trainieren. Der Forschungs- und Trainingsaufwand für ein neues Modell könnte für OpenAI höher sein als der Vorsprung, den das Unternehmen damit gegenüber Konkurrenten oder der Open-Source-Community erzielen könnte. Im Vergleich dazu ist der Aufbau eines Chat-Ökosystems anspruchsvoller und wirtschaftlich nachhaltiger.