Mit nur einer Hand: OpenAI-Roboter löst den Zauberwürfel

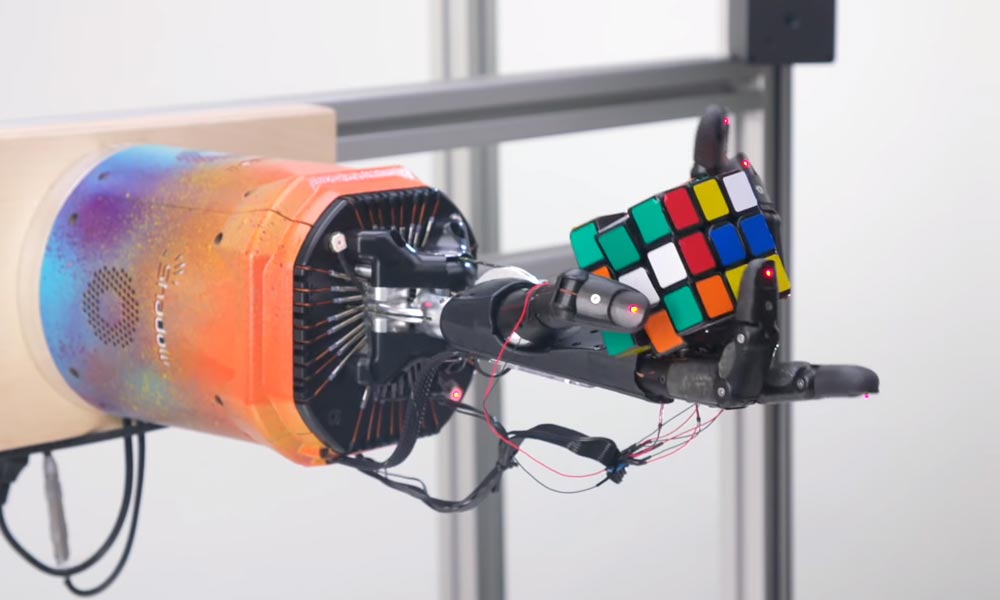

OpenAI stellt eine KI für eine Roboterhand vor, die den Zauberwürfel (Rubik's Cube) lösen kann. Einhändig verlangt das Puzzle sowohl Know-how als auch menschenähnliche Geschicklichkeit.

Die neue Forschungsarbeit von OpenAI basiert auf dem ersten Roboterhand-Experiment "Dactyl", das im vergangenen Sommer vorgestellt wurde. Fast hundert (vorgespulte) Jahre musste eine KI in einer Simulation üben, um einen Würfel einhändig in einer Roboterhand drehen zu können.

Zum Einsatz kam das sogenannte bestärkende Lernen: Drehte die Roboterhand-KI den Würfel mit der richtigen Seite nach oben, wurde sie belohnt.

Das Experiment verlief laut der Forscher überraschend erfolgreich: Die KI lernte ohne vorherige Programmierung eigenständig und allein in einer Simulation hochkomplexe menschliche Bewegungsabläufe, die anschließend auf einen realen Roboter übertragen werden konnten. Mehr als 6.000 Prozessoren waren für die Simulation notwendig.

Dactyl ist jetzt noch geschickter

Schon damals glaubten die Forscher, dass mit mehr Rechenleistung und Aufgabenvariation noch mehr Fingerfertigkeit in der Roboterhand steckt. Dieses Potenzial weisen sie jetzt nach.

Ausgangsbasis ist wie bei Dactyl die Spiele-KI "Five", die im komplexen Computerspiel Dota 2 ganze KI-Teams in die Schlacht führte und erstmals menschliche Profis besiegte.

Diese Übertragung funktioniert, vereinfacht gesagt, da die fünf Finger einer Hand für das neuronale Netz letztlich auch ein Team sind, das koordiniert werden muss.

Zufallssimulation macht die KI robust

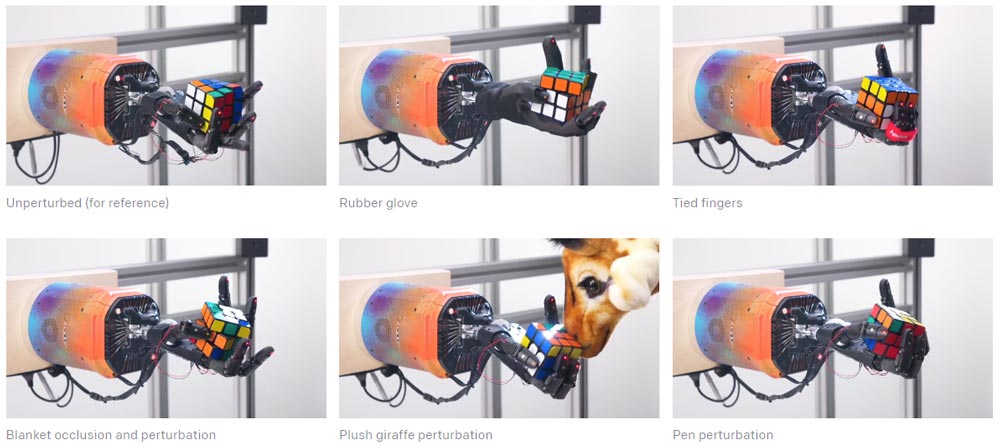

Die neue Version von Dactyl wurde ebenfalls vollständig in einer Computerumgebung trainiert. Die Innovation im Vergleich zum letzten Jahr ist der Ablauf der Simulation, die ausgehend von einem vorgegebenen Szenario ständig neue Simulationen erstellt.

Dabei variiert sie Faktoren wie Größe und Gewicht des Würfels oder die Schwerkraft. Hat die KI eine bestimmte Leistungsschwelle erreicht, wird der Schwierigkeitsgrad der Simulation angehoben.

Diese automatisierte permanente Veränderung der Trainingsumgebung, OpenAI nennt sie Automatic Domain Randomization (ADR), ersetzt laut der OpenAI-Forscher ein akkurates Modell der echten Welt: Die Ergebnisse können erfolgreich aus der Simulation auf einen echten Roboter übertragen werden.

Beim Training der ersten Version von Dactyl ging OpenAI auf die gleiche Weise vor, allerdings wurden die Änderungen an der Simulation manuell vorgenommen. Das automatisierte Training schneidet bei zunehmender Komplexität der Simulation deutlich besser ab: Laut OpenAI verdoppelt sich die Übertragungsleistung auf den echten Roboter im Vergleich zum von Menschen gesteuertem Simulationstraining.

Die KI ist so robust trainiert, dass sie den Zauberwürfel auch dann noch erfolgreich dreht und balanciert, wenn sie beispielsweise mit einem Stofftier gestört wird.

We’re all used to robots that fail when their environment changes unpredictably. Our robotic system is adaptable enough to handle unexpected situations not seen during training, such as being prodded by a stuffed giraffe: pic.twitter.com/wBoh1nt9Kv

— OpenAI (@OpenAI) October 15, 2019

Allerdings löst sie den Zauberwürfel bei maximalem Schwierigkeitsgrad (26 Rotationen) nur in 20 Prozent der Fälle erfolgreich. Bei einem etwas weniger verworrenen Ausgangspuzzle (15 Rotationen) gelingt ihr das Kunststück immerhin bei 60 Prozent der Versuche.

Als nicht erfolgreich gilt ein Versuch, wenn der Würfel herunterfällt oder ein Zeitlimit überschritten wird. Fällt der Würfel allerdings herunter, kann man ihn der Roboterhand wieder in die Hand legen und sie macht weiter, wo sie aufgehört hat.

Auf dem Weg zur generellen KI

Die Forscher bei OpenAI vermuten, dass der neue Ansatz fürs Simulationstraining die Fähigkeit einer KI stärkt, das Lernen zu lernen. Das sei eine wichtige Voraussetzung für die Schaffung einer generellen Künstlichen Intelligenz, die einmal antrainiertes Wissen in vielen Bereichen anwenden kann.

Der Algorithmus lerne in der randomisierten Simulationsumgebung, sich permanent anzupassen, schreiben die Forscher. Bei mehr als 10.000 Tests habe sich gezeigt, dass die KI bei Störungen den Würfel zuerst schlechter drehe, dann aber ihre Strategie auf die neue Situation adaptiere und nach weiterer Trainingszeit wieder ebenso erfolgreich agiert wie vor der Störung.

Die Wissenschaftler von OpenAI gehen davon aus, dass die maschinelle Abbildung menschlichen Geschicks ein wichtiger Meilenstein ist hin zu Allzweckrobotern. Sie kündigen weitere Forschungsarbeiten in diesem Bereich an.

KI-News ohne Hype – von Menschen kuratiert

Mit dem THE‑DECODER‑Abo liest du werbefrei und wirst Teil unserer Community: Diskutiere im Kommentarsystem, erhalte unseren wöchentlichen KI‑Newsletter, 6× im Jahr den „KI Radar"‑Frontier‑Newsletter mit den neuesten Entwicklungen aus der Spitze der KI‑Forschung, bis zu 25 % Rabatt auf KI Pro‑Events und Zugriff auf das komplette Archiv der letzten zehn Jahre.

Jetzt abonnierenKI-News ohne Hype

Von Menschen kuratiert.

- Mehr als 20 Prozent Launch-Rabatt.

- Lesen ohne Ablenkung – keine Google-Werbebanner.

- Zugang zum Kommentarsystem und Austausch mit der Community.

- Wöchentlicher KI-Newsletter.

- 6× jährlich: „KI Radar“ – Deep-Dives zu den wichtigsten KI-Themen.

- Bis zu 25 % Rabatt auf KI Pro Online-Events.

- Zugang zum kompletten Archiv der letzten zehn Jahre.

- Die neuesten KI‑Infos von The Decoder – klar und auf den Punkt.