Aleph Alphas Update macht KI-Ergebnisse der generativen KI-Modelle der Luminous-Familie nachvollziehbar. Das eröffnet neue Anwendungen auch in kritischen Bereichen.

Das deutsche KI-Start-up Aleph Alpha führt eine neue Funktion für die eigenen generativen KI-Modelle der Luminous-Familie ein, mit der KI-Ergebnisse nachvollziehbar und überprüfbar werden sollen.

Aktuelle generative KI-Modelle scheitern an "Explainable AI"

Während generative KI-Modelle wie ChatGPT oder GPT-4 gerade dabei sind, ganze Branchen zu verändern, haben sie ein großes Problem: Ihre Ergebnisse sind nicht nachvollziehbar - das macht sie in kritischen Bereichen wie der Medizin zwar weiter nützlich, birgt aber auch viele Gefahren.

Methoden der "Explainable AI" (XAI) versuchen daher, Synthesen nachvollziehbar und überprüfbar zu machen.

Anfang 2023 stellten Forschende des deutschen KI-Start-ups Aleph Alpha, der TU Darmstadt, des Forschungszentrums Hessian.AI und des Deutschen Forschungszentrums für Künstliche Intelligenz (DFKI) mit AtMan eine XAI-Methode vor, die die Ergebnisse solcher Transformer-basierten Modelle für Text und Bild erklärbar macht.

Luminous kann jetzt Ausgaben ohne vertrauenswürdige Quellen zurückhalten

AtMan ist nun für Luminous-Modelle verfügbar und kann laut Aleph Alpha auf Text und Bilder angewendet werden. Dies ist ein wichtiger Schritt hin zu mehr Erklärbarkeit und Nachvollziehbarkeit - eine regulatorische Anforderung an generative KI-Modelle, die mit dem EU AI Act wahrscheinlich bald kommen wird.

"Diese Transparenz wird den Einsatz generativer KI für kritische Aufgaben im Rechts-, Gesundheits-, und Bankenwesen ermöglichen – Bereiche, die in hohem Maße auf vertrauenswürdige und genaue Informationen angewiesen sind", so Jonas Andrulis, CEO und Gründer von Aleph Alpha.

Mit der neuen Funktion können laut Aleph Alpha inhaltliche Fakten in Modellausgaben nachvollziehbar hergeleitet werden, aber auch Ausgaben ohne entsprechende vertrauenswürdige Quellen direkt zurückgehalten werden.

"Unsere Kunden haben oft verifiziertes internes Wissen mit großem Wert. Wir können jetzt darauf aufsetzen und sicherstellen, dass eine KI-Assistenzfunktion nur dieses Wissen erfolgreich verwendet und stets Kontext liefert", so Andrulis.

Wie funktioniert AtMan?

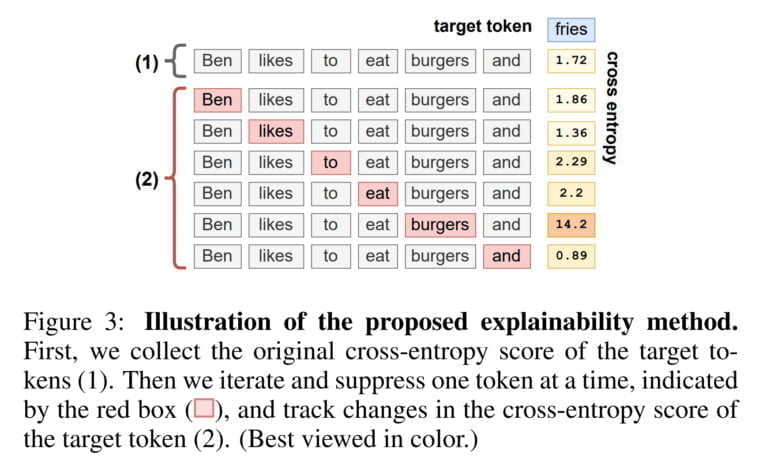

Aleph Alphas AtMan verwendet eine Perturbationsmethode, um den Einfluss eines Tokens auf die Generierung eines anderen Tokens zu analysieren. Dazu werden Störungen verwendet, um zu messen, wie sich die Synthese eines Tokens durch die Unterdrückung anderer Wörter verändert. Ein anschauliches Beispiel zeigt, wie der Satz „Ben isst gerne Burger und“ mit dem Wort „Pommes“ fortgesetzt wird.

Anhand des von AtMan berechneten Cross-Entropy-Wertes wird bestimmt, wie stark der Satz insgesamt die Generierung des Wortes "Pommes" beeinflusst hat. Anschließend wird jedes Wort systematisch unterdrückt, um zu sehen, wie sich der Cross-Entropy-Wert ändert. In diesem Beispiel steigt der Wert deutlich an, sobald das Wort „Burger“ unterdrückt wird. Die XAI-Methode identifiziert also erfolgreich das Wort, das den größten Einfluss auf die Synthese von „Pommes“ hat.

In Anbetracht der Tatsache, dass die Datenschutzbehörden der EU OpenAIs ChatGPT genauer unter die Lupe nehmen und der EU AI Act bevorsteht, wird das US-Unternehmen wahrscheinlich ähnliche Technologien übernehmen müssen, um sicherzustellen, dass die eigenen Modelle weiter auf dem EU-Markt verfügbar bleiben.